Init

This commit is contained in:

@@ -0,0 +1,103 @@

|

||||

## 前言

|

||||

本文仅为使用Ornatrix制作角色头发的流程笔记,只为记录制作流程。但因为本人非专职美术,没有分析过面片头发,也没有制作头发经验,所以本文仅供参考。

|

||||

## Ornatrix的优点

|

||||

插件目前支持max、maya、c4d。拥有大部分xGen的功能(我无法保证所有功能都有),除了制作头发之外,它还可以制作羽毛与编织物。以下是官方介绍视频:

|

||||

https://www.bilibili.com/video/av80061009

|

||||

|

||||

个人觉得优点有下:

|

||||

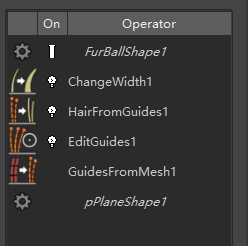

### 节点式的流程

|

||||

|

||||

|

||||

节点式流程就代表着流程是非线性的,这意味着你可以任意拖动节点位移或者可以随时对节点树中的节点进行修改,并预览效果。同时你可以把做成完成的头发保存为预设,下次再遇到相似的发型就可以直接使用了,以此加快制作进程。

|

||||

|

||||

### 各种使用节点

|

||||

梳理节点:

|

||||

你可以通过画几个箭头就完成对发型的大致梳理。

|

||||

|

||||

|

||||

|

||||

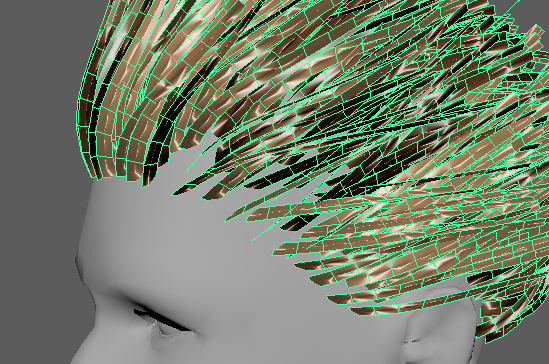

旋转节点:这个节点对于游戏面片头发的制作相当不错。另外Ornatrix可以设置生成面片的段数、UV等其他属性,这也是我放弃xGen转而使用Ornatrix的原因。

|

||||

|

||||

|

||||

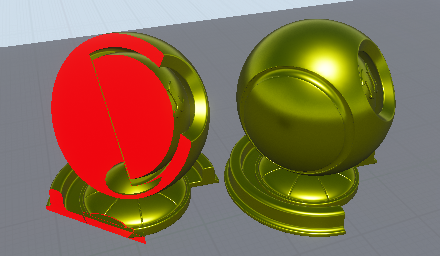

使用旋转节点前

|

||||

|

||||

|

||||

使用旋转节点后

|

||||

|

||||

另外还有Frizz、Curl等节点,出个大形的速度非常快。

|

||||

## EPIC模型分析

|

||||

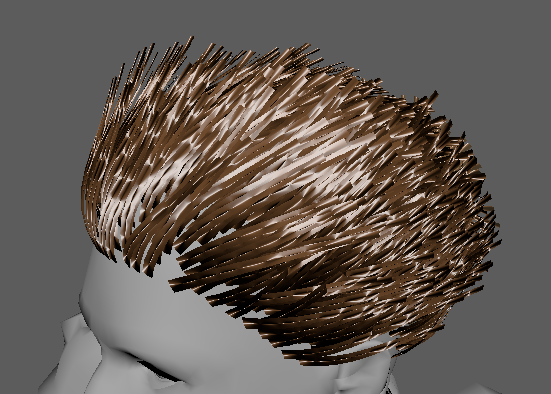

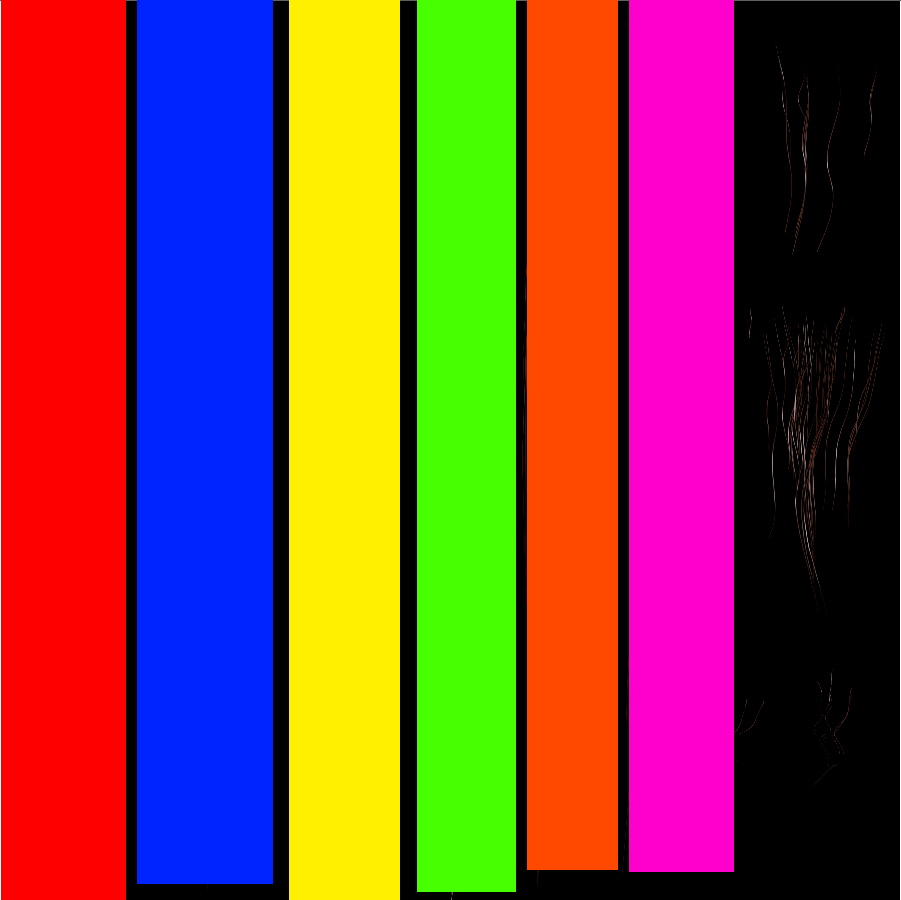

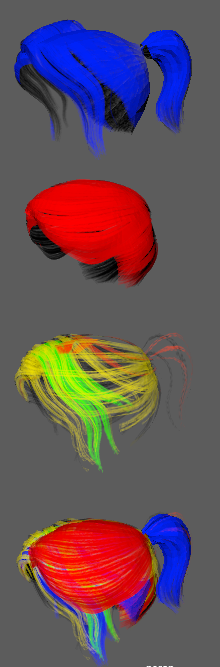

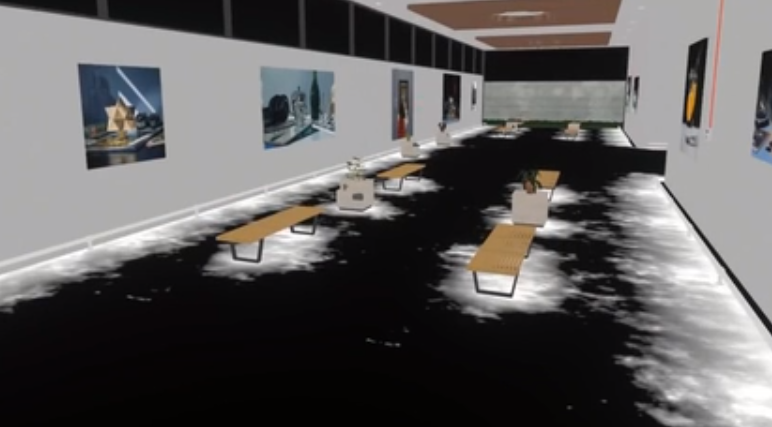

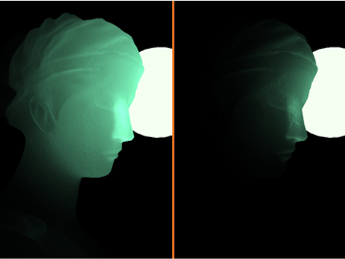

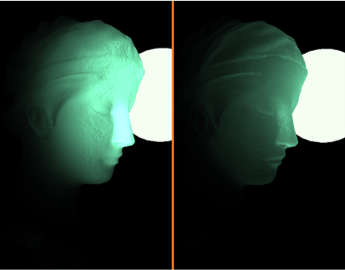

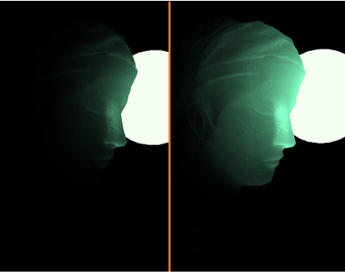

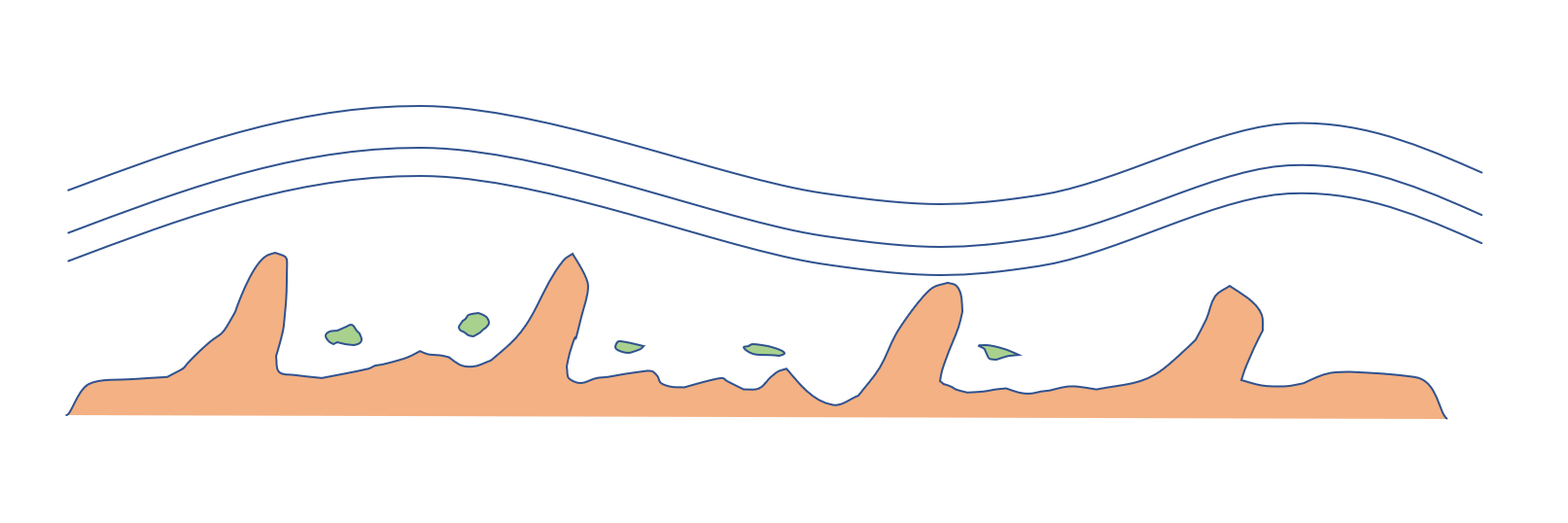

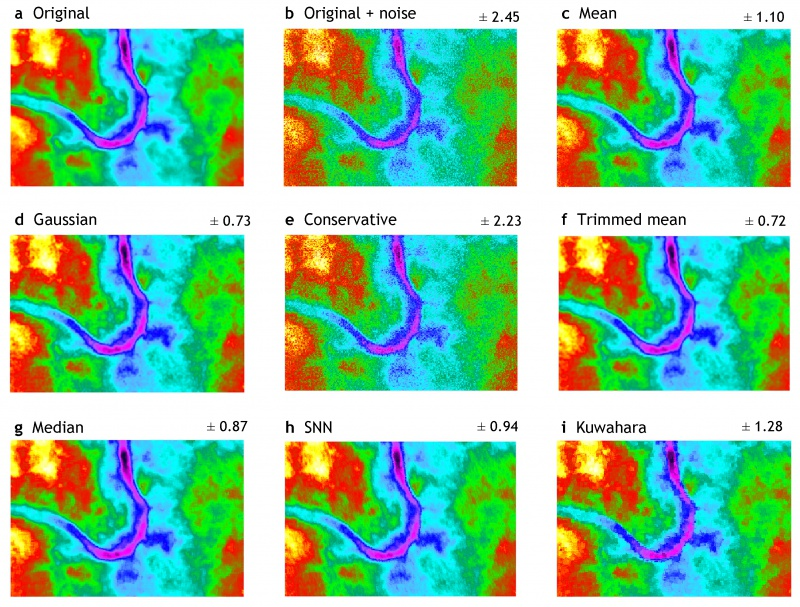

这里本人使用虚幻争霸中的一个角色作为参考,因为本人能力有限,所以使用官方提供的头发材质进行渲染。这样只需要制作出符合高度贴图、id贴图即可。这里我为了方便分析贴图所以给不同的头发进行填色,以此来判断头发组成。(因为本人不知道如何在Maya中解决透明排序的问题,所以结果就凑合地看吧)

|

||||

|

||||

|

||||

|

||||

- 红色为最底层的头发,形状和头皮一样为了防止穿帮。

|

||||

- 蓝色为主要头发,头发相对于红色部分会稍微稀疏一些。

|

||||

- 剩下的黄色、绿色、亮红色为点缀部分。

|

||||

|

||||

|

||||

## 制作流程

|

||||

### 设计发型与分块

|

||||

尽管Ornaterix可以通过各种分组手段对不同类型头发进行分组,使得可以将所有头发效果都做到一个Ornaterix节点中。但是我还是选择了使用多个Ornaterix物体来制作不同类型的头发。我这么做的原因有以下几点:

|

||||

1. 方便分组,可以随时隐藏头发以便于观察其他头发。

|

||||

2. 如果其中一个崩溃报错了,不至于所有的工作都白费了。

|

||||

|

||||

### 制作头发

|

||||

以下我分享以下我所知道的制作思路,首先我本人采用了导入外部引导曲线的方式来制作头发,因为之前学习了一段时间的xGen,所以可以直接将之前制作的引导曲线导入Ornatrix中。

|

||||

|

||||

- 对于一些短发可以直接生成通过生成几根引导曲线,生成头发。之后再用这些头发生成更多的引导曲线来生成头发模型。

|

||||

- 对于一些有着具体形状或是沿着路径生成的头发,可以使用Ornatrix的发片(add hair from mesh strips)功能快速生成,适用于睫毛、打底层头发等。

|

||||

|

||||

上述这些曲线以及面片生成都是带了历时的,你可以随时通过修改面片与曲线来调整头发生成结果。

|

||||

|

||||

模型替代:

|

||||

https://www.bilibili.com/video/av56489034

|

||||

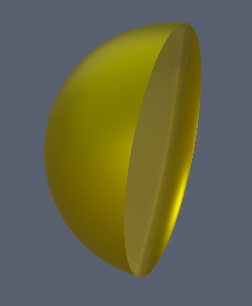

这个视频中可以看出,作者使用了三棱锥模型,而非普通面片,这个可以使用(add Mesh from stands)中的proxy mesh stands来实现。从视频中可以看得出,使用这个方法增强了头发的立体感。

|

||||

|

||||

长发不适合用随机生成的方法来制作,且需要精准控制遮盖、效果与面数,所以对于长发我推荐使用官方的方法来做:

|

||||

https://www.bilibili.com/video/av79618784

|

||||

### 导出模型

|

||||

直接导出貌似是无效的(可能是我Maya的问题),我搜索了油管与文档都没有发现导出方法。所以以下的方法我不能保证一定是正确的:

|

||||

|

||||

在加入Mesh Frome Stand节点后,将Maya设置为多边形选择模式,选中需要导出的面,之后选择复制面命令。之后多边形就会出现在大纲视图的Or节点下面了。

|

||||

### 烘焙id贴图与高度贴图

|

||||

我因为对Vray、Arnold烘焙流程不熟,且不会烘焙分组的id贴图,所以还是选择简单易懂的xNormal流程:

|

||||

https://www.bilibili.com/video/av56489034

|

||||

|

||||

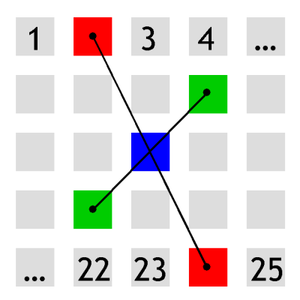

使用这个流程,在烘焙id贴图前还需要把毛发模型进行分组并导出。作者提供的插件是根据百分比随机从当前物体中选择物体,所以如果你要分成5份,就需要依次使用20%、25%、33%、50%分离物体并导出。因此对于这个流程,插件还有很大的改进空间。

|

||||

|

||||

如果你对Arnold或者Vray以及maya节点系统熟悉的话可以选择官方流程,这个流程的优点是制作完马上就可以预览效果:

|

||||

https://www.bilibili.com/video/av79619146

|

||||

### 是先制作模型还是先制作贴图?

|

||||

个人还是倾向于先制作贴图,因为制作贴图本身不会受制于模型,而且在之后的模型制作中就可以随时预览制作效果了。如果先制作模型,很可能会出现因为效果没有达到预期,而造成返工修改模型的情况。

|

||||

|

||||

## 官方网站与国内购买网站

|

||||

官方网站:

|

||||

http://www.ephere.com/

|

||||

|

||||

官方油管频道:

|

||||

https://www.youtube.com/channel/UCzzR4qt--4OcXgvyUTsgW6w

|

||||

|

||||

文档地址:

|

||||

https://ephere.com/plugins/autodesk/maya/ornatrix/docs/2/

|

||||

|

||||

官方频道上的教程挺多的,再加上这个插件使用不难,很多基础功能光看英文就能知道如何使用,再看看文档与视频就差不多。但如果你想快速入门我推荐aboutcg的教程。

|

||||

|

||||

国内有aboutcg代理了,以下是购买网址:

|

||||

https://tool.aboutcg.com/tool/ornatrix-maya/

|

||||

## 学习过的资料

|

||||

https://new.80.lv/articles/tips-tricks-on-hair-for-games/

|

||||

|

||||

视频的话我已上传到B站:

|

||||

https://www.bilibili.com/video/av56489034

|

||||

|

||||

Ornatrix官方视频:

|

||||

https://www.bilibili.com/video/av79618784

|

||||

|

||||

https://www.bilibili.com/video/av79619146

|

||||

|

||||

https://www.bilibili.com/video/av79618545

|

||||

## 使用插件

|

||||

我使用了《Tips & Tricks on Hair for Games》作者提供的Maya插件。

|

||||

```

|

||||

https://pan.baidu.com/s/1DDAj9bdMTMzvpU9ZnFevrw w6ar

|

||||

```

|

||||

@@ -0,0 +1,67 @@

|

||||

## 前言

|

||||

4.24出了头发渲染与模拟功能,这真是一件令人兴奋的事,所以我稍微花了点时间进行测试,在此分享一些经验。

|

||||

|

||||

### 使用步骤

|

||||

使用步骤大致如下,具体的可以参考文档:https://docs.unrealengine.com/en-US/Engine/HairRendering/QuickStart/index.html

|

||||

|

||||

1. 首先在项目设置启用Support Compute Skincache,并禁用Tick Animation on Skeletal Mesh Init。

|

||||

2. 启用Alembic Groom Importer与Groom插件,之后重启引擎。(此时大概会编译大概5000多的Shader)

|

||||

|

||||

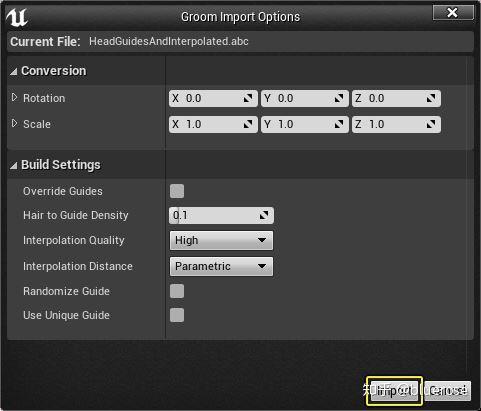

1. 导入带有Groom信息的abc缓存文件。

|

||||

|

||||

4. 设置Groom Asset属性。(主要是设置头发宽度)

|

||||

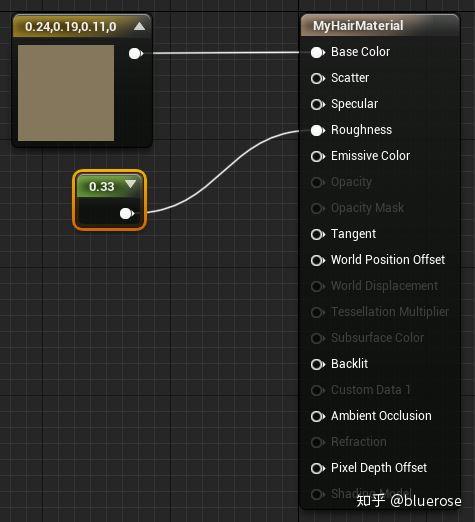

5. 设置Groom材质。(ShadingModel需要设置hair,Groom对象的材质有两种设置方式:1、从ContentBrowser中设置GroomAsset的属性 2、在场景中设置Groom对象的属性)

|

||||

|

||||

6. 将GroomAsset拖入场景中并且attach到场景中的骨骼模型上,并调整位置。(直接放入蓝图的骨骼模型引擎会崩溃)

|

||||

|

||||

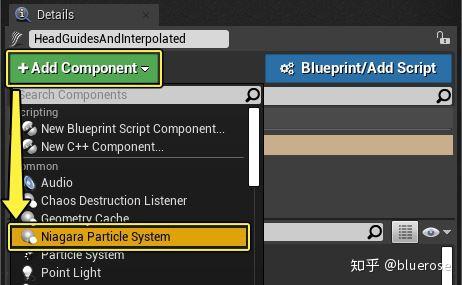

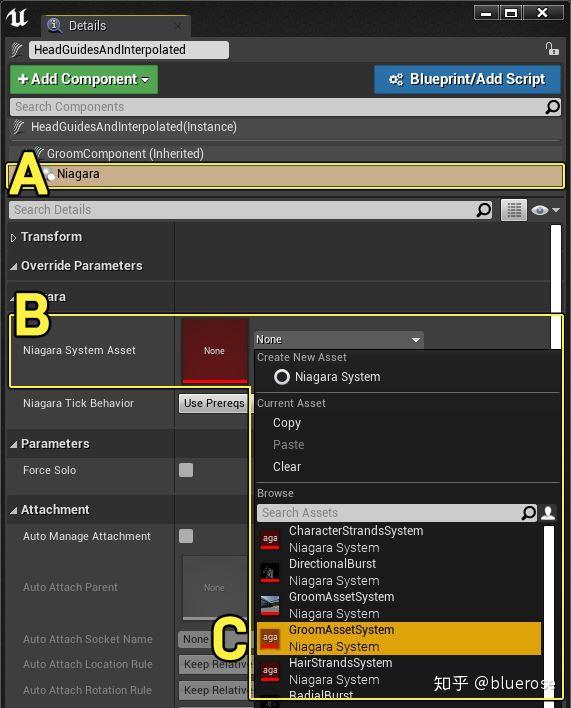

7. 设置场景中的Groom物体属性,给它挂载Niagara Particle System,并且设置GroomAssetSystem。

|

||||

|

||||

|

||||

8. 设置Niagara物理参数。

|

||||

|

||||

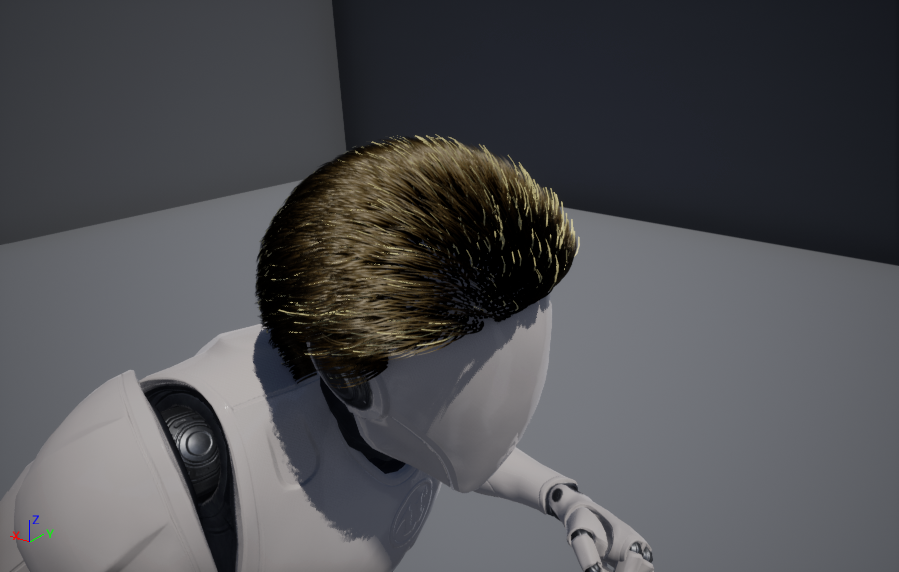

**最终结果:**

|

||||

|

||||

|

||||

|

||||

**关于头发对齐问题与Bind Groom to Skeletal Mesh选项**

|

||||

我是复制了头皮模型,并以此为基础制作头发的。所以理论上头发是不需要对齐。但导入后头发还是需要手动位移(可能是我导出的时候没有勾选Unreal Engine Export的关系)

|

||||

|

||||

**Bind Groom to Skeletal Mesh**这个选项应该让Groom根据蒙皮数据进行运动,但我用下来,感觉这个选项没什么卵用(如有正确思路还请告知),而且头发会发生错误的位移。然后在你勾选这个选项后,将GroomAsset清空或者将Groom对象从骨骼物体上解除Attacked,都会触发一个LOD的断言,从而导致引擎直接关闭。这明显是因为容错逻辑没有写完所造成的的,但也可以理解毕竟4.24.1出的时候都要过年了。

|

||||

|

||||

**Hair to Guide Density**

|

||||

导入的头发与Groom和Ornatrix渲染的头发量(Hair From Guides中的Render Count)有关,和Ornatrix的引导曲线无关。因为本人没有看过源代码,所以以下是个人的无责任猜测:

|

||||

Ue4在导入头发时(abc里的数据还是类似曲线一样的东西),会根据头发分布重新生成"引导曲线",以此来进行物理模拟。因为我在进行测试的时候发现,3000个引导线与9000个引导线,在静态环境下渲染结果与帧数都是相同。而在设置Niagara Particle System与GroomAssetSystem时,会耗费较长的时间。

|

||||

|

||||

所以Hair to Guide Density的默认参数0.1,这个就不要更改了。

|

||||

|

||||

|

||||

从这个图中,可以看出一些靠近边缘的区域需要增加头发密度,不然就有可能出现图中这种25岁程序员的头发。

|

||||

|

||||

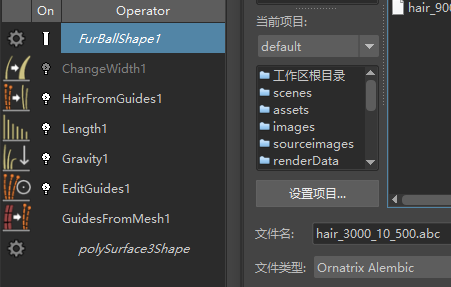

### Ornatrix导出abc

|

||||

|

||||

导出abc的时候需要在Ornatrix的大纲视图选中最上面的节点,实际上就是选中Ornatrix的形状节点,你可以Maya的关系编辑器中通过查看上下游节点进行查看。

|

||||

|

||||

之后点击“导出当前选择”,选择OrnatrixAlembic文件类型。勾选

|

||||

文件类型特定选项-Export Components-Unreal Engine Export选项,之后就可以导出了。

|

||||

|

||||

### Groom ID

|

||||

Ornatrix中可以通过StandGroup对头发进行分组编辑。Ue4会通过这些StandGroup作为Groom ID数据。你可以对Groom ID的头发使用不同的参数。这样可以实现一个GroomAsset(abc文件)存储头发、睫毛、眉毛多种类型毛发(不同的宽度与材质)。

|

||||

|

||||

Strand Groups一般是通过Edit Guides节点进行指定的。指定步骤如下:

|

||||

1. 在Edit Guides,点击Edit Stands按钮进行编辑Stands模式。

|

||||

2. 选中需要添加组的头发。

|

||||

3. 之后在StandsGroups选项卡中,勾选Use Stands Groups,并在调整Stands Group Index后点击Assign。

|

||||

4. 此时取消头发选择,如果之前选中过的头发变色了,就代表分组已经成功。

|

||||

|

||||

**Ornatrix导出文档:**

|

||||

https://ephere.com/plugins/autodesk/maya/ornatrix/docs/2/Exporting_Hair_to_Alembic.html

|

||||

|

||||

**Strand Groups文档:**

|

||||

https://ephere.com/plugins/autodesk/maya/ornatrix/docs/2/Strand_Groups.html

|

||||

|

||||

### 个人评价

|

||||

因为本人电脑存在问题,打开一个测试场景帧数都是不稳定的,所以本人没有进行性能方面的测试。但是我感觉目前渲染效率还不错(帧数没有下降特别多)。目前存在问题,容易崩。再过几个版本迭代就可以直接拿来做项目了吧。

|

||||

|

||||

### 官方文档中所说的限制

|

||||

1、帧数受Groom大小、分辨率与硬件影响。

|

||||

2、目前不支持多屏显示与VR。

|

||||

163

03-UnrealEngine/Rendering/Debug/RenderDoc使用技巧.md

Normal file

163

03-UnrealEngine/Rendering/Debug/RenderDoc使用技巧.md

Normal file

@@ -0,0 +1,163 @@

|

||||

---

|

||||

title: RenderDoc使用技巧

|

||||

date: 2022-09-30 11:17:29

|

||||

excerpt:

|

||||

tags: RenderDoc

|

||||

rating: ⭐⭐

|

||||

---

|

||||

## 前言

|

||||

参考:https://zhuanlan.zhihu.com/p/568990608

|

||||

|

||||

## UE相关设置

|

||||

|

||||

|

||||

### UE5中的改动

|

||||

UE5中,这些名称有了一定的变化

|

||||

|

||||

| 旧名称 | 新名称 | 注解 |

|

||||

| --------------------------------------- | ------------------------ | -------------------------------------------------------------------------- |

|

||||

| r.Shaders.KeepDebugInfo | r.Shaders.Symbols | 通过生成符号并将其写入主机的磁盘来启用着色器调试,PC符号仍以内联方式存储。 |

|

||||

| r.Shaders.KeepDebugInfo(被划分为两部分) | r.Shaders.ExtraData | 生成着色器名称和其他"额外"着色器数据。 |

|

||||

| r.Shaders.PrepareExportedDebugInfo | r.Shaders.GenerateSymbol | 生成符号,但不将其写入磁盘(备注:符号存储在DDC中) |

|

||||

| r.Shaders.ExportDebugInfo | r.Shaders.WriteSymbols | 如果符号已生成,则将其写入磁盘。 |

|

||||

|

||||

## 其他设置

|

||||

renderdoc.BinaryPath // 查看RenderDoc的安装路径

|

||||

renderdoc.BinaryPath "C:\Program Files\RenderDoc" // 设置RenderDoc的安装路径为C:\Program Files\RenderDoc

|

||||

renderdoc.CaptureAllActivity 1 // 勾选CaptureAllActivity(获取编辑器所有viewport和窗口的渲染数据,而不仅仅是当前viewport) 注:获取UI的Draw,需要开启该开关

|

||||

renderdoc.CaptureCallstacks // 查看CaptureCallstacks(获取图形API的调用堆栈)是否勾选

|

||||

renderdoc.EnableCrashHandler 0 // 取消勾选EnableCrashHandler(截帧崩溃时是否使用RenderDoc的crash handler)

|

||||

renderdoc.ReferenceAllResources // 查看ReferenceAllResources(获取所有mesh、材质,纹理等渲染资源,开启该选项会导致帧文件很大)是否勾选

|

||||

renderdoc.SaveAllInitials 1 // 勾选SaveAllInitials(获取所有mesh、材质,纹理等渲染资源的初始状态,开启该选项会导致帧文件很大)

|

||||

renderdoc.ShowHelpOnStartup // 查看ShowHelpOnStartup(启动编辑器时是否弹出RenderDoc的帮助对话框)是否勾选

|

||||

|

||||

>调试Slate所需命令renderdoc.CaptureAllActivity 1

|

||||

|

||||

## 截帧命令

|

||||

- renderdoc.CaptureFrameCount 10 // 连续截10帧,并保存到一个rdc文件中

|

||||

- renderdoc.CapturePIE 12 // 在编辑器中,将当前地图Play,然后连续截取12帧

|

||||

- renderdoc.CaptureDelayInSeconds 0 // 设置Delay的单位为帧

|

||||

- renderdoc.CaptureDelayInSeconds 1 // 设置Delay的单位为秒

|

||||

- renderdoc.CaptureDelay 15 // 当Delay的单位为帧时,表示设置延迟15帧;当Delay的单位为秒时,表示设置延迟15秒

|

||||

// 注:这个只是设置,仍然需要调用renderdoc.CaptureFrame等来发起截帧动作

|

||||

|

||||

## 重新编译Shader

|

||||

- r.RecompileRenderer:重新编译所有RenderModule。

|

||||

- recompileshaders:位于`bool RecompileShaders(const TCHAR* Cmd, FOutputDevice& Ar);`可以编译指定的Material。命令默认编译所有Shader,快捷键是Ctrl+Shift+.。`recompileshaders material <material name>`

|

||||

- Changed:编译修改过文件

|

||||

- Global:编译GlobalShader

|

||||

- Material **MaterialName**:附带一个参数材质名称

|

||||

- All:所有文件

|

||||

- **ShaderFileName**:编译指定的Shader

|

||||

|

||||

有人说`recompileshaders <USF FileName>`可以只编译指定的USF文件,但实际测试会报错。或许可以试试Material版本,比如`recompileshaders material M_SGSSS`

|

||||

|

||||

## 截取非管线Shader的方法

|

||||

在你EnqueueRenderCommand前加一个FScopedCapture ,跑到你的Cmd的时候就可以自动Renderdoc截帧 ,类为FcopedCapture。

|

||||

|

||||

## 使用技巧

|

||||

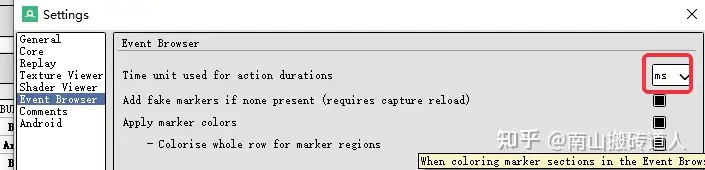

### 修改ms显示耗时

|

||||

|

||||

|

||||

|

||||

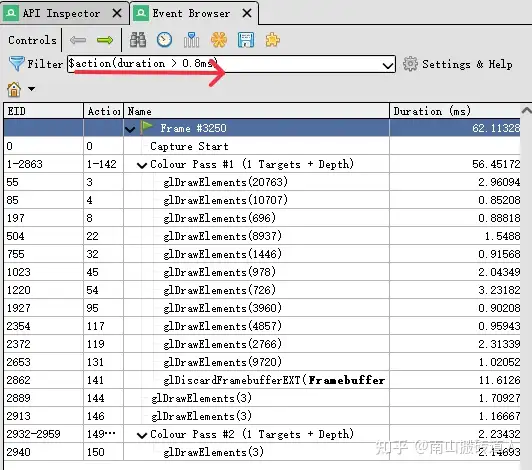

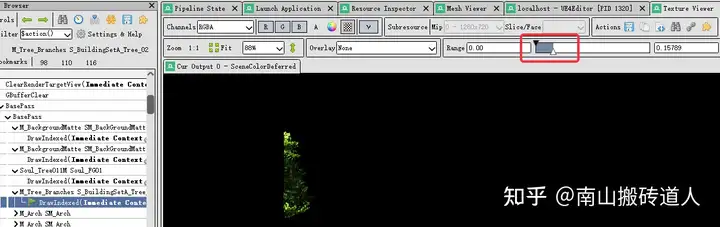

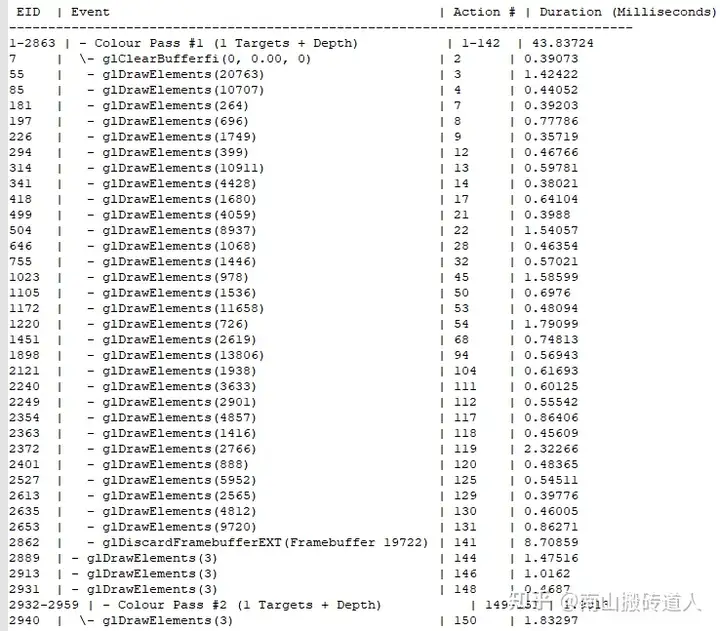

### 过滤高耗时DrawCall

|

||||

|

||||

使用$action(duration > 0.8ms) 进行过滤

|

||||

|

||||

|

||||

|

||||

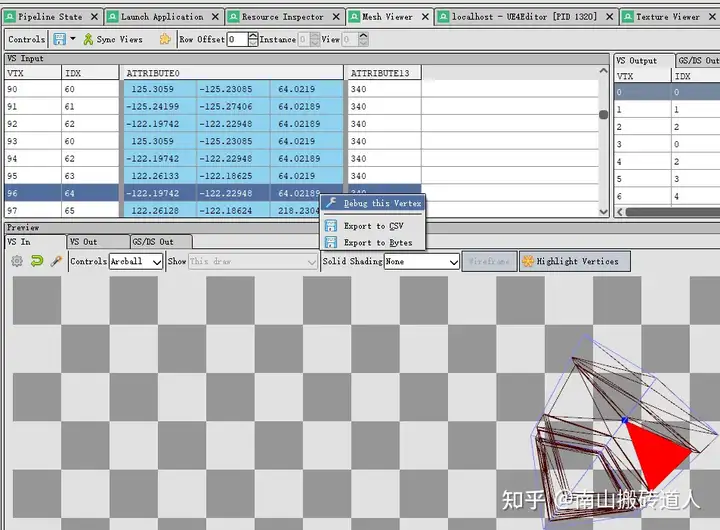

### **调试VS**

|

||||

|

||||

Mesh Viewer中;vs input选中或在preview窗口中鼠标右键选中顶点,在选中顶点行上右键debug thie vertices

|

||||

|

||||

|

||||

|

||||

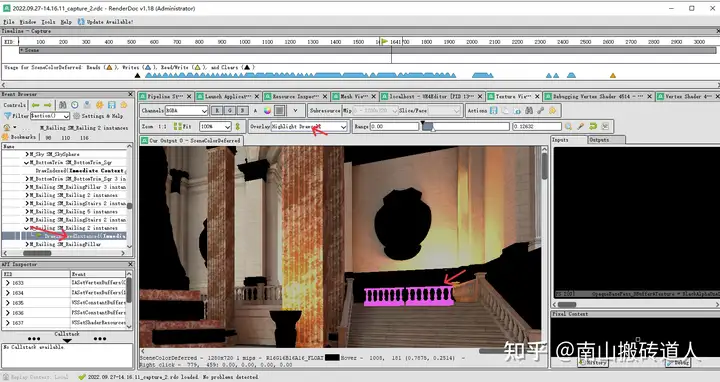

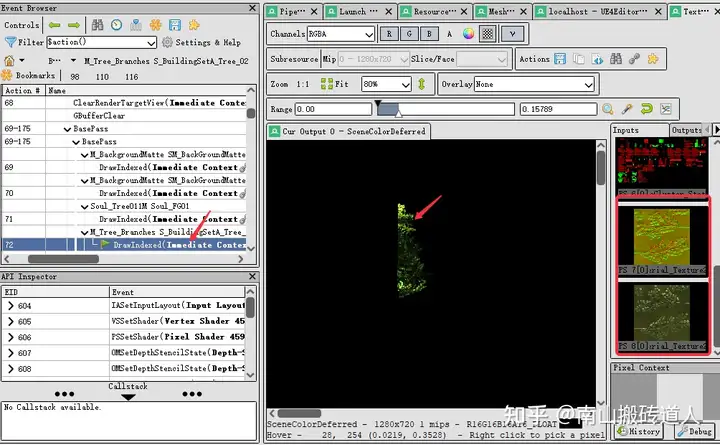

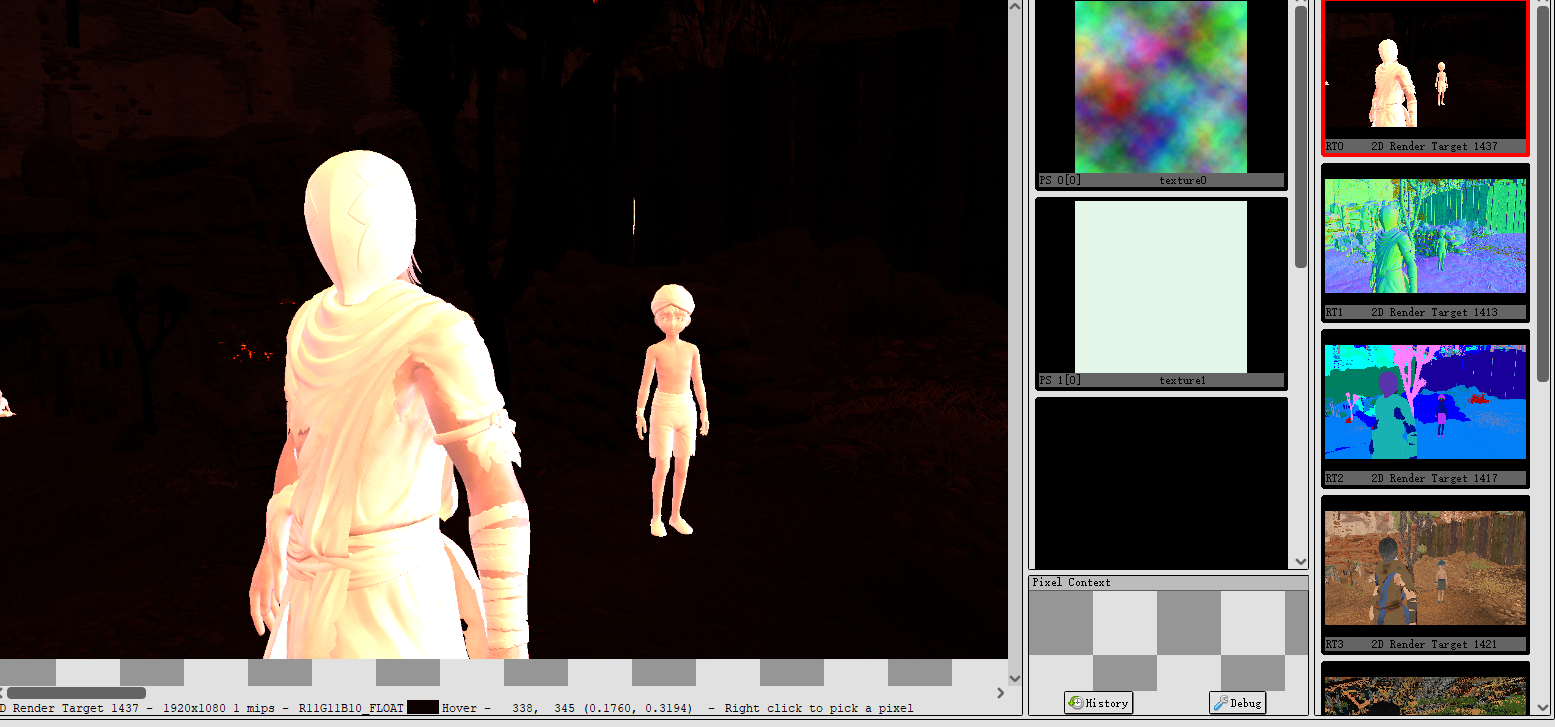

### **调试PS**

|

||||

|

||||

Texture Viewer中右键选择像素;在Pixel Context中心就是选中的像素,选择需要调试的历史时间,点击“Debug”调试

|

||||

|

||||

|

||||

|

||||

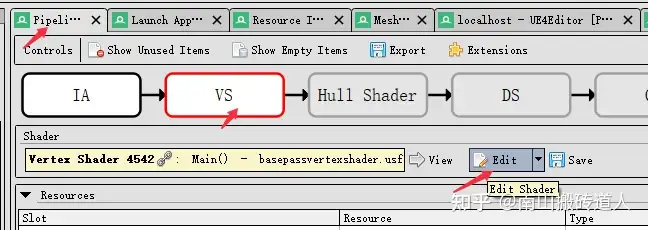

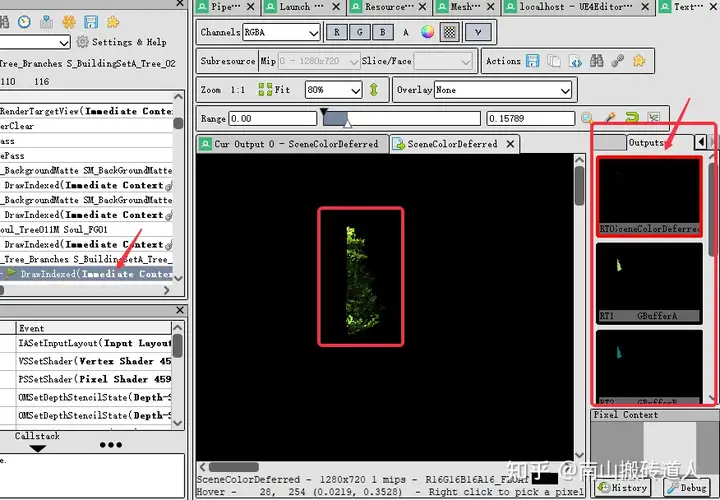

### 修改VS

|

||||

|

||||

|

||||

|

||||

选中dc高亮绘制

|

||||

|

||||

|

||||

|

||||

Pipeline state进入VS

|

||||

|

||||

|

||||

|

||||

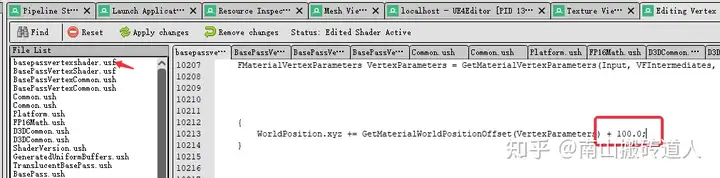

修改坐标

|

||||

|

||||

|

||||

|

||||

Texture View中预览位置变化

|

||||

|

||||

### 修改PS

|

||||

|

||||

|

||||

|

||||

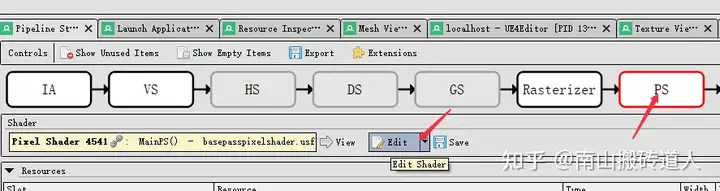

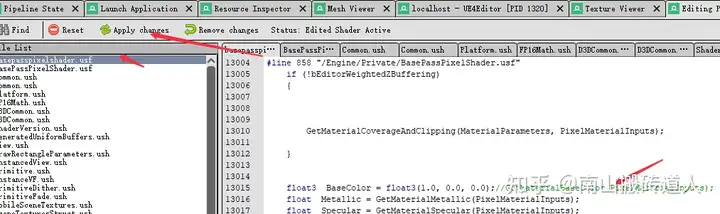

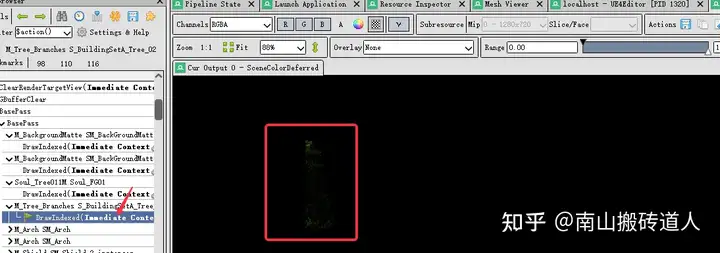

进入pipeline state 编辑ps

|

||||

|

||||

|

||||

|

||||

修改前颜色

|

||||

|

||||

|

||||

|

||||

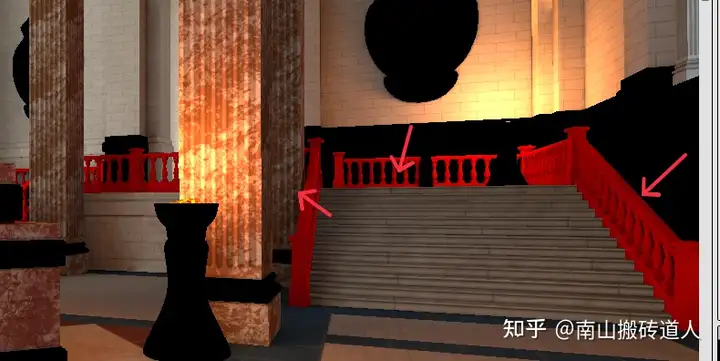

修改base color为红色

|

||||

|

||||

|

||||

|

||||

修改后效果预览

|

||||

|

||||

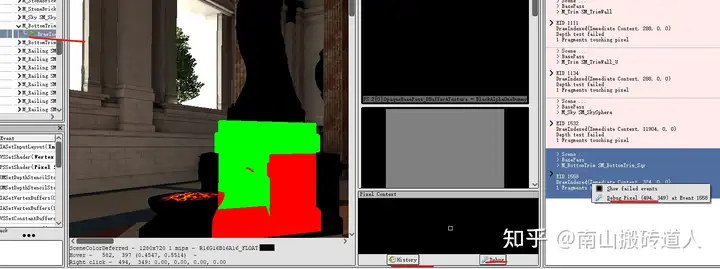

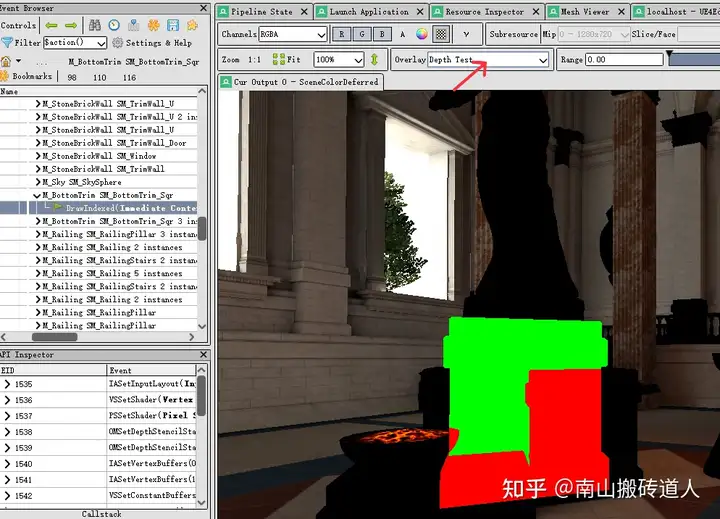

### 查看深度模板测试结果

|

||||

|

||||

|

||||

|

||||

红色测试不同多,绿色测试通过

|

||||

|

||||

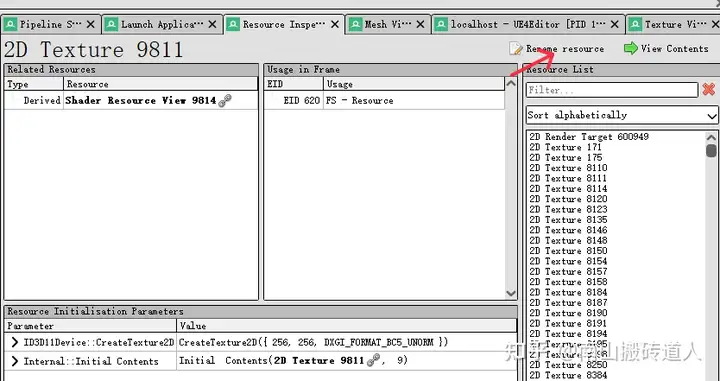

### 查看纹理在那些事件引用

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

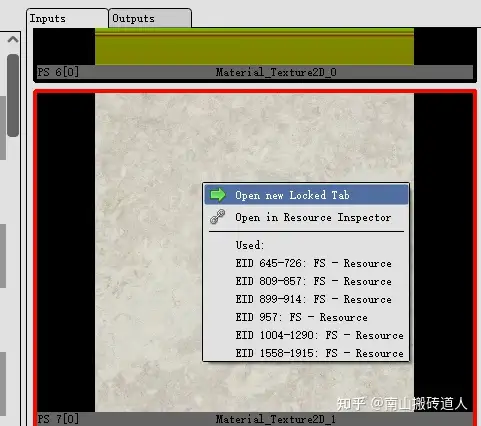

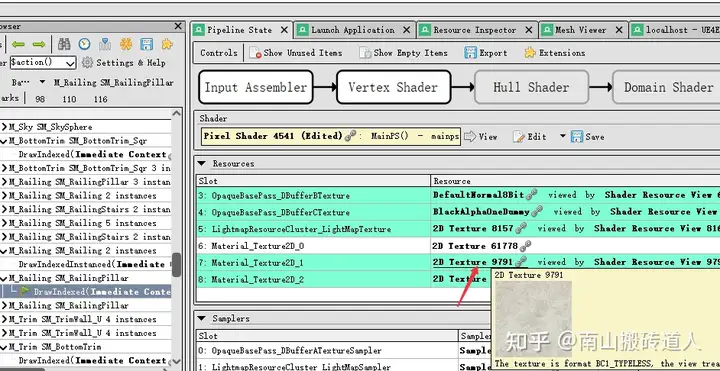

PS 资源种点击链接

|

||||

|

||||

|

||||

|

||||

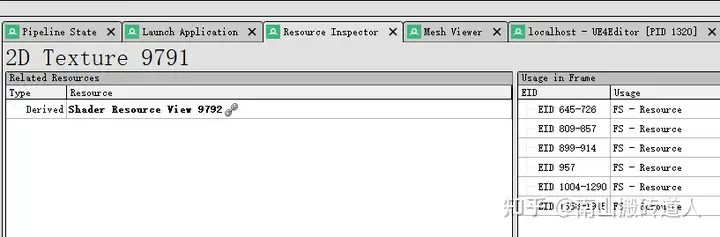

Resource Inspector中右侧查看那些事件使用了此资源

|

||||

|

||||

### 纹理太暗

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

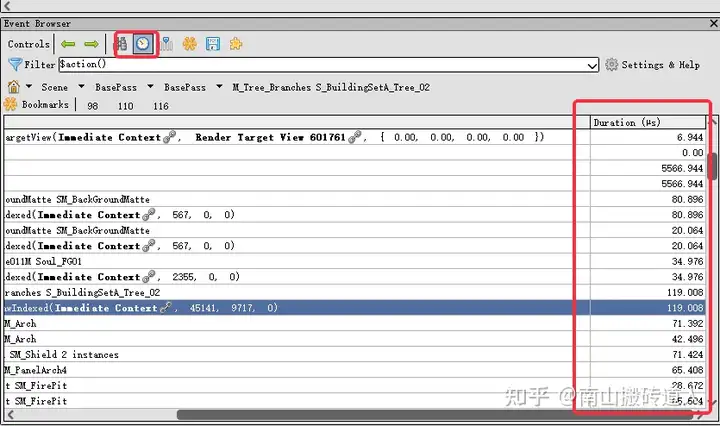

### **查看DrawCall耗时**

|

||||

|

||||

|

||||

|

||||

### 查看纹理输入输出

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

### 重名名纹理

|

||||

|

||||

|

||||

|

||||

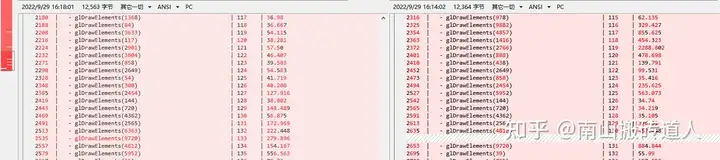

### 如何对比数据

|

||||

|

||||

将过滤后的数据导出为文本,使用对比工具进行对比。用于发现dc耗时问题

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -0,0 +1,134 @@

|

||||

---

|

||||

title: UE5RayTracing篇-1-——NSight-Graphics

|

||||

date: 2022-11-11 17:51:43

|

||||

excerpt:

|

||||

tags:

|

||||

rating: ⭐

|

||||

---

|

||||

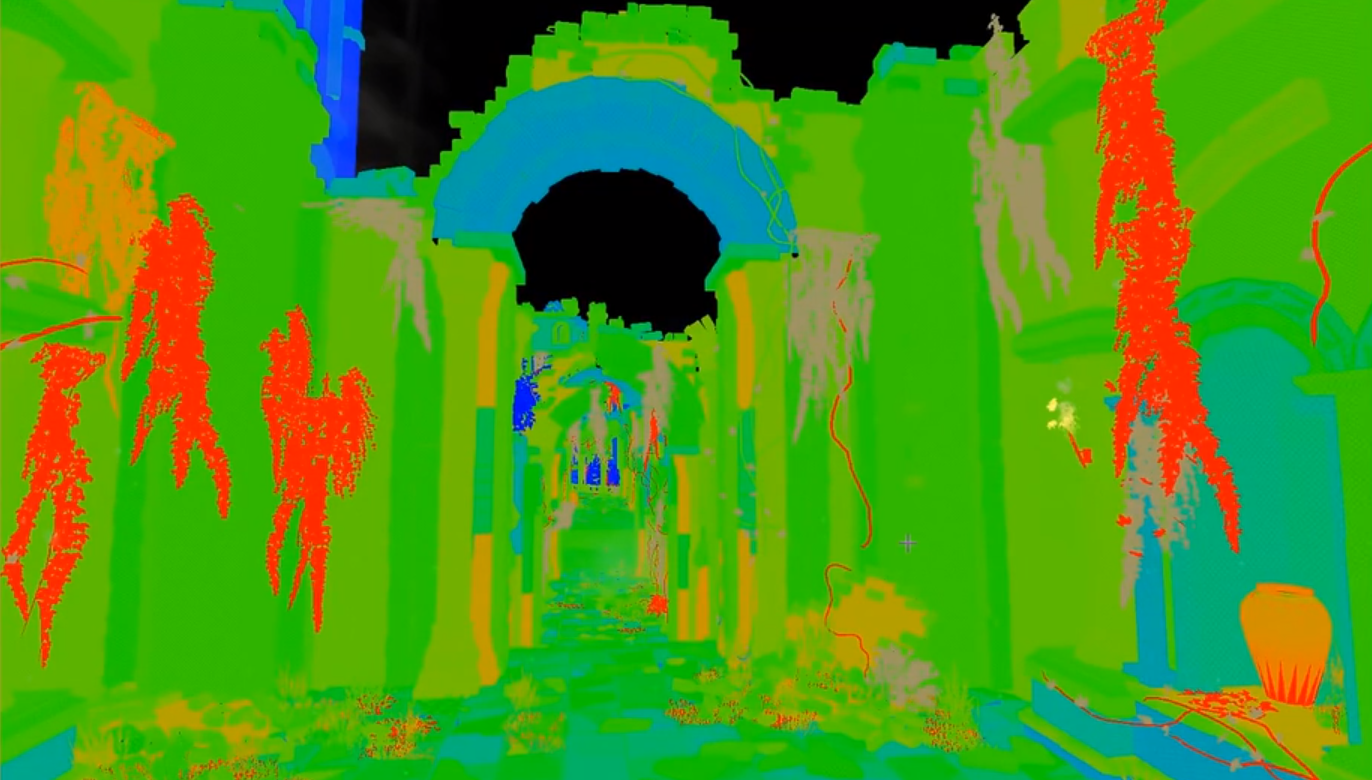

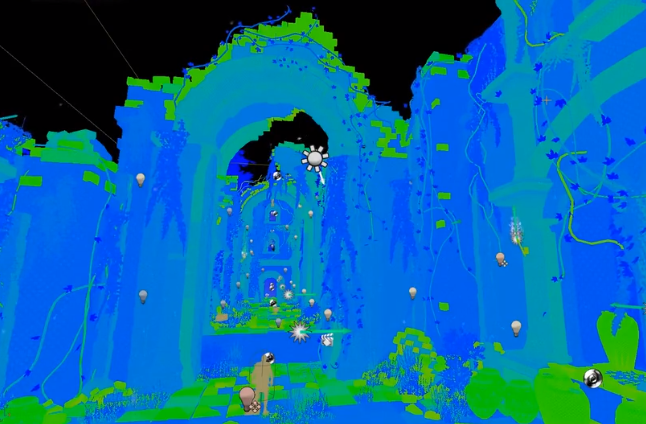

最近打算开始研究UE的RayTracing,但欲先利其事必先利器,必要的Debug手段还是需要会用。在发现RenderDoc不支持RayTracing后,花了些时间学习了一下NSight Graphics。一般的流程就是使用NSight启动要调试的游戏(项目)进程,之后按F11截帧并使用所需工具查看。下面的章节将会简单介绍一下它的功能。

|

||||

<!--more-->

|

||||

|

||||

## UE RayTracing与Shader开发相关

|

||||

UE的RayTracing Debug界面需要输入命令后才会显示:

|

||||

```

|

||||

show raytracingdebug 1

|

||||

r.RayTracing.DebugVisualizationMode Performance

|

||||

r.RayTracing.DebugVisualizationMode Traversal Node

|

||||

```

|

||||

UE5.0.1这些命令无效,5.02虽然可以显示Debug界面了,但里面不会渲染任何东西。

|

||||

|

||||

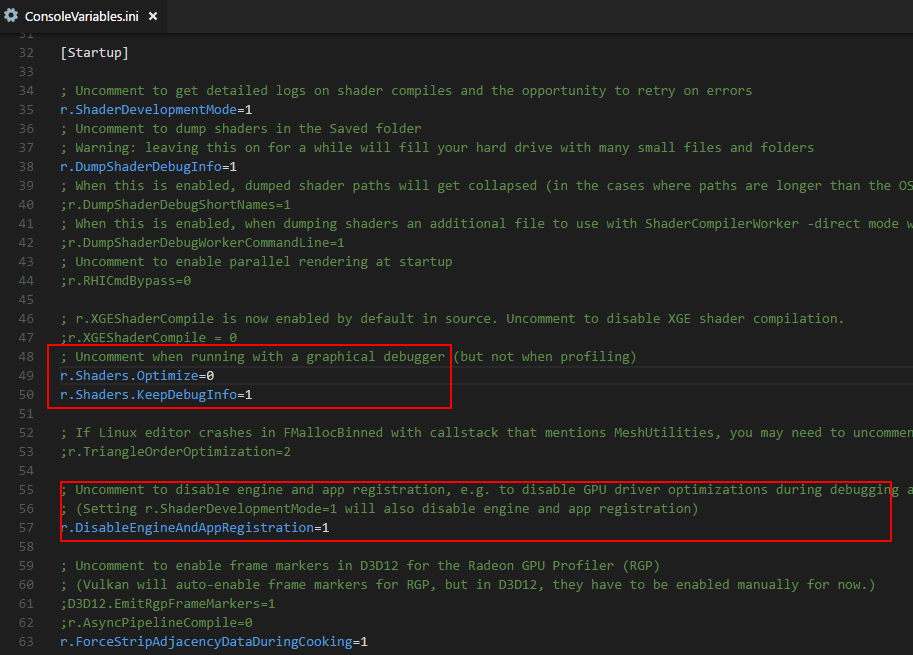

为了能够截取到Shader的源码并使用RenderDoc的断点调试,需要开启Shader开发变量。位于Engine/Config/ConsoleVariables.ini中:

|

||||

```

|

||||

//删除前面的//即可开启

|

||||

r.ShaderDevelopmentMode=1

|

||||

r.Shaders.Optimize=0

|

||||

```

|

||||

|

||||

## NSight

|

||||

介绍视频:

|

||||

- https://youtu.be/yBIKsjd2dJk

|

||||

- https://youtu.be/LKR5XIW1lgs

|

||||

|

||||

文档:

|

||||

- https://docs.nvidia.com/nsight-tools/nsight-graphics/UserGuide/index.html

|

||||

- https://docs.nvidia.com/nsight-graphics/AdvancedLearning/index.html

|

||||

|

||||

个人觉得相比RenderDoc,NSight的优势在于:

|

||||

- 更加注重性能统计与优化,适合图形程序使用。

|

||||

- 拥有Rtx、VR相关工具,可以让你debug Rtx、VR程序。

|

||||

- 2个截帧文件比较功能。

|

||||

|

||||

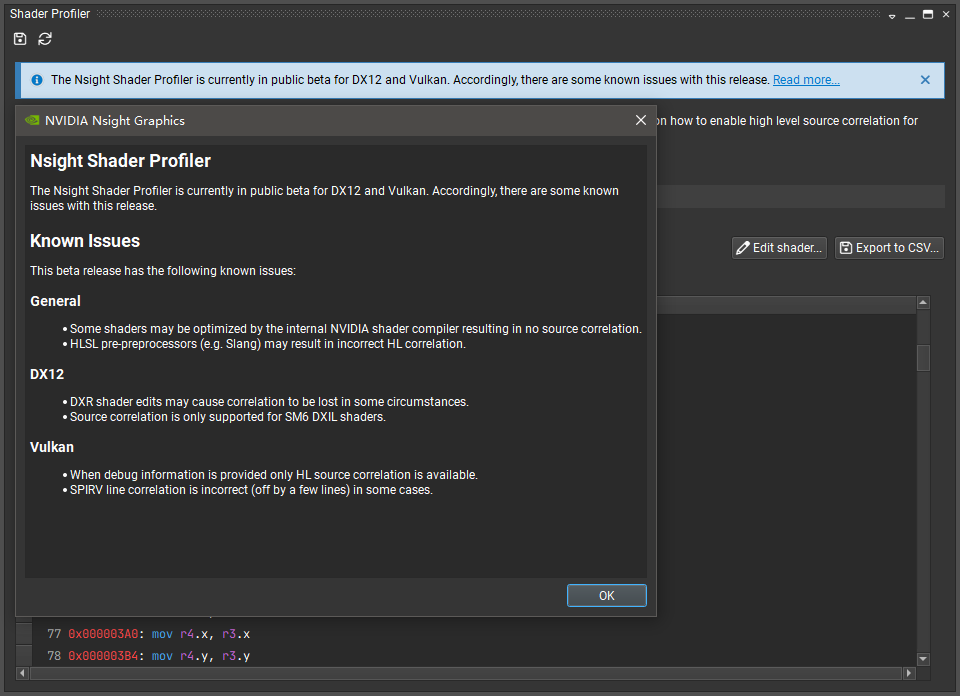

PS.2020.6.1 附加进程到UE5会直接崩溃,UE4.27虽然可以启动,但依然会有问题。2021.2~2022.3的Shader Profiler的Soucre功能会因为SM不是SM6而只能查看Shader的汇编指令。

|

||||

|

||||

|

||||

|

||||

只能等UE5完全支持SM6后才能使用该功能。(测试版本5.02,开启项目设置里的DirectX12 (SM6,Experimental)功能也不行)

|

||||

|

||||

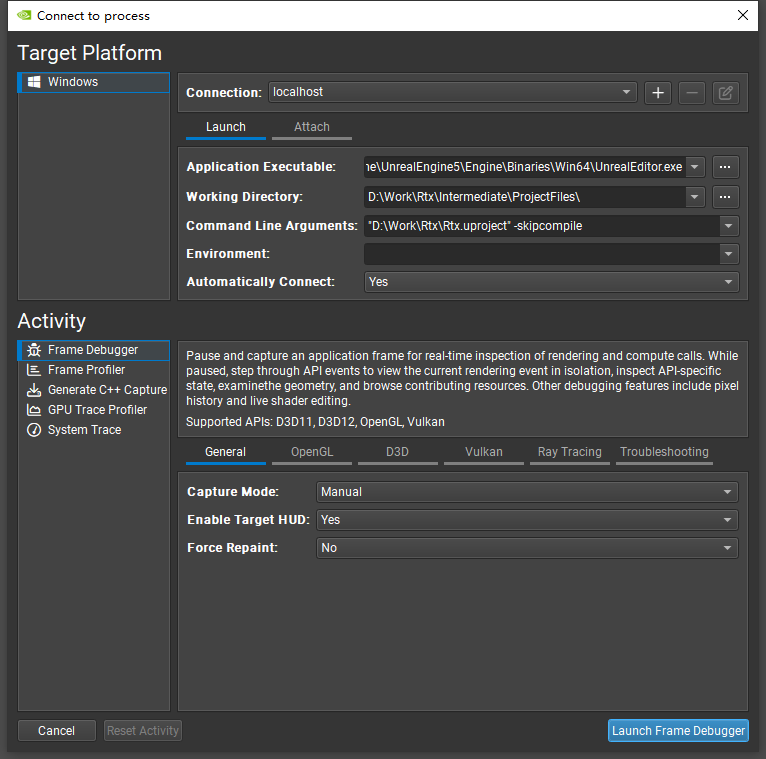

### 连接到进程

|

||||

NSight有3种

|

||||

1. 启动进程并附加:设置ApplicationExcutable后,点击Launch即可。调试UE4的话还需要设置CommandLineArguments为项目路径,比如D:/UnrealEngine/Project/RtxRendering/RtxRendering.uproject

|

||||

|

||||

2. 手动连接已启动的进程(是由通过NSight Graphics启动的进程才能连接):选择启动的进程,之后点Attach即可。

|

||||

|

||||

3. 远程启动:在远程机器上运行Nsight Remote Monitor程序,之后再本机上输入远程机器的IP即可。

|

||||

|

||||

进入界面后点击Capture for Live Analysis即可截取帧信息(默认的截取按键为F11)。

|

||||

|

||||

### NSight工具

|

||||

NSight有5种工具,需要在Connect to process界面中的左下角选择:

|

||||

- Frame Debugger(基本用这个)

|

||||

- Frame Profiler

|

||||

- Generate C++ Capture

|

||||

- GPU Trace Profiler

|

||||

- System Trace

|

||||

|

||||

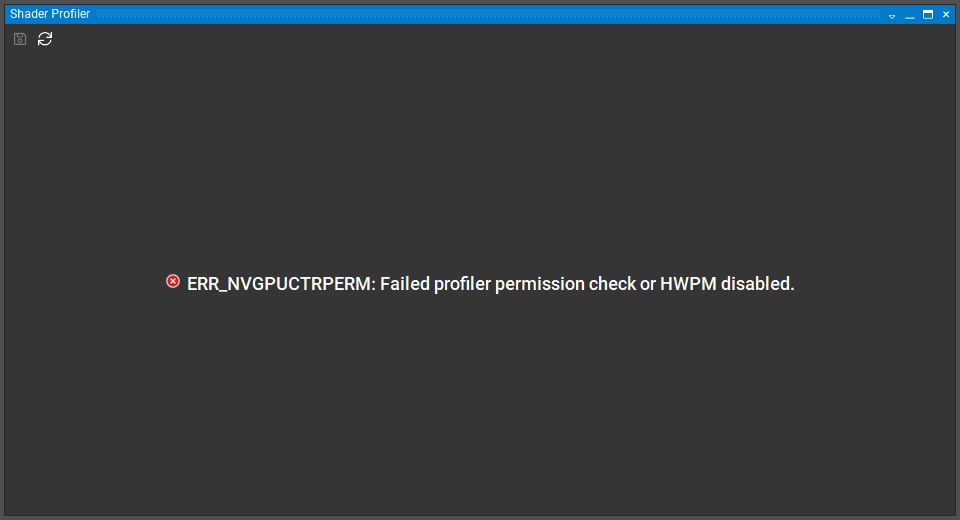

在选择完工具连接进程之后就会显示对应的界面。部分功能需要开启设备访问权限,没开启会显示:

|

||||

|

||||

|

||||

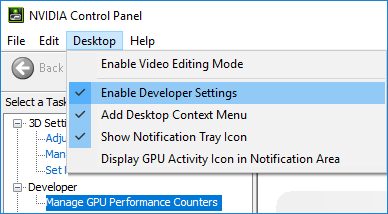

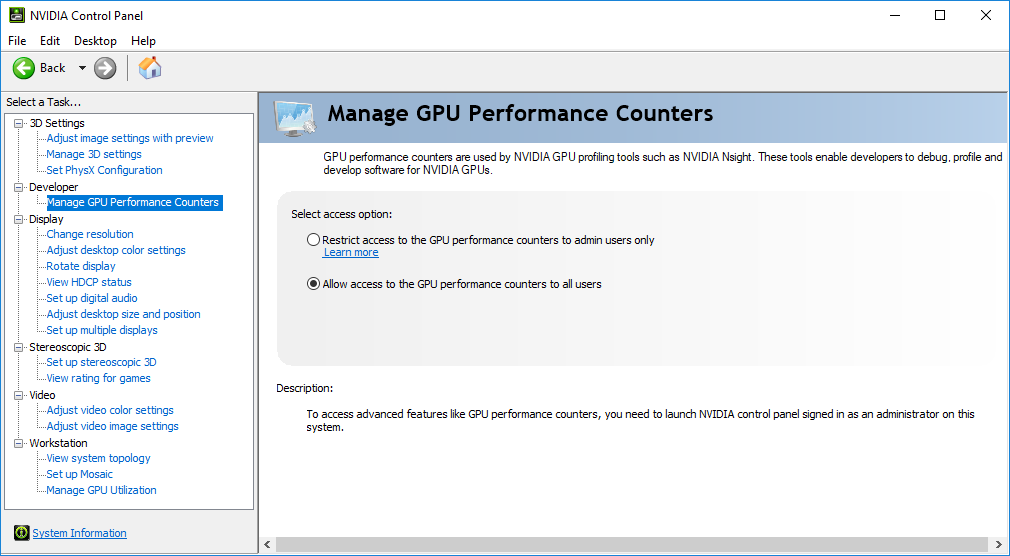

需要在Nvidia控制面板里进行开启,步骤如下:

|

||||

|

||||

|

||||

|

||||

|

||||

其他平台的步骤可以参考https://developer.nvidia.com/nvidia-development-tools-solutions-err_nvgpuctrperm-permission-issue-performance-counters

|

||||

|

||||

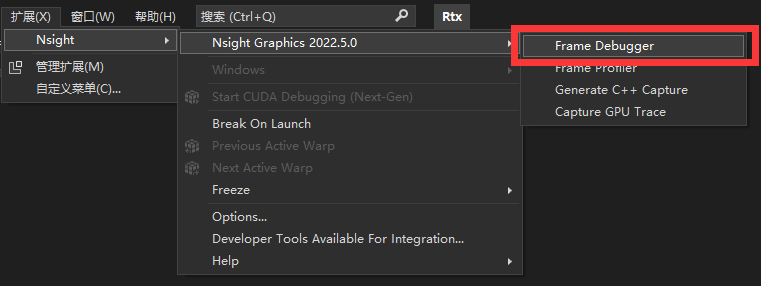

#### Frame Debugger与Frame Profiler

|

||||

Frame Debugger工具包含了Frame Profiler,这些工具里Shader Profiler工具最为重要。

|

||||

|

||||

- Shader Profiler

|

||||

- Summary

|

||||

- Function Summary显示Shader函数的GPU性能占用分布。

|

||||

- Hot Spots显示Shader代码的GPU性能占用分布。

|

||||

- Source 可以打开特定Shader文件,并且显示每行代码的GPU性能占用分布。(NSight2022.3版本无法显示UE5的Shader源码)

|

||||

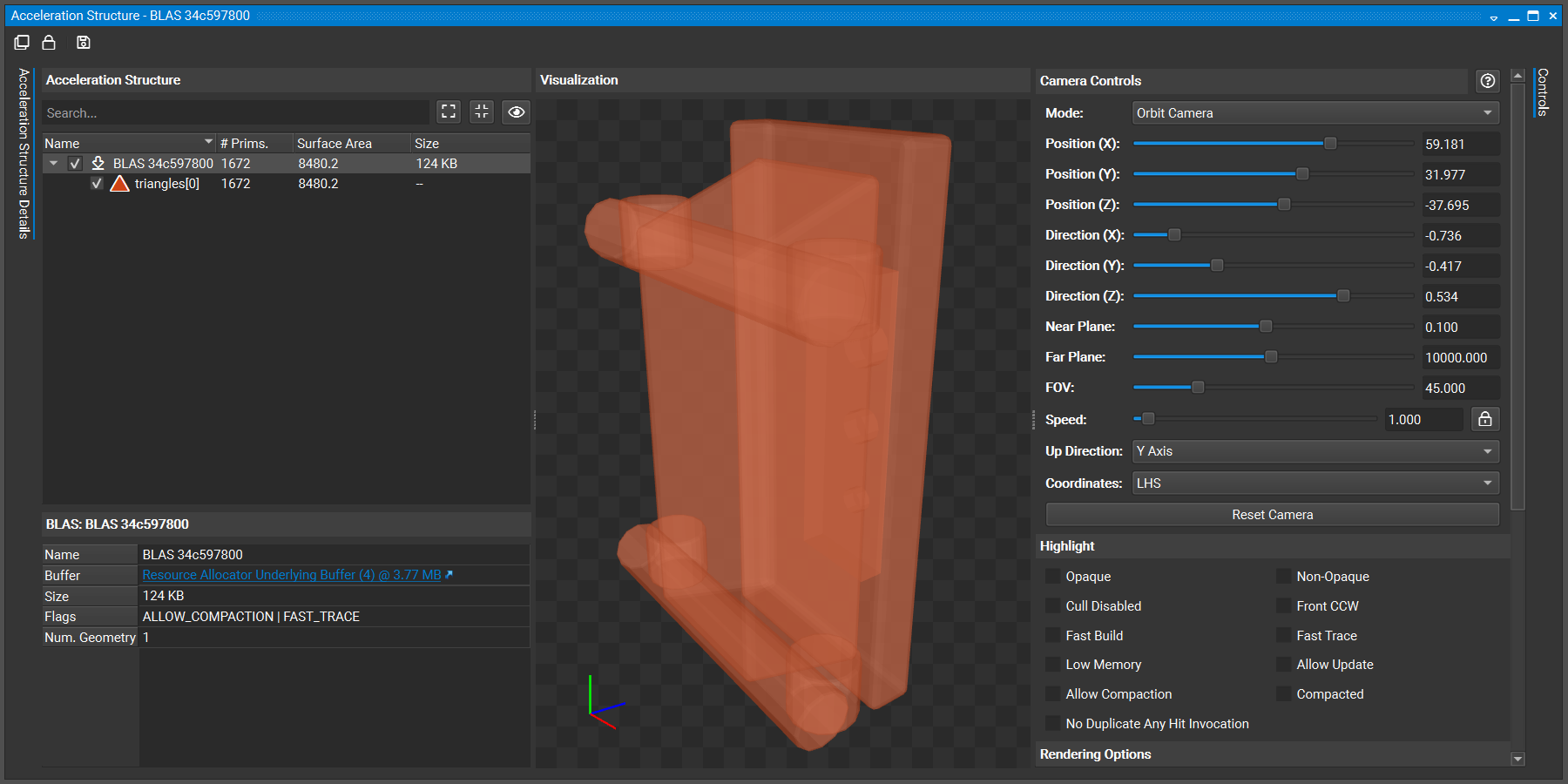

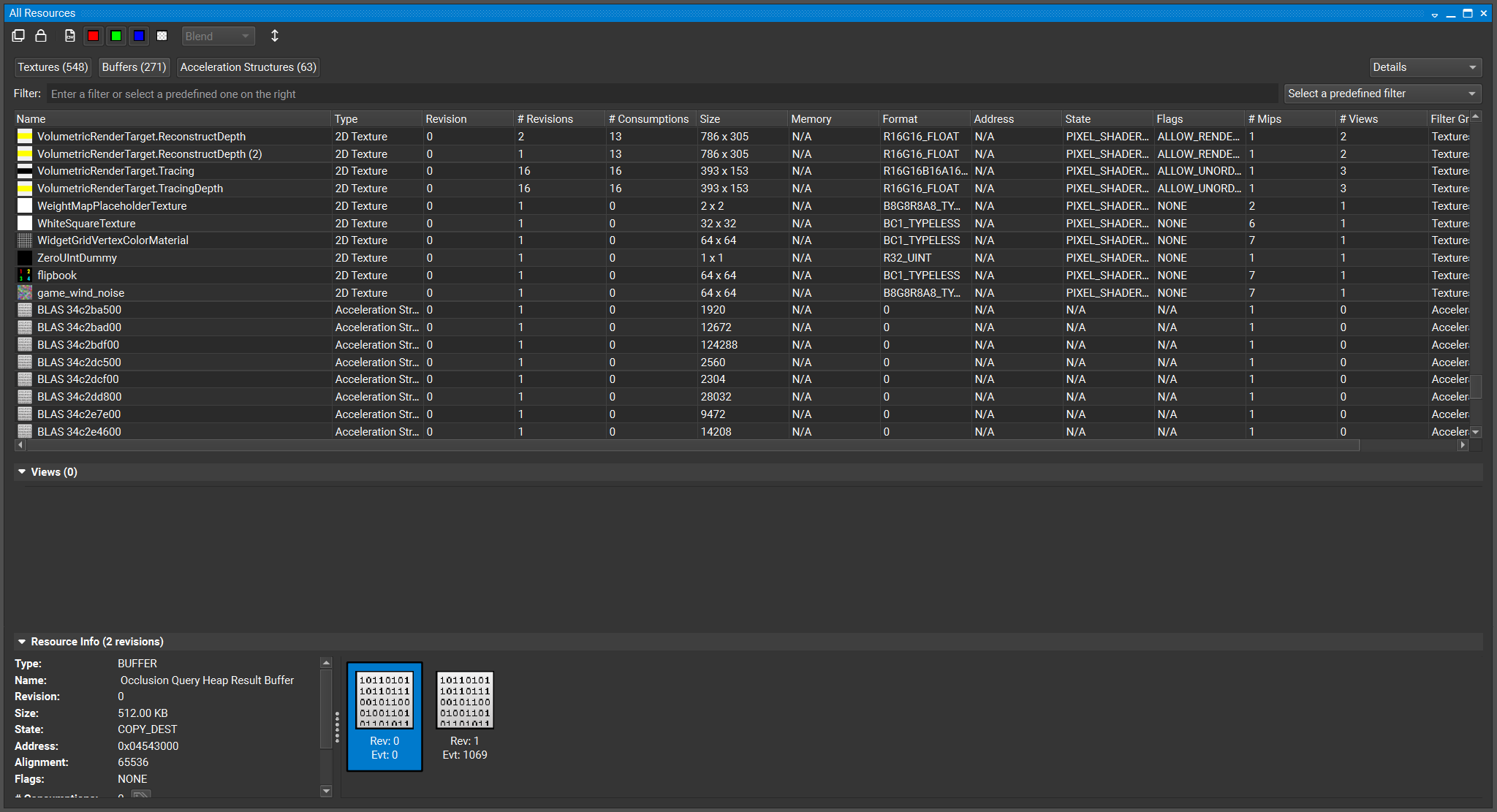

- All Resource:可以查看渲染说用到的贴图、Buffer以及场景模型的BLAS

|

||||

- Geometry:该功能需要选中绘制命令才能显示对应的多边形。具体操作是:Scrubber中选中Event,右键选择Open Event List,再从Event窗口选择绘制事件即可(Filter中输入Draw就可以找到绘制事件)

|

||||

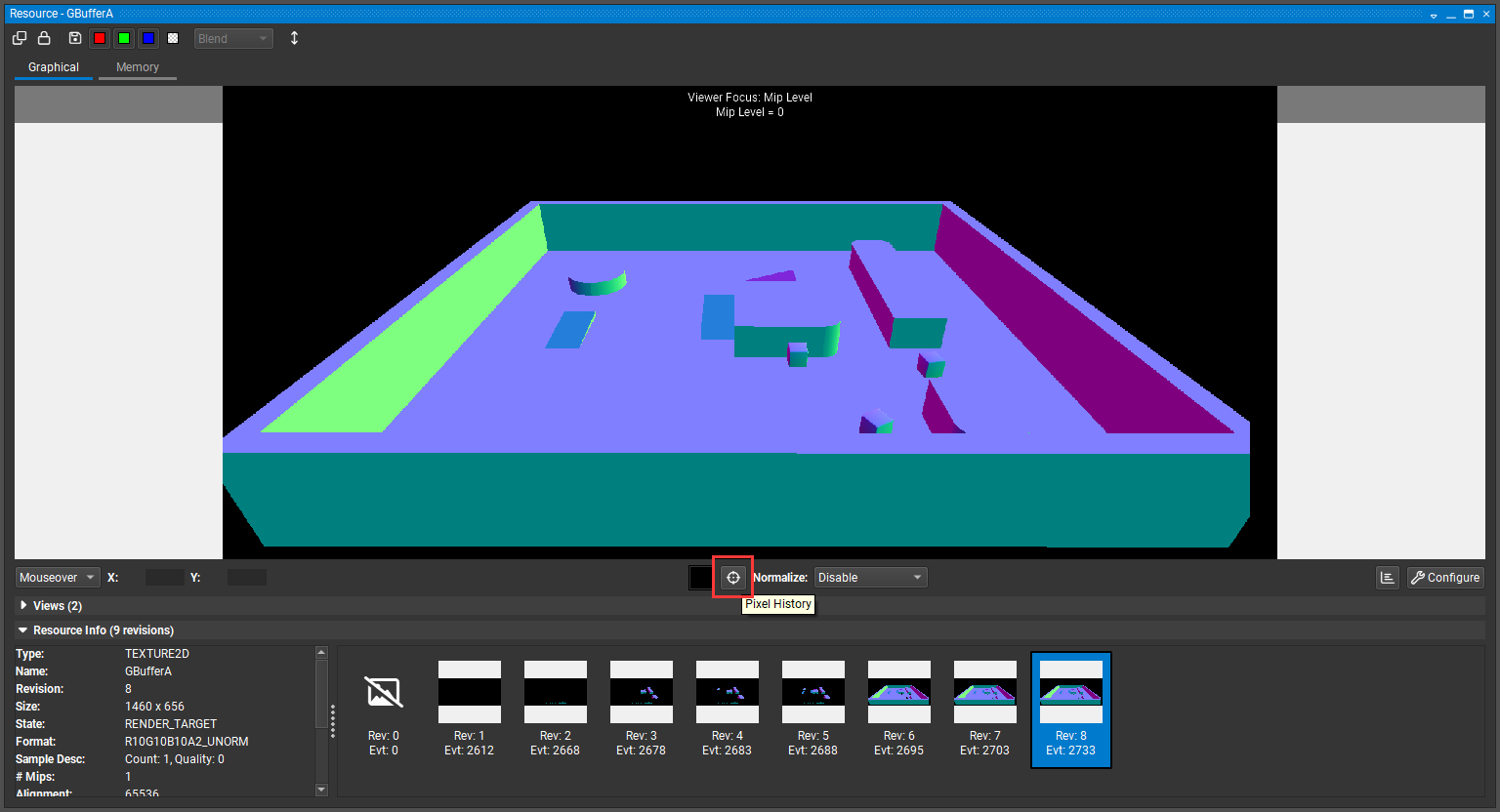

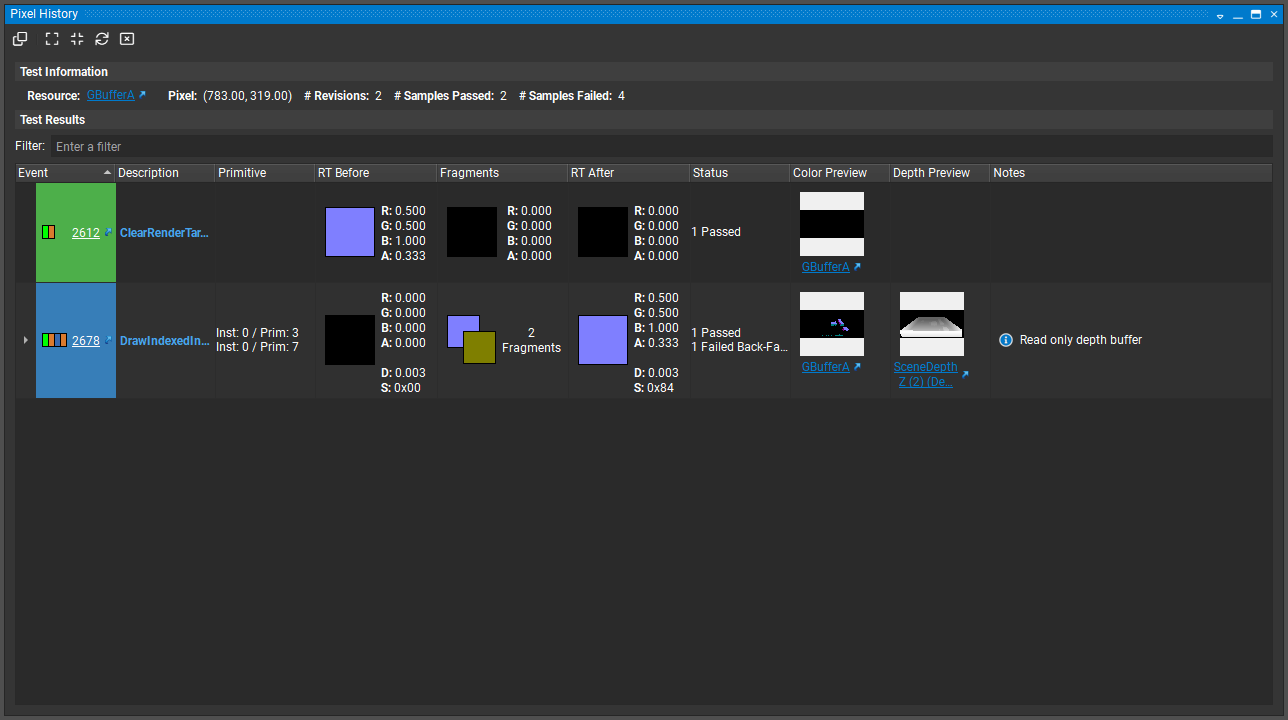

- PixelHistory:查看一个像素绘制过程的工具。可以通过在Resource中选择绘制的RT之后使用该工具点击想要查看的像素。

|

||||

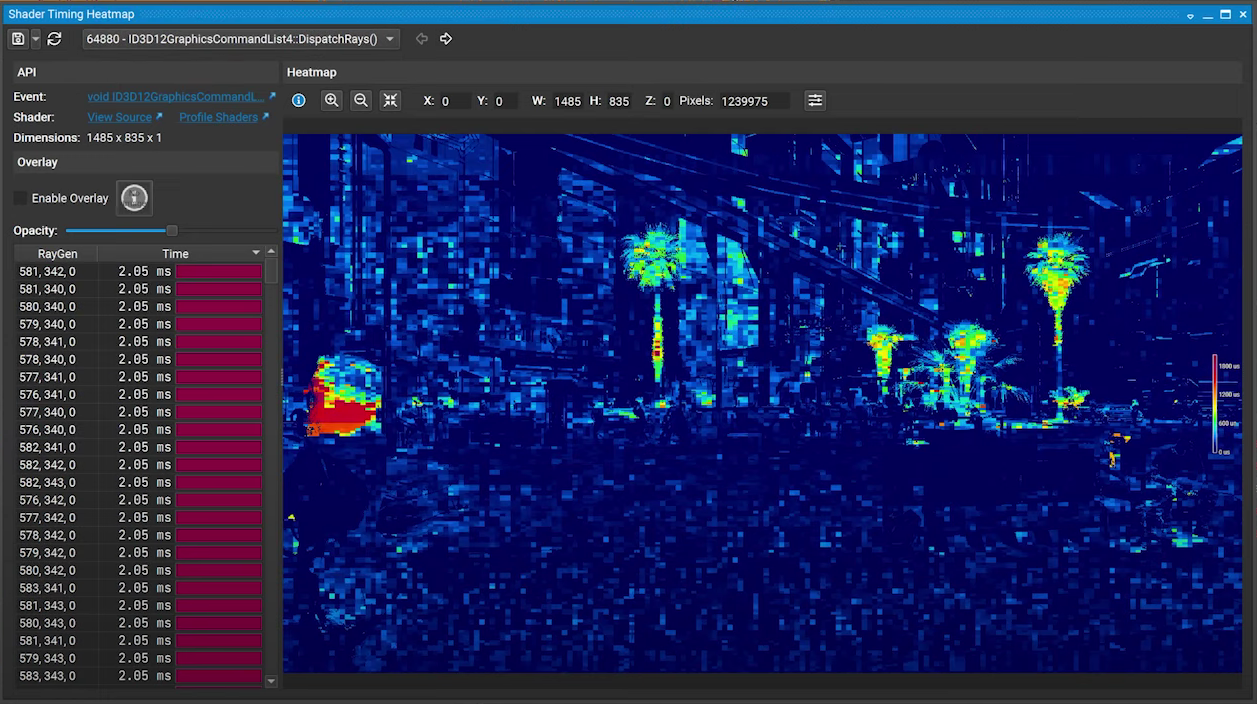

- Shader Timeing Heating:Rtx相关工具,可以查看Rtx Shader在屏幕上的资源占用分布图。但有bug。分析UE5的某个分发Ray事件必然会崩。

|

||||

|

||||

PS.Ctrl+滚轮放大与缩小Event时间轴;在左上角Frame Debugger里可以打开其他工具,所有的UI介绍可以参考https://docs.nvidia.com/nsight-tools/nsight-graphics/UserGuide/index.html#frame_debugging_profiling_ui

|

||||

|

||||

#### Generate C++ Capture

|

||||

进入工具,点击**Generate C++ Capture**后会捕获并且生成一个VS工程。并且显示以下界面:

|

||||

|

||||

|

||||

该功能与RenderDoc保存截帧文件类似,但NSight是截取当前帧的渲染情况并且生成一个不断渲染当前帧的程序以便后续复现与Debug。之后依次点击Build=>Execute=>Connect即可进入Frame Debugger界面。该工具还支持嵌入式Linux、桌面Linux。

|

||||

|

||||

#### GPU Trace

|

||||

NSight的截帧功能,在连接界面可以设置截帧范围(截取的帧数),另一个相比RenderDoc的优势就是比较2个帧文件。启动进程后,点击**Generate GPU Trace Capture**就可以截取帧文件。并进入类似Frame Debugger的界面。

|

||||

|

||||

|

||||

|

||||

同时可以设置为高级模式,以截取更多的信息:

|

||||

|

||||

|

||||

|

||||

#### System Trace

|

||||

需要额外下载Nsight Systems工具才能使用。该工具主要分析CPU与GPU直接交互情况。

|

||||

|

||||

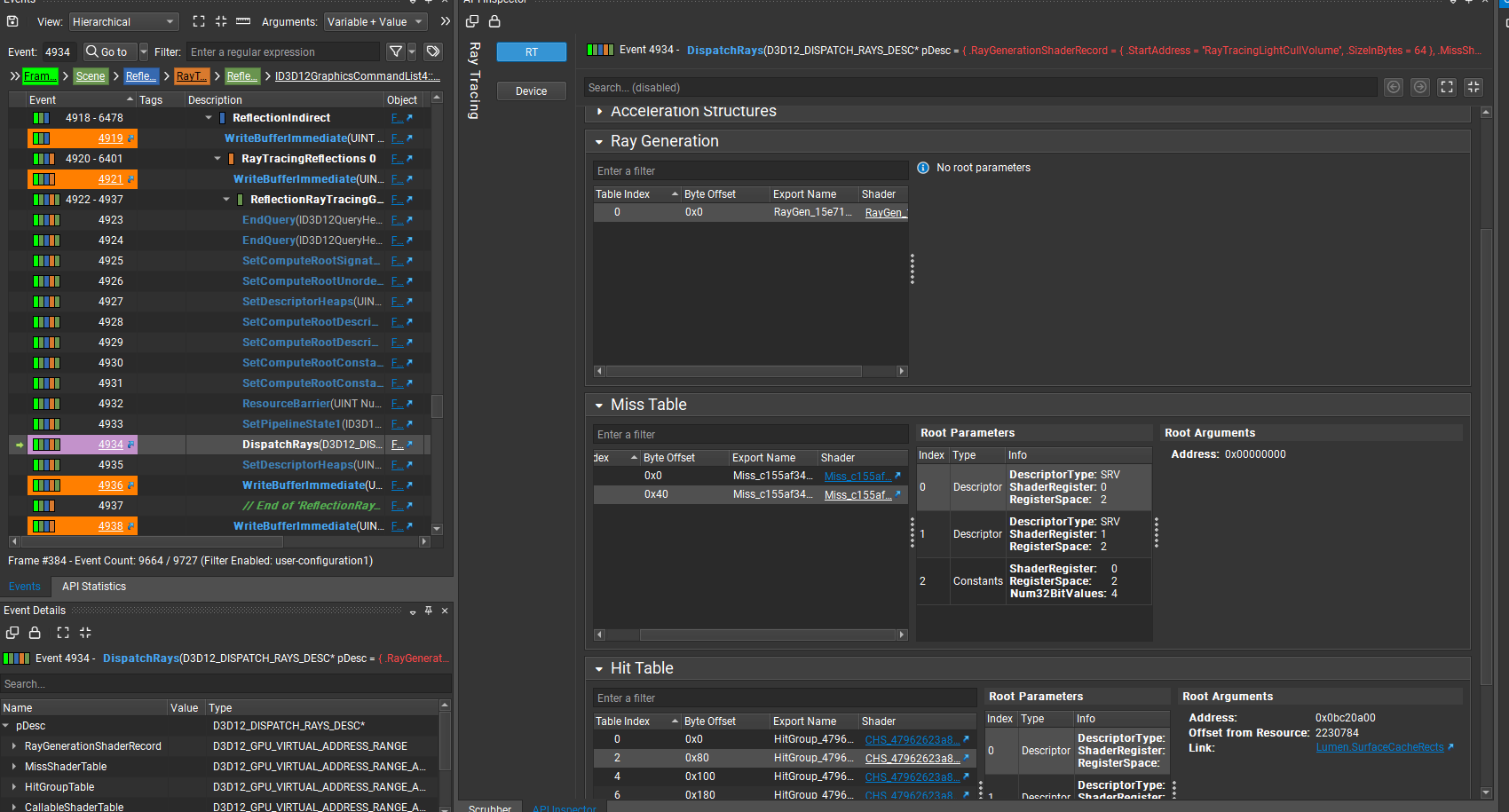

#### 其他Rt Shader相关的功能

|

||||

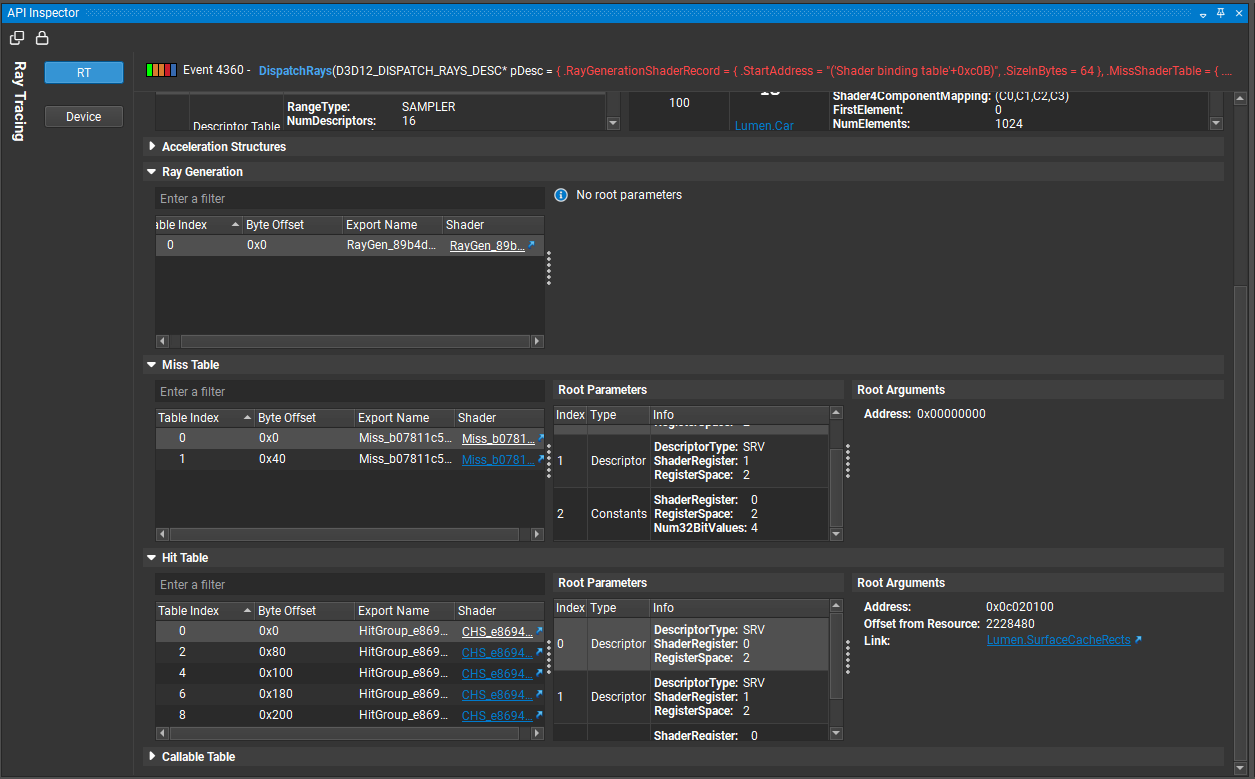

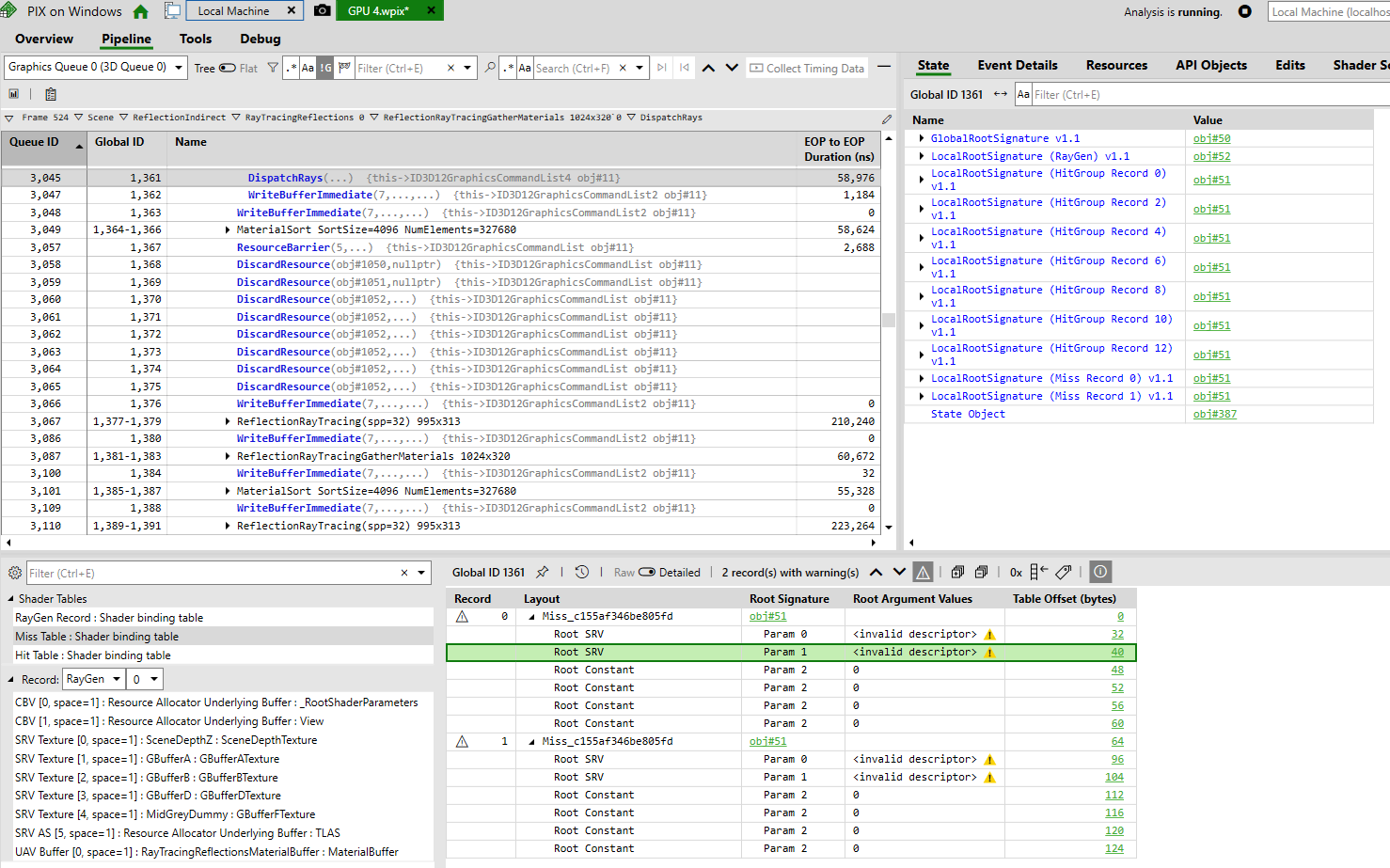

APIInspector的Rt Shader会显示额外所需的HitTable等数据:

|

||||

|

||||

|

||||

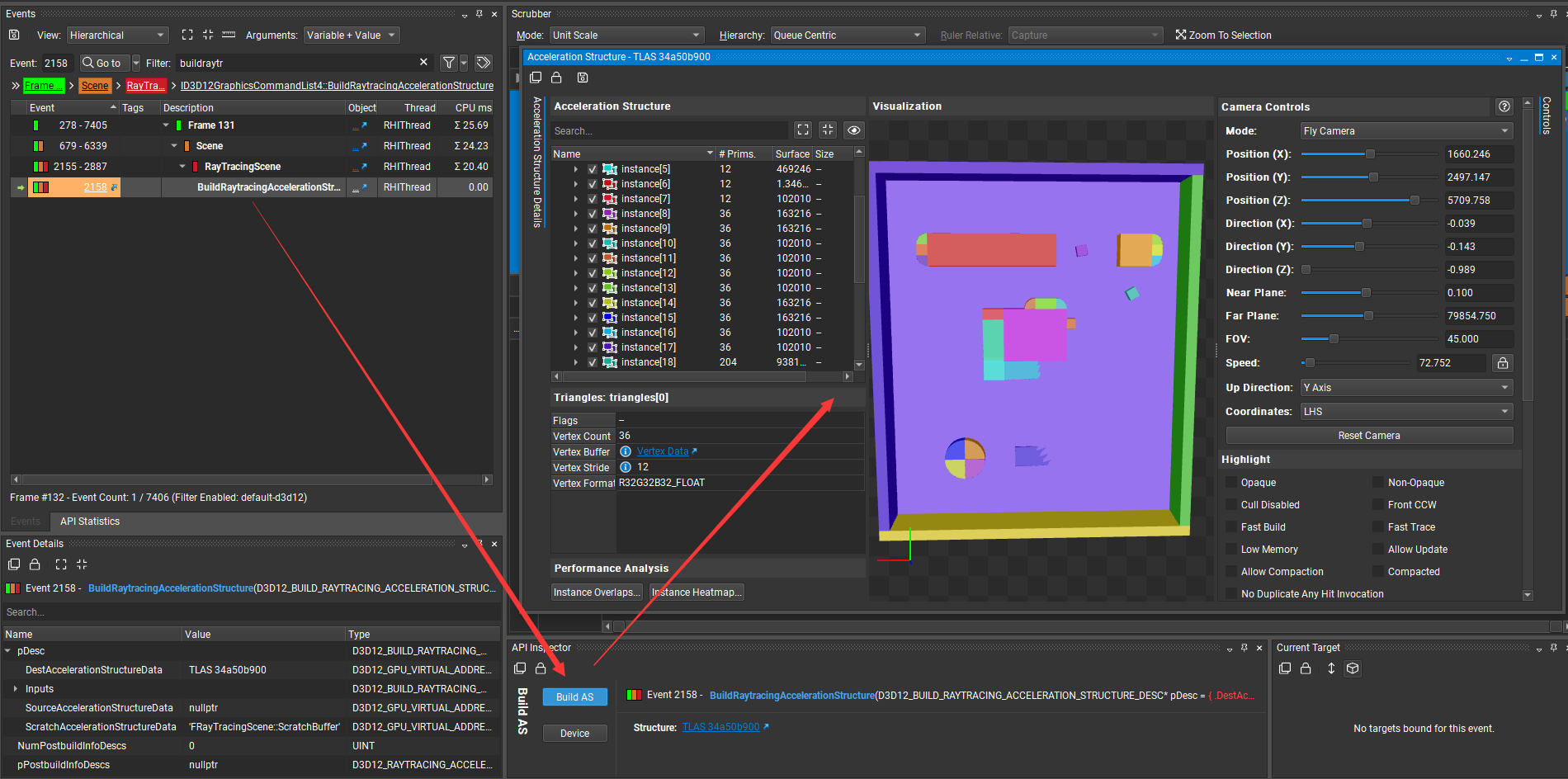

##### Acceleration Structure View

|

||||

首先可以看一下UE中的相关文档:https://docs.unrealengine.com/5.0/en-US/ray-tracing-performance-guide-in-unreal-engine/

|

||||

|

||||

- BLAS:Bottom Level Acceleration Structure Updates。静态模型的BLAS会在模型载入时构建。动态物体与骨骼物体会每帧构建。

|

||||

- TLAS:Top Level Acceleration Structure。TLAS会每帧构建。

|

||||

|

||||

在NSigh中可以从API Inspector或All Resource(只能显示BLAS)中打开并查看。

|

||||

|

||||

|

||||

|

||||

视角控制:

|

||||

- WASD — 向前、向后、向左或向右移动相机

|

||||

- 箭头键- 向前、向后、向左或向右移动相机

|

||||

- E/Q - 向上/向下移动相机

|

||||

- Shift/Ctrl - 更快/更慢地移动相机

|

||||

- 鼠标滚轮——放大/缩小

|

||||

- 鼠标左键 + 拖动- 向前或向后移动相机并向左或向右旋转

|

||||

- 鼠标右键 + 拖动- 旋转相机

|

||||

- 鼠标中间 + 拖动- 跟踪相机(向上、向下、向左、向右移动)

|

||||

- 鼠标左键 + 鼠标右键 + Drag — 跟踪相机(上、下、左、右)

|

||||

- ALT + 鼠标左键 + 拖动- 围绕选定几何体旋转相机

|

||||

- ALT + 鼠标右键 + 拖动- 放大/缩小

|

||||

- 双击或 F - 将相机聚焦在选定的几何体上

|

||||

@@ -0,0 +1,57 @@

|

||||

---

|

||||

title: UE5RayTracing篇-2-——Pix与NSight-Graphics补充

|

||||

date: 2022-11-11 17:53:44

|

||||

excerpt:

|

||||

tags:

|

||||

rating: ⭐

|

||||

---

|

||||

## 前言

|

||||

最近继续学习Rtx,所以就总结一下相关debug工具的使用方法。当然如果你是A卡用户大概就需要[【新鲜资讯】Radeon™光线追踪分析器(RRA)1.0正式上线](https://zhuanlan.zhihu.com/p/549772737)。

|

||||

|

||||

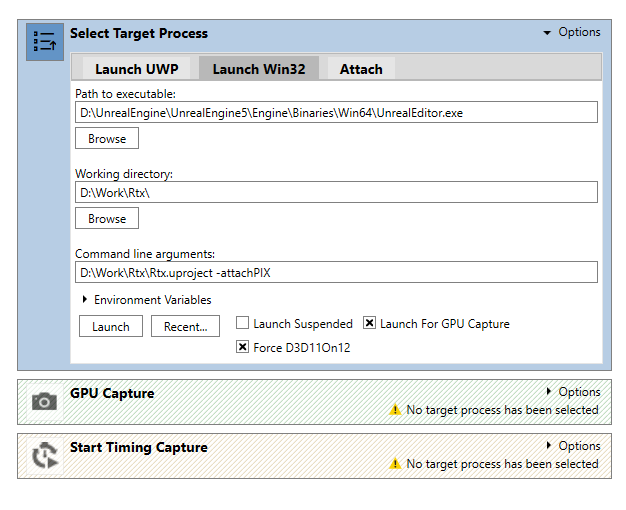

## Pix

|

||||

下载地址位于:https://devblogs.microsoft.com/pix/download/

|

||||

1. 首先启用`Pix for UnrealEngine`插件。

|

||||

2. 在`ConsoleVariables.ini`中添加`r.D3D12.AutoAttachPIX=1`,或者在启动命令也就是`CommandLineArguments`最后添加`-attachPIX`。

|

||||

3. 在Pix中设置启动参数,点击启动就可以截帧了。

|

||||

|

||||

>注意:Pix与RenderDoc插件冲突,需要关闭RenderDoc插件才能正常运行。

|

||||

|

||||

可以通过点击GUI中的照相机图标或者按下键盘上的PrintScreen(截图键)键来截帧。直接点击摄像机图标是没办法截到场景信息的,所以只能用鼠标点击场景窗口(让窗口获得焦点)之后再按截图键才能截到。

|

||||

|

||||

|

||||

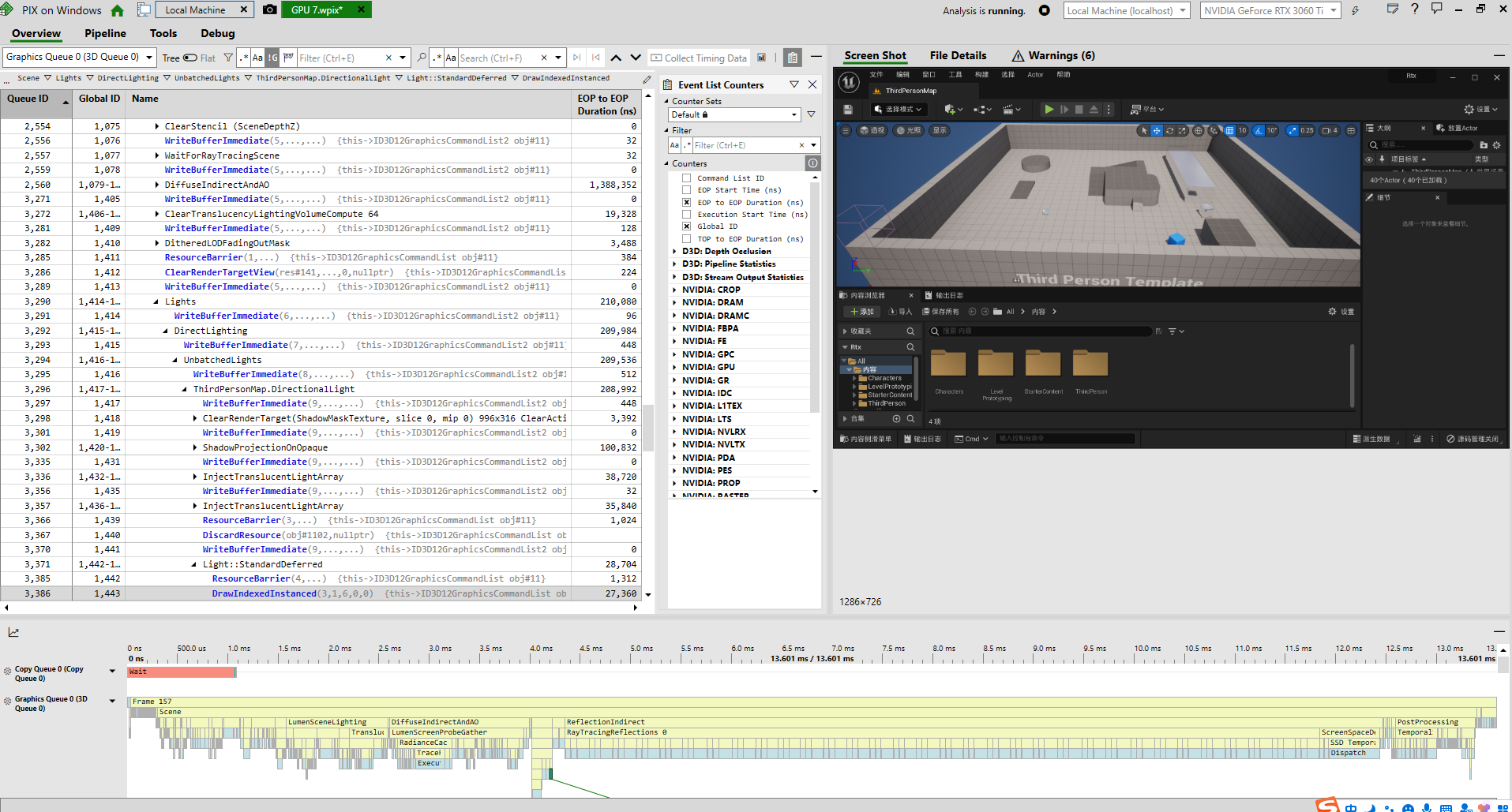

查看渲染过程只需要GPUCapture,如果要调试性能就需要使用TimingCapture。具体操作可以参考PIX的操作视频教程位于:https://www.youtube.com/watch?v=rLClOkrE47w&list=PLeHvwXyqearWuPPxh6T03iwX-McPG5LkB&index=2

|

||||

|

||||

PS.Collect Timing Data需要在win10上开启`开发人员模式`,具体操作为

|

||||

1. 打开开始菜单,输入`开发者`

|

||||

2. 进入`开发者选项`,勾选开发人员模式。

|

||||

|

||||

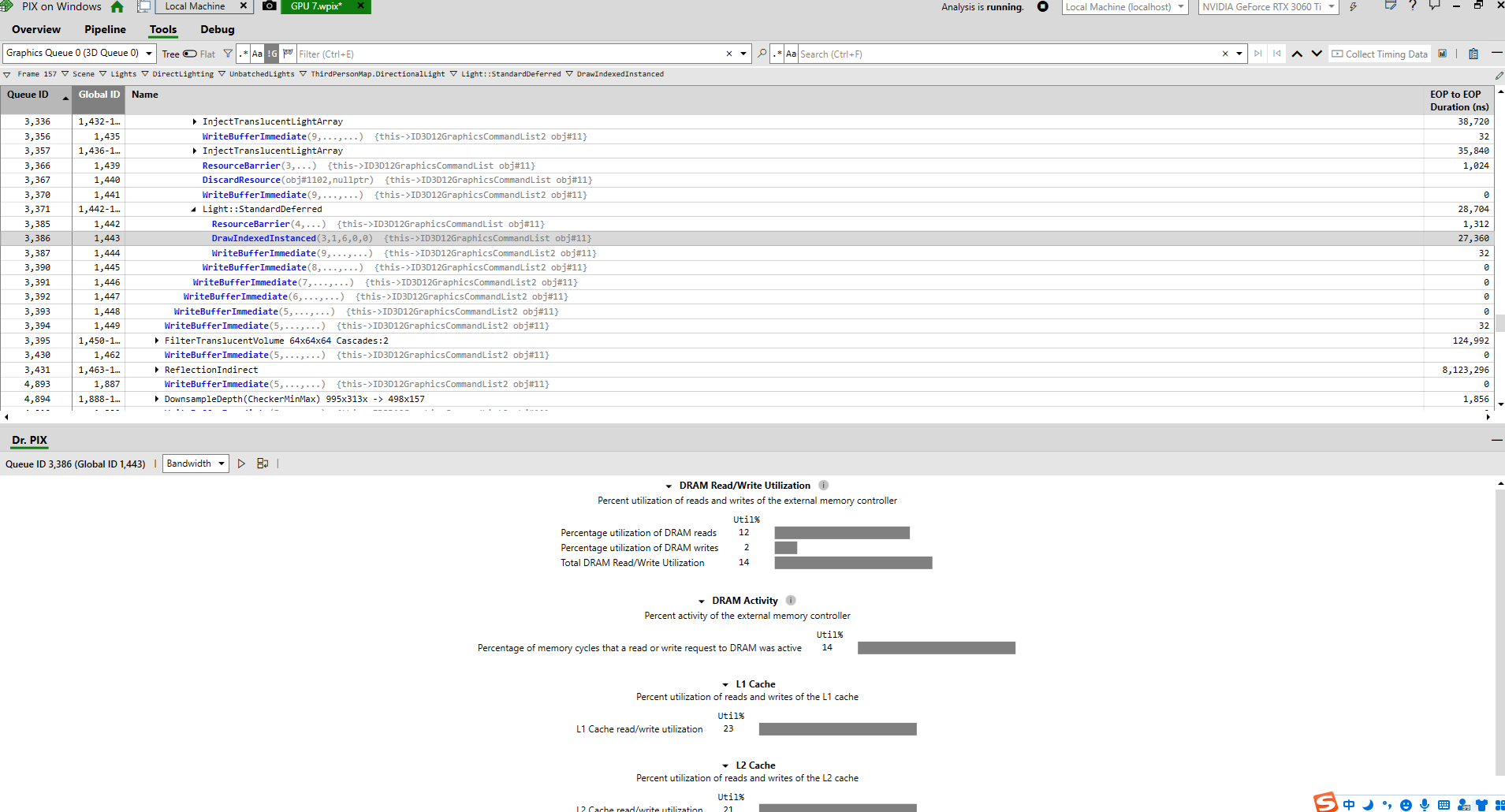

### 4个功能Tab

|

||||

Pix的主要功能集中在这4个Tab中。

|

||||

Overview:主要是展示一下EventList,在点击`CollectTimingData`下方会显示时间轴。

|

||||

|

||||

|

||||

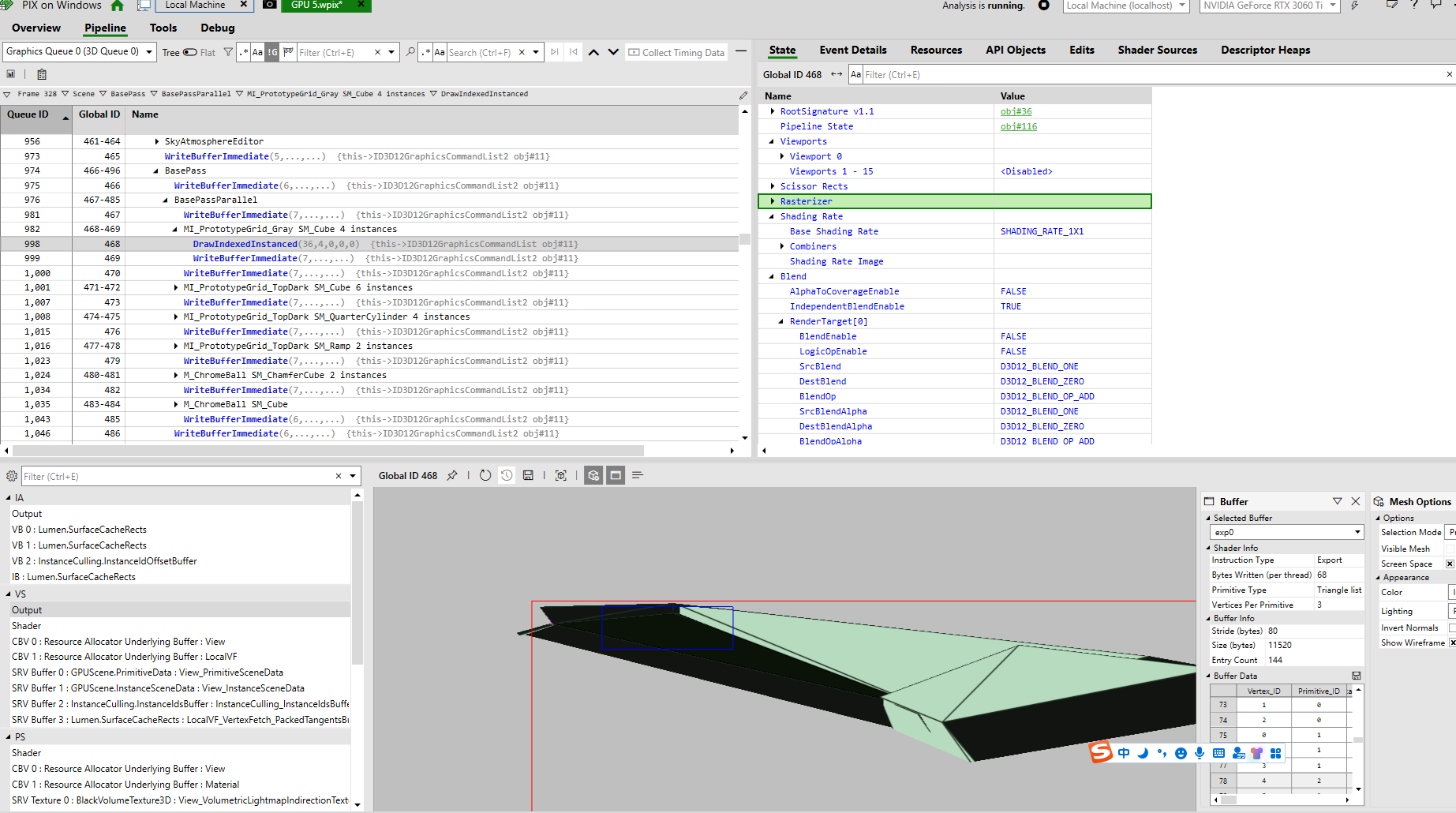

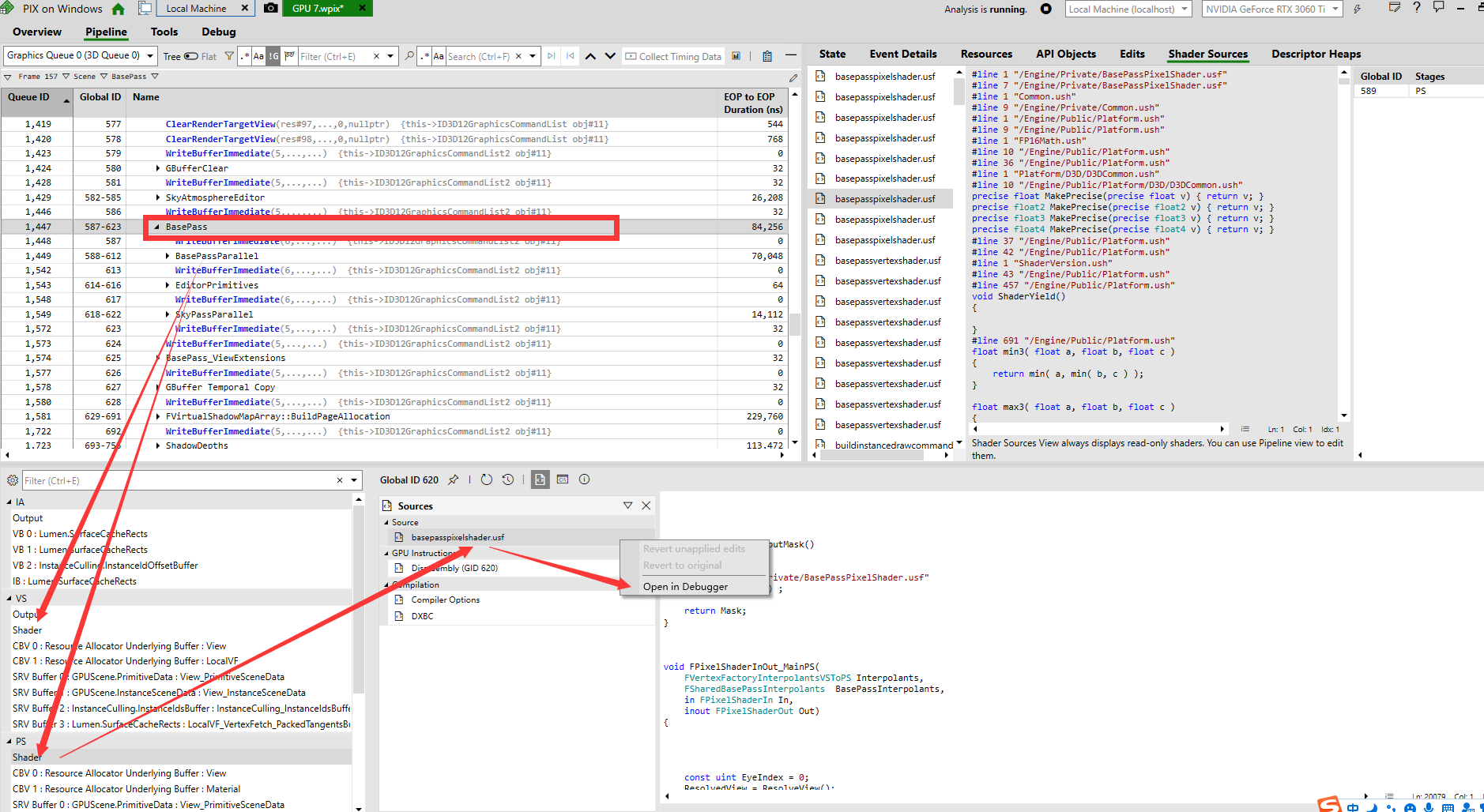

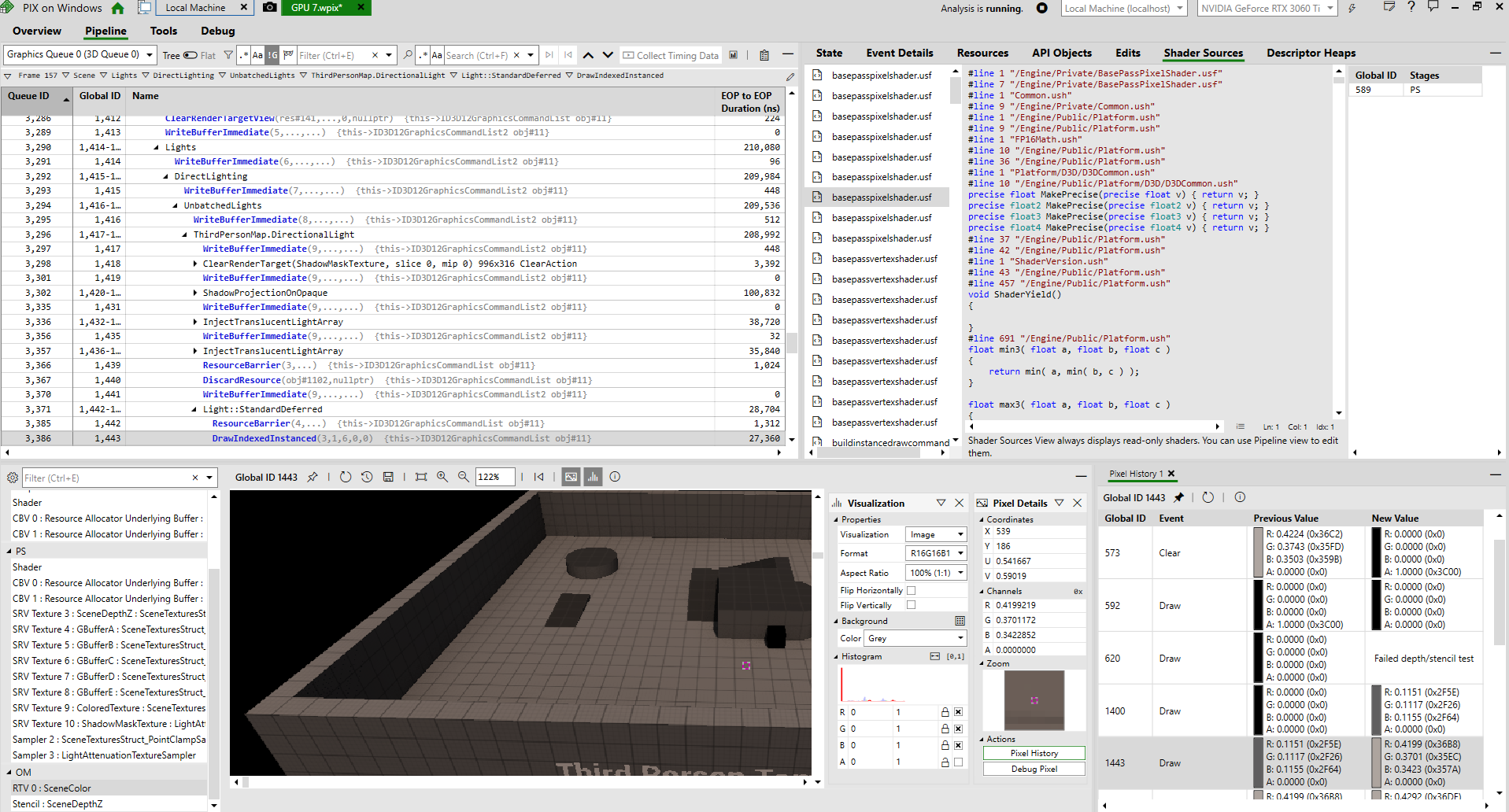

Pipeline:显示当前Event的Shader、管线状态以及其他相关数据。

|

||||

|

||||

|

||||

|

||||

想要DebugShader,可以在Pipeline找到对应Shader,并在Shader文件上右键,点击`Open In Debugger`后进行调试。

|

||||

|

||||

|

||||

当然也可以在输入的RT上双击鼠标左键,之后点击`DebugPixel`进行debug。

|

||||

|

||||

|

||||

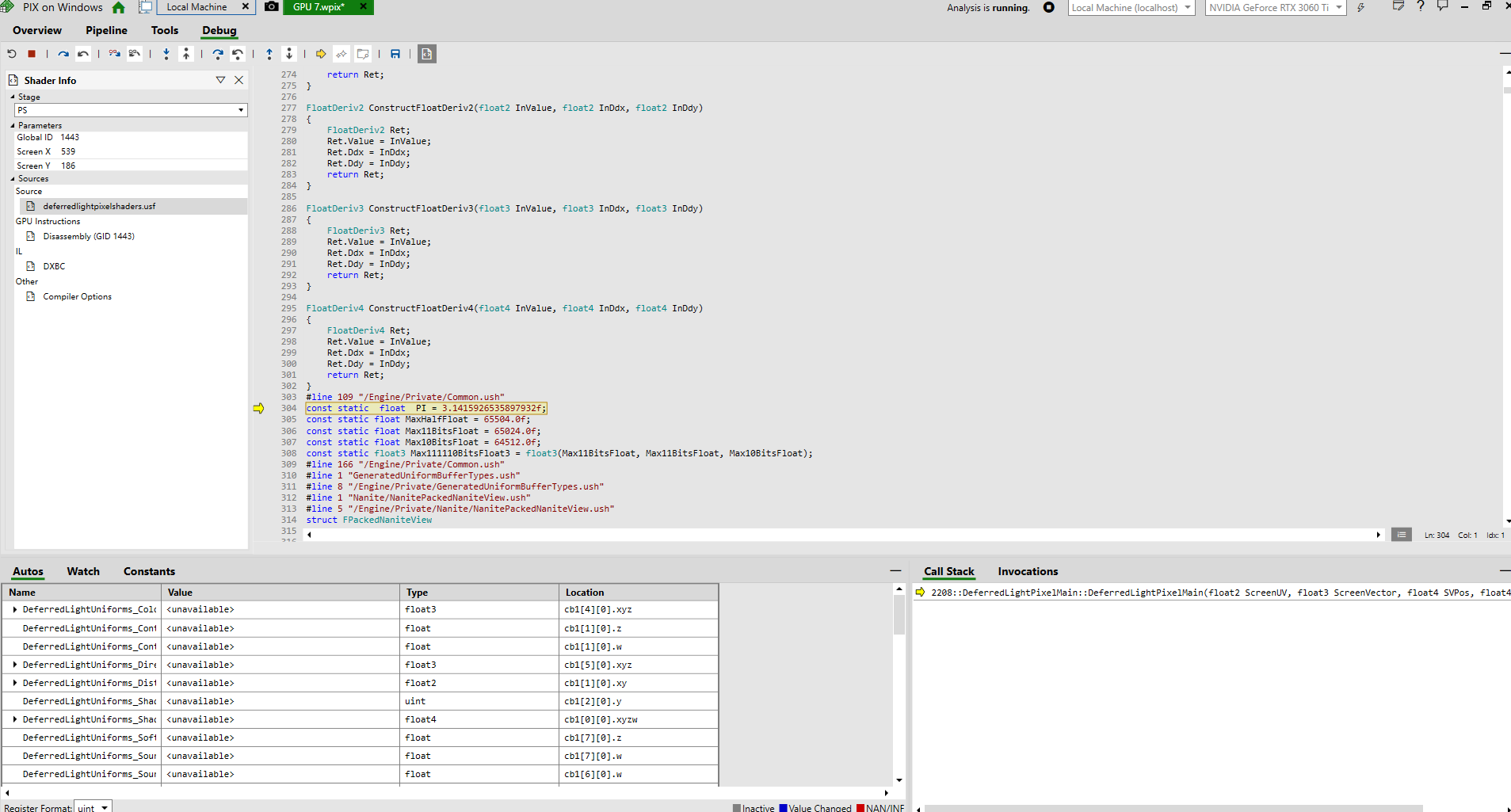

Debug:debug时需要点击左上方,Overview下面的运行按钮,这里我已经点了。这里我很好奇为啥没有类似Renderdoc的断点功能。

|

||||

|

||||

|

||||

Tools:大概是一个测试性能的工具,可以测试Basic Information、Depth/Stencil、Primitives and Rasterization、Bandwidth、TDR Analysis、ExecuteIndirect。

|

||||

|

||||

|

||||

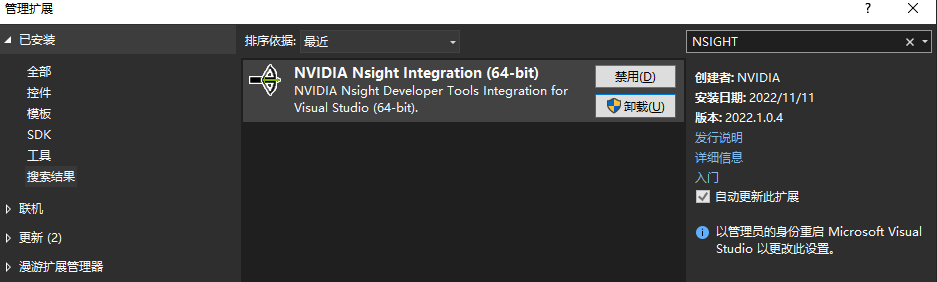

## NSight For VisualStudio

|

||||

之后测试了一下NSight的VS插件,虽然本质上就是一个帮你填写启动参数的工具,但的确方便。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

测试完之后就能查看光追的一些参数。

|

||||

|

||||

77

03-UnrealEngine/Rendering/Film/CAD可视化与MovieRenderQueue笔记.md

Normal file

77

03-UnrealEngine/Rendering/Film/CAD可视化与MovieRenderQueue笔记.md

Normal file

@@ -0,0 +1,77 @@

|

||||

---

|

||||

title: CAD可视化与MovieRenderQueue笔记

|

||||

date: 2021-09-16 13:55:15

|

||||

tags: Film

|

||||

rating: ⭐️

|

||||

---

|

||||

## 前言

|

||||

本文为一些个人经验总结,仅供参考。

|

||||

|

||||

## DataSmith

|

||||

### ReTessellation

|

||||

对DataSmith导入的物体进行重新细分(增加或者减少面数),这样就不用重新导入了。

|

||||

|

||||

## DataPrep Tools

|

||||

可以代替python来实现Asset处理自动化。当然会Python就可以定制自动化命令了。

|

||||

|

||||

## 初始化

|

||||

1. 将曝光单位设置成EV100(可选)。

|

||||

2. 使用SM_ColorCalibrator调整场景曝光度。(推荐使用Automotive Materials中BP_Calibration)

|

||||

3. 仅使用天光作为照明源。环境球使用引擎的SM_SkySphere。

|

||||

4. 启用r.RayTracing.Reflections.ReflectionCaptures,使用ReflectionCaptures作为最后一次反射反弹结果。

|

||||

|

||||

## 解决临时轴心问题

|

||||

1. 创一个空Actor作为轴心并设置成Moveable,之后将其移动到对应位置。

|

||||

2. 将CAD模型以及其根物体都改成Moveable,之后将之前的空Actor作为root节点。

|

||||

|

||||

## 使用Automotive Materials的问题

|

||||

在Raytracing下使用Automotive Materials会出现第二次反射物体变黑的问题,这是官方做的优化措施,但CAD产品可视化会注重反射效果,所以需要把这个措施给去掉。具体做法是把父材质中最后的MF_Bounce_Rough去掉就可以了。

|

||||

|

||||

## MovieRenderQueue

|

||||

### 输出Alpha

|

||||

Movie Render Queue中有.exr和.png两种图片格式可输出带Alp通道,但仅勾选“output Alpha"还不行。须在项目设置中找到”Enable alpha channel support in post processing“(在后期处理中启用透明度通道支持)改为“Linear color space only”(仅限线性空间颜色)。

|

||||

|

||||

>勾选“output Alpha"已经被替换为Accumulate Alpha选项,在Output选项卡中。

|

||||

|

||||

同时还需要将天空球设置为Hidden In Game。

|

||||

|

||||

### 抗锯齿:

|

||||

不管怎么设置画面还是会出现一些噪点,如果是制作视频可以使用MovieRenderQueue来解决,本人使用的参数为:

|

||||

- Temporal Sample Count:16

|

||||

- Render Warm Up Count:64

|

||||

- Engine Warm Up Count:64

|

||||

|

||||

本人只需要好的反射效果,所以TAA采样数不会设置太高。其他有动态模糊以及其他与TAA相关的效果,就需要适当把Temporal Sample Count提高了。

|

||||

|

||||

在抗锯齿中

|

||||

关闭TAA

|

||||

|

||||

测试结果:渲染结果没有锯齿,但部分反射效果会有微小锯齿

|

||||

|

||||

### 控制台变量:

|

||||

- r.RayTracing.Reflections.MaxBounce 7

|

||||

- r.RayTracing.Reflections.SamplesPerPixel 64

|

||||

|

||||

7次光线反弹以及64spp,效果已经达到要求了。

|

||||

|

||||

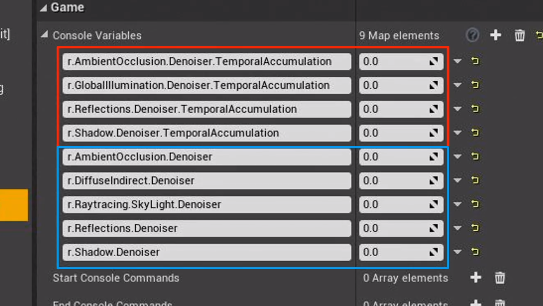

### 关闭降噪器

|

||||

使用MovieRenderQueue时,因为不太关注实时性能,所以可以关闭降噪器来提高渲染效果精度。

|

||||

- r.AmbientOcclusion.Denoiser: 0

|

||||

- r.DiffuseIndirect.Denoiser: 0

|

||||

- r.RayTracing.SkyLight.Denoiser: 0

|

||||

- r.Reflections.Denoiser: 0

|

||||

- r.Shadow.Denoiser: 0

|

||||

- r.RayTracing.GlobalIllumination.Denoiser: 0

|

||||

|

||||

经过测试,在关闭反射降噪器之后,对于拉丝金属表面这种有微小细节的表面,细节会锐利很多。

|

||||

|

||||

## 修复渲染Slot第一帧时的问题

|

||||

在使用Sequence以及MovieRenderQueue渲染的时候经常发现Slot的第一帧会出现渲染错误。解决方法是将CameraCut中的轨道往前拉1~2帧即可。

|

||||

|

||||

## 增加物体运动的连贯感

|

||||

简单的方法就是使用动态模糊或是提高帧数。但我制作的视频可能会随时暂停查看具体细节,所以我选择提高帧数并且关闭运动模糊。

|

||||

|

||||

## DLSS

|

||||

DLSS可以在同一画质下提高帧率。因此你可以在使用DLSS的情况下适当提高采样以减少噪点。

|

||||

|

||||

需要注意目前版本不会对MovieRenderQueue产生效果(4.27已经可以了)。

|

||||

32

03-UnrealEngine/Rendering/Film/使用MovieRenderQueue输出视频格式.md

Normal file

32

03-UnrealEngine/Rendering/Film/使用MovieRenderQueue输出视频格式.md

Normal file

@@ -0,0 +1,32 @@

|

||||

---

|

||||

title: 使用MovieRenderQueue输出视频格式

|

||||

date: 2023-04-28 11:05:46

|

||||

excerpt:

|

||||

tags:

|

||||

rating: ⭐

|

||||

---

|

||||

|

||||

# 前言

|

||||

具体可以参考**Command Line Encoder**章节,官方文档:https://docs.unrealengine.com/5.1/en-US/cinematic-rendering-export-formats-in-unreal-engine/

|

||||

|

||||

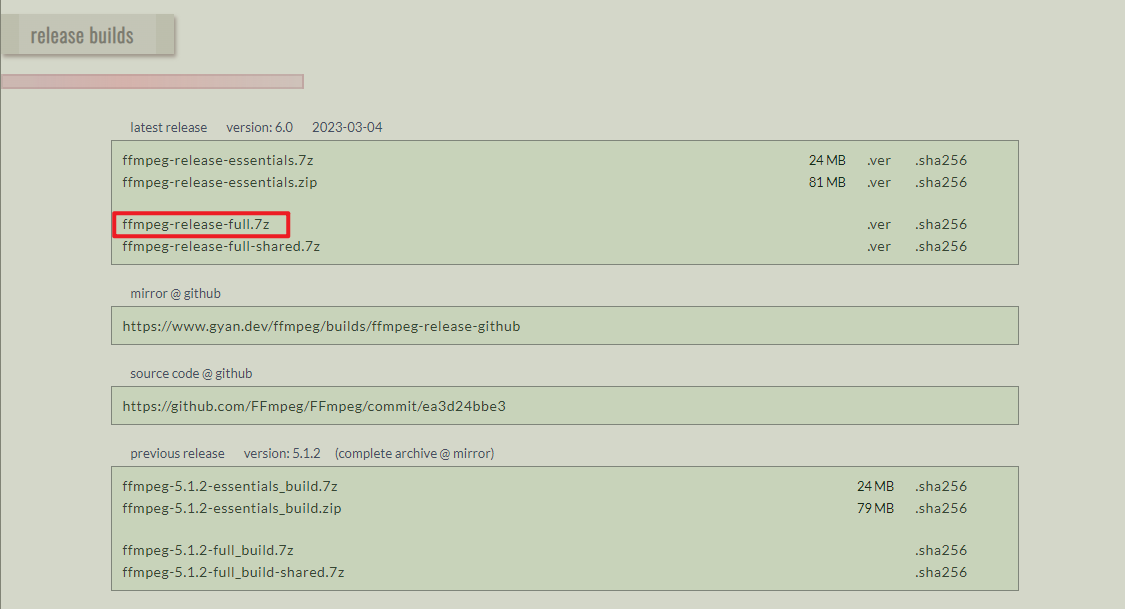

# 下载编码器

|

||||

首先我们需要下载编码器,这里使用ffmpeg。下载地址:

|

||||

https://ffmpeg.org/download.html#build-windows

|

||||

|

||||

|

||||

这里我选择第一个网址,之后选择一个FullBuild版本即可。

|

||||

|

||||

|

||||

# 设置编码器

|

||||

在`ProjectSettings - Plugins - Movie Pipeline CLI Encode`中进行设置。

|

||||

- Executable Path:设置ffmpeg.exe的路径。

|

||||

- Video Codec:填写视频编码格式,我这里填写libx264。

|

||||

- Audio Codec:填写音频编码格式,我这里填写aac。

|

||||

- Output File Extension:填写视频后缀名,我这里填写mp4。

|

||||

|

||||

具体可以参考doc/ffmpeg-codecs.html的**Video-Encoders**与**Audio-Encoders**,以及doc/ffmpeg-formats.html。

|

||||

|

||||

# 输出用于剪辑的更高质量视频

|

||||

具体可以参考官方文档的**Apple ProRes Video Codecs**或**Avid DNx Video Codecs**章节。

|

||||

|

||||

大致步骤是启用**Apple ProRes Media**或**Avid DNxHR/DNxMXF Media Plugin**插件。之后就可以在MRQ中添加输出**Apple ProRes**或**Avid DNx [8bit]**,最终输出的格式为**mov**与**mxf**。

|

||||

81

03-UnrealEngine/Rendering/Film/提高光线追踪反射效果.md

Normal file

81

03-UnrealEngine/Rendering/Film/提高光线追踪反射效果.md

Normal file

@@ -0,0 +1,81 @@

|

||||

---

|

||||

title: 提高光线追踪反射效果

|

||||

date: 2021-02-07 13:55:15

|

||||

tags: Film

|

||||

rating: ⭐️

|

||||

---

|

||||

## 关闭与光追冲突的选项

|

||||

|

||||

## 让反射效果柔和

|

||||

r.Reflections.Denoiser 1

|

||||

|

||||

## 解决低精度法线造成的反射效果不佳的问题

|

||||

- 项目设置-Engine-Rendering-Optimizations-Support depth only index=>HeightPrecisionNormals

|

||||

- 针对个别物体,可以通过勾选StaticMesh的Use High Precision Tangent Basis,之后电解Apply Changes

|

||||

|

||||

## 对最后一次光线反弹后对环境球进行采样

|

||||

r.RayTracing.Reflection.ReflectionCaptures 1

|

||||

|

||||

## 调整天光的Raytracing采样数目

|

||||

默认是4,可以适当提高

|

||||

|

||||

## MovieRenderQueue

|

||||

输出设置

|

||||

- Anti-Aliasing:SpatialSampleCount:5

|

||||

- TemporalSampleCount:3

|

||||

- Override AntioAliasing:true

|

||||

|

||||

文档中的参数(rtx2080ti):

|

||||

- 空间采样数量(Spatial Sample Count):1

|

||||

- 临时采样数量(Temporal Sample Count):64

|

||||

- 覆盖抗锯齿模式(Override Anti Aliasing Mode):已启用(Enabled)

|

||||

- 抗锯齿方法(Anti Aliasing Method):无(None)

|

||||

- 渲染预热计数(Render Warm Up Count):120

|

||||

- 引擎预热计数(Engine Warm Up Count):120

|

||||

|

||||

### Console Variable

|

||||

|

||||

- r.MotionBlurQuality: 4

|

||||

- r.MotionBlurSeparable: 1

|

||||

- r.DepthOfFieldQuality: 4

|

||||

- r.BloomQuality: 5

|

||||

- r.Tonemapper.Quality: 5

|

||||

- r.RayTracing.GlobalIllumination: 1

|

||||

- r.RayTracing.GlobalIllumination.MaxBounces: 2

|

||||

- r.RayTracing.Reflections.MaxRoughness: 1

|

||||

- r.RayTracing.Reflections.MaxBounces: 2

|

||||

- r.RayTracing.Reflections.Shadows: 2

|

||||

|

||||

- r.RayTracing.GlobalIllumination.FinalGatherDistance [number of units]

|

||||

|

||||

### 其他光线追踪控制台命令

|

||||

许多光线追踪特征值已针对实时使用进行了优化。这意味着它们通过减少样本数量,限制最大反射数量或其他措施,从而牺牲质量以换取性能。

|

||||

|

||||

下面是你可以在影片渲染队列中使用的更多控制台变量,以质量换取性能。这一点特别有用,因为仅当从队列运行渲染时,此功能才执行这些命令,并且对于你可能已在编辑器中的后期处理体积中设置的任何实时设置,该设置不会永久覆盖。

|

||||

|

||||

逐像素采样: 每个光线追踪功能都可以使用很少或很多样本生成最终结果。去噪器使用像素较少,通常用于计算量繁重的任务。借助影片渲染队列,你可以选择禁用降噪器,并增加逐像素样本,以便提高质量。

|

||||

|

||||

部分示例为:

|

||||

- r.RayTracing.Reflections.SamplesPerPixel

|

||||

- r.RayTracing.Shadow.SamplesPerPixel

|

||||

- r.RayTracing.GlobalIllumination.SamplesPerPixel

|

||||

|

||||

最大反射数(Maximum Number of Bounces):在场景中进行多次反射或光线反射,生成更自然、更高质量的效果,从而让光线跟踪功能(例如反射、全局光照和透明涂层)从中受益。这些设置对于实时渲染来说开销很大。

|

||||

- r.RayTracing.GlobalIllumination.MaxBounces

|

||||

- r.RayTracing.Reflections.MaxBounces

|

||||

- r.RayTracing.Reflections.MaxUnderCoatBounces

|

||||

|

||||

天空光照(Sky Light): 在实时光线追踪中,为反射和全局光照等功能计算每帧时,由于距离无限,天空光照可能造成额外的开销。

|

||||

使用影片渲染队列工作时,以下CVAR可以在光线跟踪中启用其他天空光照选项:

|

||||

- r.RayTracing.GlobalIllumination.EvalSkyLight

|

||||

- r.RayTracing.SkyLight.EnableTwoSidedGeometry

|

||||

- r.RayTracing.Reflections.RayTraceSkyLightContribution

|

||||

- r.RayTracing.SkyLight.EnableMaterials

|

||||

|

||||

## 视频笔记

|

||||

地址:https://www.bilibili.com/video/BV1dZ4y1H7f2

|

||||

|

||||

|

||||

### 需要调节的参数

|

||||

- 灯光的采样数目

|

||||

- 后处理里搜索Sample 反射设置为16 AO 10

|

||||

206

03-UnrealEngine/Rendering/Lighting/Ue4照明技术引导视频笔记.md

Normal file

206

03-UnrealEngine/Rendering/Lighting/Ue4照明技术引导视频笔记.md

Normal file

@@ -0,0 +1,206 @@

|

||||

# Ue4照明技术引导视频笔记(静态光照部分)

|

||||

https://www.youtube.com/watch?v=jCsrWzt9F28&list=WL&index=7&t=0s

|

||||

https://forums.unrealengine.com/unreal-engine/events/107078-training-livestream-lighting-techniques-and-guides-jan-24-live-from-epic-hq?134388=

|

||||

https://cdn2.unrealengine.com/CommunityTab%2FEnglish%2F2017%2FJan+23%2FLiveStream_Lighting-11f85d1762b463154b5f53f7468e135f65955bed.zip

|

||||

https://wiki.unrealengine.com/LightingTroubleshootingGuide

|

||||

|

||||

## Volume

|

||||

### Lightmass Importance Volume

|

||||

用于提高指定区域内的LightMap烘焙效果(主要是间接照明),区域外的默认为低质量效果。

|

||||

### LightMass Character Indirect Detail Volume

|

||||

提高区域内的间接光照缓存的密度(缓存点会更加密集)。

|

||||

## 间接光照缓存

|

||||

### 模型中光照选项

|

||||

|

||||

|

||||

## LightMass设置

|

||||

### 解决LightMass漏光问题

|

||||

1、提高间接光照的质量WorldSetting-》Indirect Lighting Quality<br>

|

||||

2、降低WorldSetting-》Indirect Lighting Smoothness的值(但是构建时间会增加)

|

||||

3、尽量使用整块模型

|

||||

|

||||

## 地形阴影

|

||||

### 远距离阴影(Far Shadow)

|

||||

一般是方向光作用在地形上的阴影,使用的是Cascaded Shadow Maps。<br>

|

||||

相关选项有:

|

||||

方向光源-》Cascaded Shadow Maps-》 Far Shadow Cascade Count(阴影精细程度)与Far ShadowDistance(显示距离)

|

||||

|

||||

可以通过show=》advanced=》ShadowFrustums显示阴影调试(只对方向光有效)。以此可以观察Cascaded的级数切换距离。

|

||||

|

||||

地形是默认开启Far Shadow的,Actor需要手动开启。

|

||||

|

||||

## 自发光物体

|

||||

后处理空间中除了设置GI倍率还可以自定义GI的颜色。

|

||||

|

||||

讲了自发光材质的GI,这里有了个取巧的方式,通过PostProcessVolume绑定自发光物体来调整Gi,好尴尬

|

||||

|

||||

2017年的版本还是通过LPV来实现的GI。

|

||||

|

||||

## LightMass Debug

|

||||

在构建选项里有一个Use Error Coloring选项,可以用来标记UV不合格的物题,但在产品级质量构建中则不会显示这些Debug标记。

|

||||

|

||||

## Lighting Info(位于构建按钮菜单中)

|

||||

里面可以调整LightMap渲染密度选项、空间占用大小以及分辨率调整。

|

||||

|

||||

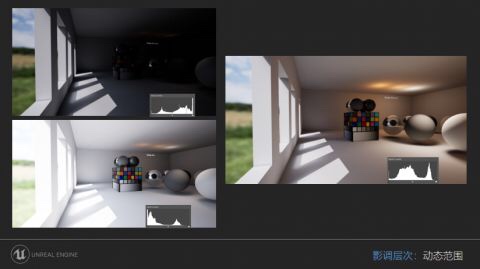

# Ue4照明技术引导视频笔记(动态光照部分)

|

||||

https://www.youtube.com/watch?v=nm1slxtF_qA

|

||||

|

||||

https://forums.unrealengine.com/unreal-engine/events/113380-training-livestream-lighting-techniques-and-guides-2-dynamic-light-april-4-live-from-epic-hq?140547=

|

||||

## 距离场光线追踪技术

|

||||

首先需要开启距离场生成,在项目设置——渲染——灯光——勾选 生成模型距离场 选项。

|

||||

|

||||

级联阴影在显示远阴影时为了效果会增加阴影级数这样会增加消耗,而距离场阴影的消耗相对较小,所以会采样近距离级联远距离距离场阴影的配合方式。同时它可以解决因为屏幕空间渲染技术而导致的阴影失真的问题。另一个主要用处就是距离场AO了。或者可以使用距离场来写Shader。

|

||||

|

||||

模型距离场(在模型Asset设置中有个分辨率缩放选项)的分辨率会影响阴影效果(投射到别的物题上的阴影与自阴影)。从视频可以看出阴影缺少了很多细节而且并不正确。此时勾选Show——Visualize——MeshDistanceField,查看模型距离场,从而选择合适的分辨率对debug阴影有很大帮助。

|

||||

### 如何开启

|

||||

需要在灯光处勾选“Ray Tracing Distance Field Shadow”选项开启。

|

||||

|

||||

### 较为的使用场景

|

||||

渲染树木植被等高面数、复杂物体的阴影。

|

||||

### 植被渲染注意

|

||||

对于树叶等需要双面渲染的物体,需要在模型设置中勾选Two-Sided Distance Field Generation,以生成正确的距离场。

|

||||

### 级联阴影切换

|

||||

可以对灯光中的Cascaded Shadow Maps——Dynamic Shadow Distance MoveableLight进行设置,来达到级联阴影与软阴影的切换(靠近物体会切换成级联阴影)

|

||||

|

||||

### 几个调试用命令

|

||||

r.Shadow.MaxResolution 可选参数256~2048默认2048

|

||||

r.Shadow.MinResolution 可选参数16~128默认32

|

||||

r.Shadow.FadeResolution 可选参数64~2048默认64

|

||||

r.Shadow.DistanceScale 可选参数0.5~2默认1

|

||||

r.Shadow.RadiusThreshold 可选参数0.01~0.5默认0.03

|

||||

r.Shadow.CSM.MaxCascades 可选参数1~16默认3

|

||||

r.Shadow.CSM.TransitionScale可选参数0~2默认1

|

||||

r.ShadowQuality 可选参数1~5默认5

|

||||

r.LightFunctionQuality 可选参数0~2默认2

|

||||

r.DistanceFieldShadowing True~False默认True

|

||||

r.DistanceFieldAO True~False默认True

|

||||

r.ParticleLightQuality 可选参数0~2默认1

|

||||

### 其他注意事项

|

||||

光源中的SourceRadius会对软阴影产生影响(学过光追的人都知道为什么)

|

||||

|

||||

## 胶囊阴影

|

||||

因为也是一种软阴影方案,所以光源的LightSourceAngle选项也会对此产生影响。

|

||||

### 如何启用

|

||||

1. 在角色Asset中指定ShaowPhysicsAsset。

|

||||

2. 在角色Asset的Lighting选项卡中勾选Capsule Direct Shadow或者Capsule Indirect Shadow

|

||||

|

||||

## 接触阴影(Contact Shadows)

|

||||

ContactShadowLength参数大于0时就会开启,默认是关闭的。(视频使用值为0.02)

|

||||

### 原理

|

||||

将接触阴影的长度设为大于零的值后,渲染器将通过场景的深度缓存从像素的位置到光源进行光线追踪。举一个典型的例子来说,将接触阴影长度的最大值设为 1,此处的 1 则代表光线遍历整个屏幕。而将接触阴影长度的值设为 0.5 则意味着光线遍历半个屏幕。注意:场景深度缓存中的获得的采样将保持不变,意味着增加接触阴影的长度时将出现更多噪点(穿帮)。长度为 0.75 的接触阴影比长度为 0.1 的接触阴影生成的噪点更多。

|

||||

### 应用场景

|

||||

1. 当前平台只支持一个光源,且需要使用Marching实现的视差Shader。

|

||||

2. 角色细节阴影与墙面植物(爬山虎)阴影。

|

||||

|

||||

## 级联阴影

|

||||

级联阴影分为近阴影与远阴影。两者皆可以设置数量、过度距离以及过度参数(在光源中设置)。

|

||||

|

||||

当然想要真正显示远阴影则需要勾选物体中的Far Shadow选项。

|

||||

## 其他技巧

|

||||

### 天光(SkyLight)

|

||||

天光也有距离场AO的选项,在调试时需要关闭别的光源进行调试。

|

||||

|

||||

### HDRI Backdrop

|

||||

https://docs.unrealengine.com/en-US/Engine/Rendering/LightingAndShadows/HDRIBackdrop/index.html

|

||||

|

||||

4.23处的新功能,对于CAD产品展示有很大帮助。

|

||||

# Wiki笔记

|

||||

部分条目的解释有配图,我懒得贴了,所以推荐直接看原文。

|

||||

## 问题解答

|

||||

### 静态部分

|

||||

#### 为什么我的阴影死黑?

|

||||

在光照条件下,深黑色阴影通常意味着没有填充光。这种情况经常发生在室外环境中,一个方向的光代表太阳。UE4有一个内置的方法来提供一个影响填充光的世界,我们把它称为天光。

|

||||

|

||||

#### 不想生成光照贴图

|

||||

1. Rendering——Lighting——AllowStaticLighting确保引擎不会生成光照贴图。(项目级)

|

||||

2. 打开世界设置——Lightmass——Force No Precomputed Lighting。(关卡级)

|

||||

|

||||

#### 双面渲染物体的阴影问题

|

||||

1. 在StaticMesh——Lighting——LightMassSetting中勾选UseTwoSidedLighting。(仅对静态光照)

|

||||

2. 在物体的材质选项中勾选TwoSided

|

||||

|

||||

#### 灯光上出现X标记

|

||||

因为有超过4个光源重叠在一起,这样会严重影响性能。动态光在该重叠区域会强制设为一个动态光源,而静态光源会在烘焙光照时弹出重叠提示。

|

||||

### 动态部分

|

||||

#### 阴影不正确

|

||||

##### 方向光

|

||||

###### Dynamic Shadow Distance Movable

|

||||

以摄像机为起点的阴影覆盖距离,该值为0则代表禁用该功能。

|

||||

|

||||

###### Dynamic Shadow Distance Stationary

|

||||

以摄像机为起点的阴影覆盖距离,该值为0则代表禁用该功能。

|

||||

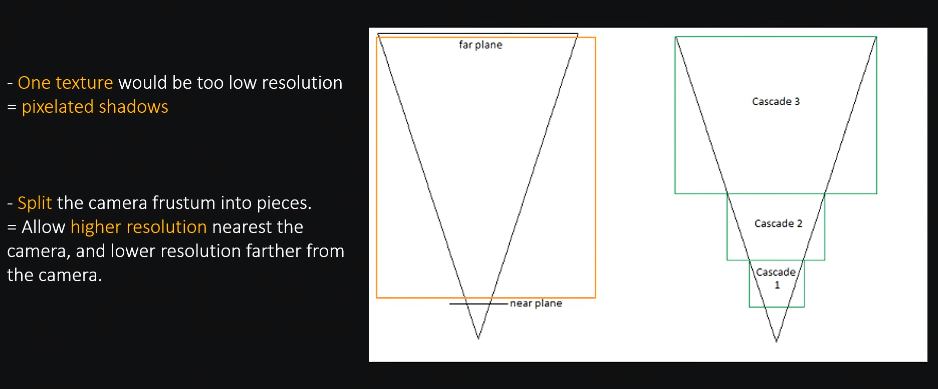

###### Num Dynamic Shadow Cascades

|

||||

view frustum被分割成的级联的数量。更多的级联将导致更好的阴影分辨率,但会显著增加渲染成本。

|

||||

###### Cascade Distribution Exponent

|

||||

控制级联的分布,是离相机更近(高值)还是更远(低值)。值1表示转换将与分辨率成正比。

|

||||

###### Cascade Transition Exponent

|

||||

级联之间的过度参数,较低的数值产生会较生硬的过度,而较高的数值会产生较平缓的过度。

|

||||

###### Shadow Distance Fadeout Fraction

|

||||

阴影淡出参数。较高的值会使阴影显得较淡一些,而较低的值会使阴影显得较深一些。

|

||||

###### Far Shadow

|

||||

级联阴影的远阴影开关,可以解决当摄像机处于较远距离时,物体的阴影会消失的问题。

|

||||

|

||||

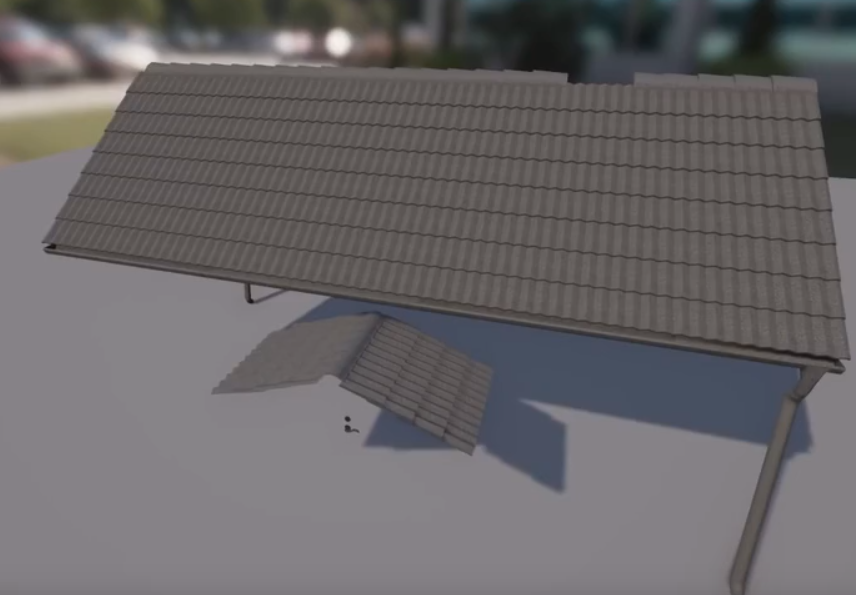

#### 调整级联阴影以得到更好的效果

|

||||

通过调整上述设置,可以很好地调整阴影的出血值和精度。下一节将尝试调整到最佳成都,以获得更好的精度与阴影。找到一种适合任何特定游戏的平衡将需要耗费时间、精力来进行大量测试。

|

||||

|

||||

以下是默认设置下会出现的问题。

|

||||

|

||||

|

||||

调整后的结果

|

||||

|

||||

##### 对于所有的动态光源

|

||||

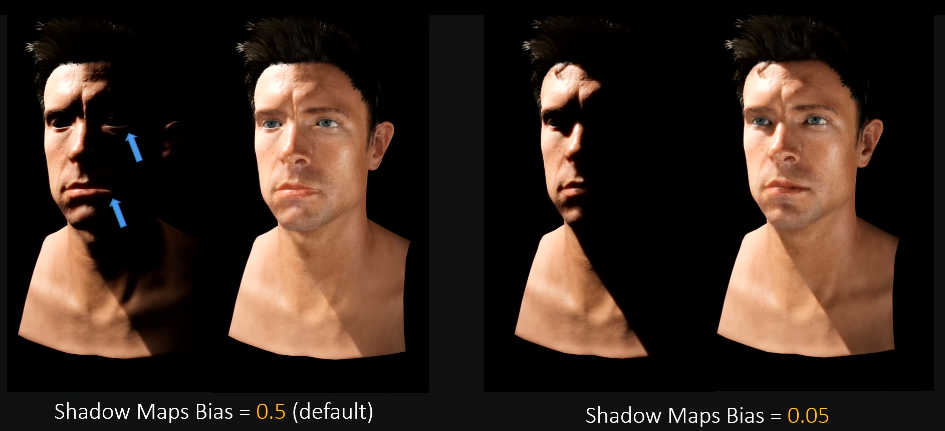

###### Shadow Bias

|

||||

控制阴影在场景中的精确程度。默认值是0.5,这是权衡了精度与性能的值。

|

||||

###### Shadow Filter Sharpness

|

||||

控制阴影边缘的锐化程度。

|

||||

|

||||

##### 为什么可移动光源在较远时其遮挡关系会出错

|

||||

|

||||

|

||||

|

||||

为了解释这一点,我们首先需要了解Ue4的渲染优化方法。引擎根据场景深度来判断场景中Mesh的可见性(首先物体需要处于摄像机矩阵中),如果Mesh过于远离摄像机,Mesh将不会被渲染或是被遮挡。所以就会出现图中的现象。

|

||||

|

||||

你可能会注意到,当选择物体时,灯光恢复正常。这是预料之中的,因为它处于焦点状态。

|

||||

|

||||

解决方法是:在Mesh属性界面,调整Bounds Scale选项的大小。默认值设置为1.0。建议的调整范围为1.1、1.2左右,调整的量不宜过大,会影响性能与阴影质量。

|

||||

|

||||

可以viewport > Show > Advanced > Bounds 开启包围盒显示进行debug。

|

||||

|

||||

另一个解决思路就是使用聚光灯或者使用静态光烘焙光照贴图。

|

||||

### 静态部分

|

||||

你可以在世界设置中的LightMass调整以下参数以获得更好的效果:

|

||||

Indirect Lighting Quality设置成2或者更高。

|

||||

Indirect Lighting Smoothness通常被设置为0.65~0.7之间。数值越低噪点会越多。

|

||||

#### 如何控制静态照明的全局照明效果?以及光线反弹的美妙之处

|

||||

默认情况下,LightMass的光线反弹次数为3,我们可以在Settings > World Settings > LightMass

|

||||

中修改反弹次数以获得更好的效果。

|

||||

|

||||

光线的第一次反弹所需的计算时间是最长的。之后的反弹对实际构建时间的影响较小,但对视觉效果的影响也要小得多。

|

||||

#### 解决阴影“脏”的问题

|

||||

首先,这种现象的原因与GI中的间接光照有关。

|

||||

|

||||

以下使用默认场景来创建2个测试用的关卡,其中Mesh的光照贴图分辨率设为256,后期空间开启人眼自适应。

|

||||

|

||||

<center>直接光照与一次反弹的间接光照</center>

|

||||

|

||||

|

||||

<center>只有一次反弹的间接光照</center>

|

||||

一个较为暴力的手法就是提高光照贴图分辨率,但这不是最好的方法。因为这样做会增大内存消耗。

|

||||

|

||||

|

||||

<center>光照贴图分辨率为1024的结果</center>

|

||||

|

||||

在WorldSettings——LightMass中,可以对以下参数进行设置:

|

||||

##### Indirect Lighting Quality

|

||||

控制间接光照的质量,以获得更佳的效果。

|

||||

##### Indirect Lighting Smoothness

|

||||

控制光照贴图中细节的平滑度。

|

||||

##### Num Indirect Lighting Bounces

|

||||

间接光照光线的反弹次数。

|

||||

|

||||

在对这些参数进行调整后,即使是光照贴图分辨率为512,其效果也比1024的好了。

|

||||

|

||||

<center>光照贴图分辨率为512</center>

|

||||

|

||||

|

||||

<center>光照贴图分辨率为1024</center>

|

||||

7

03-UnrealEngine/Rendering/Lighting/VirualShadowMap.md

Normal file

7

03-UnrealEngine/Rendering/Lighting/VirualShadowMap.md

Normal file

@@ -0,0 +1,7 @@

|

||||

---

|

||||

title: VirualShadowMap

|

||||

date: 2023-03-18 09:27:10

|

||||

excerpt:

|

||||

tags:

|

||||

rating: ⭐

|

||||

---

|

||||

244

03-UnrealEngine/Rendering/Lighting/正确的打光流程.md

Normal file

244

03-UnrealEngine/Rendering/Lighting/正确的打光流程.md

Normal file

@@ -0,0 +1,244 @@

|

||||

本文为《Lighting with Unreal Engine Masterclass》视频的学习笔记,地址为:https://youtu.be/ihg4uirMcec。

|

||||

|

||||

其中有关LightMass的笔记

|

||||

http://www.tomlooman.com/lighting-with-unreal-engine-jerome/

|

||||

翻译版

|

||||

https://mp.weixin.qq.com/s/CUVJ57s_qsCNzdVHw5OhNQ

|

||||

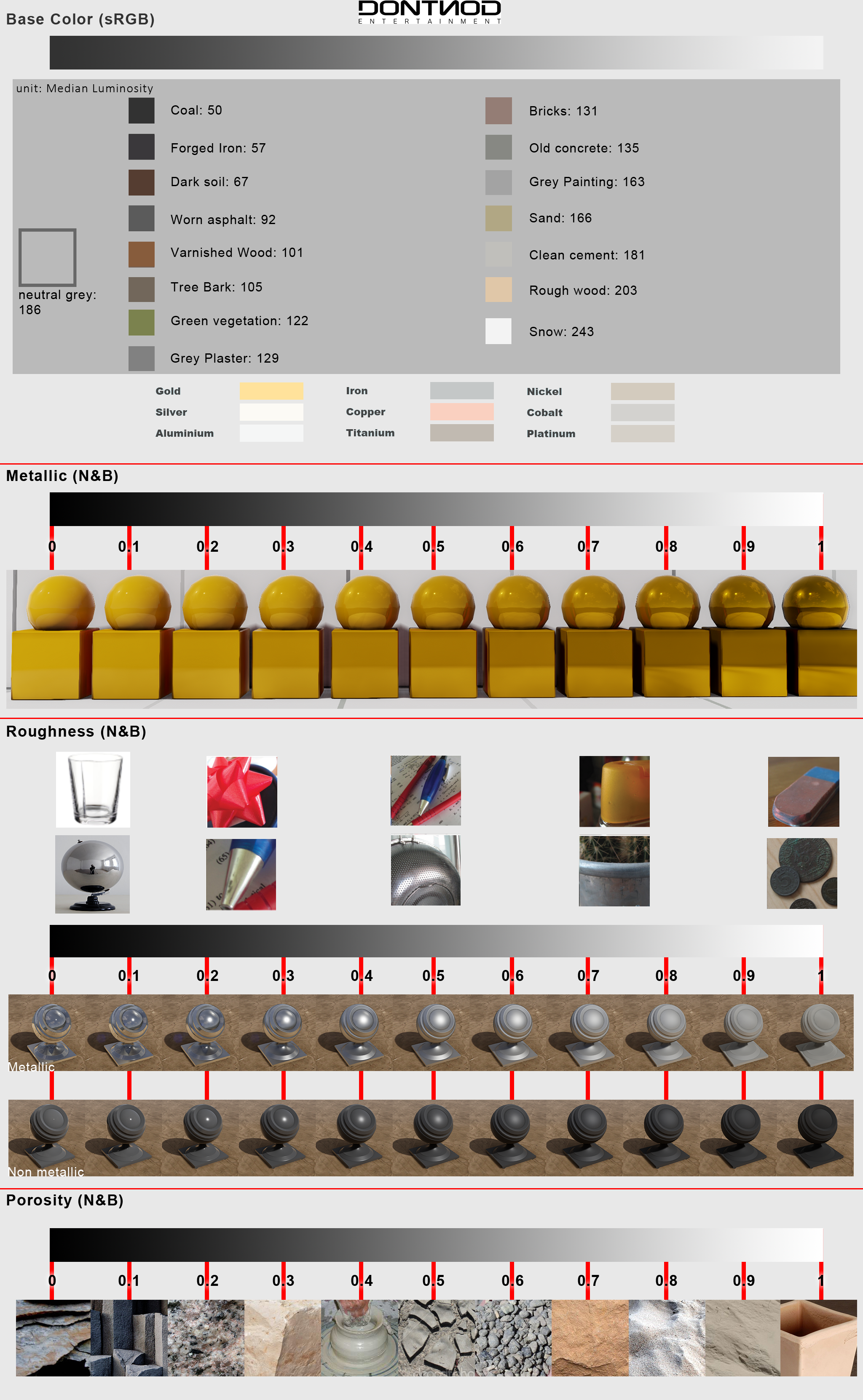

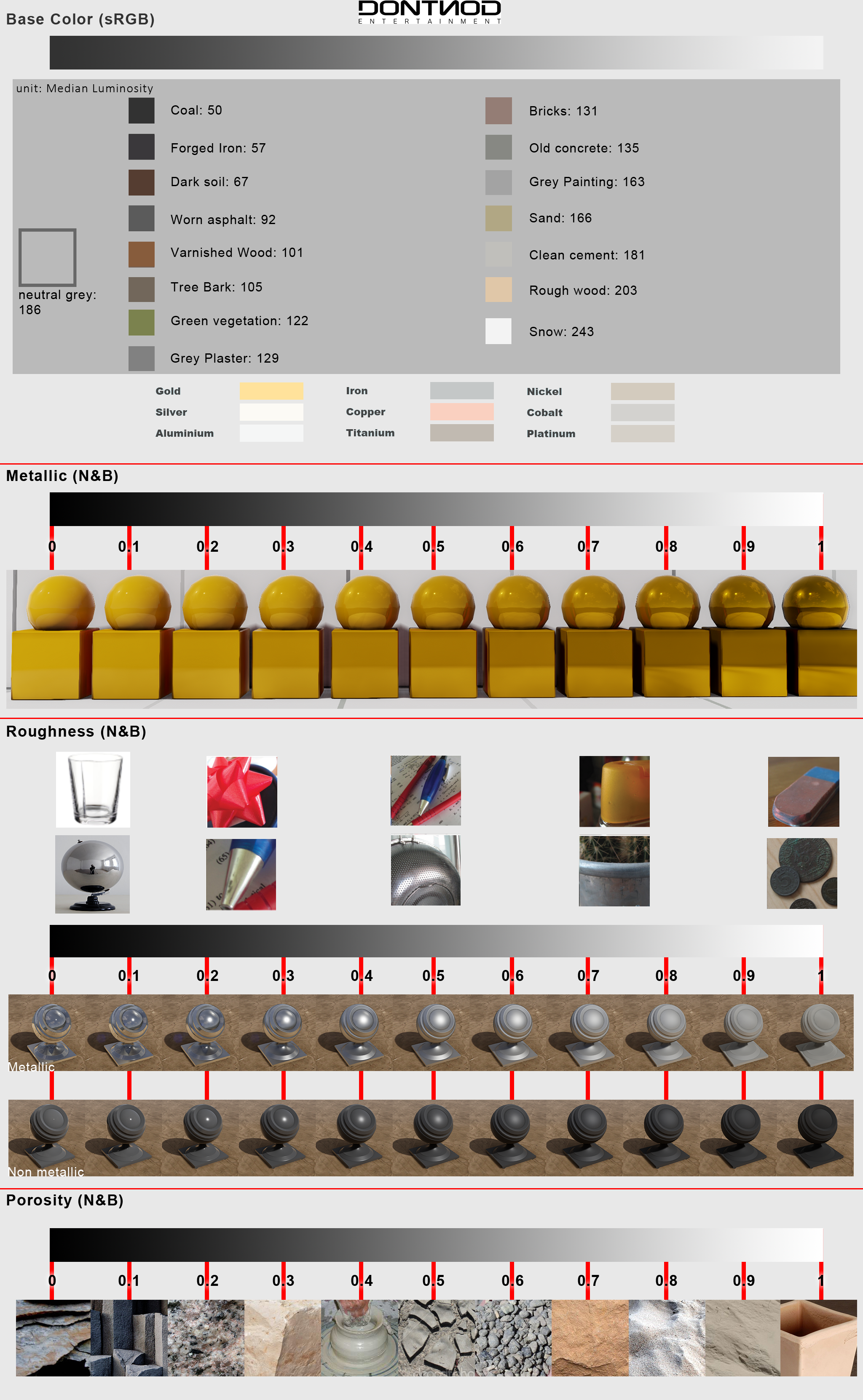

### 首先确定你的材质是物理正确的

|

||||

几个常见的错误:

|

||||

BaseColor:太暗或者太亮

|

||||

Metallic:应该为0或者1。(黑色或者白色Mask)

|

||||

Specular:应该为0~1范围的浮点数。不应该为颜色值。(它会导致反射亮度不一致)

|

||||

|

||||

常见材质的BaseColor数值都可以网上查询到,我记得《全局光照技术》中有说。世界中没有物体是纯白、纯黑的(即RGB为0或者1)。

|

||||

|

||||

PS.关于“Metallic应该为0或者1”,演讲者的意思是纯材质,排除混合材质情况。

|

||||

|

||||

~~因为迪士尼的渲染模型也是基于微表面的,如果在金属上的一个块微表面区域有40%的区域覆盖着 3D扫描用喷漆(表面完全哑光材质),那这块微表面的光照该如何计算呢?~~

|

||||

|

||||

~~而迪士尼的渲染模型里Metallic就有插值效果(0-1)。如果有问题,那为什么不在Shader里直接判断材质属于金属还是绝缘体。~~

|

||||

|

||||

### 如何实现一个良好的关照场景

|

||||

#### 关闭后处理空间中干扰项

|

||||

以下操作都在Post Process Volume中。用于去除对场景亮度的干扰。

|

||||

##### 禁用自动曝光

|

||||

视频中的操作是在后处理空间中将最低亮度与最高亮度设为1。

|

||||

|

||||

目前版本已经使用物理灯光,所以第一条,应该改为将Lens-Exposure

|

||||

中的Min Ev100与Max Ev100设为0。

|

||||

##### 禁用SSAO以及SSR(空间反射)

|

||||

将ScreenSpaceReflection中的Intensity设为0。将Ambient Occlusion的Intensity设为0。反射球可以不用删掉。

|

||||

##### 保持默认Tone Mapping

|

||||

确定Tonemapper(新版本为Film)中值为默认值。

|

||||

##### 关闭Vignetting与Bloom效果

|

||||

将Lens-Bloom中的Intensity设为0。将Lens-Image Effect中Vignette Intensity设为0。

|

||||

|

||||

#### 设置测试用球(与色卡

|

||||

视频使用了Chrome球(BaseColor 1、Metallic 1、 Roughness 0)与Gray球 50%灰(BaseColor 0.18(Linear)、Roughness 1、Metallic 0)进行测试。使用亮度为3.141593(Pi)的方向光,此时灰球的亮度为0.5。(使用Color Picker、或者截图使用Photoshop查看)

|

||||

|

||||

但其实引擎已经预制了颜色校准工具,只需要在View Options中勾选Show Engine Content,之后搜索ColorCalibrator,将SM_ColorCalibrator拖到场景中即可。

|

||||

|

||||

## 动态实时灯光VS静态烘焙灯光

|

||||

### 静态烘焙灯光优缺点

|

||||

优点:

|

||||

- 拥有GI效果

|

||||

- 消耗较少的软阴影效果

|

||||

- 低GPU性能消耗较小

|

||||

|

||||

缺点:

|

||||

- 迭代效率低

|

||||

- 光照效果是静止的

|

||||

- 当地图较大时,会占用大量显存。

|

||||

|

||||

### 动态实时灯光优缺点

|

||||

优点:

|

||||

- 所见即所得

|

||||

- 光照效果是动态的

|

||||

|

||||

缺点:

|

||||

- 没有GI效果

|

||||

- GPU性能消耗较大

|

||||

|

||||

### 静态烘焙灯光

|

||||

#### 场景流程

|

||||

1. 放入方向光(stationary)

|

||||

2. LightMass烘焙(GI)

|

||||

3. 放入天光(static)

|

||||

|

||||

PS.因为新版本的改动,天光已经可以进行多次反弹,并且可以发射光子了。所以我认为应该第四部,再次烘焙灯光。

|

||||

#### Min LightMap Resolution(静态模型Detials)

|

||||

控制UV块之间Padding值。良好的Padding值可以减少像素浪费以及、提高阴影效果(在固定LightMap分辨率下)。Min LightMap Resolution应该被设置为小于或者等于LightMap Resolution的值。(作者一般直接设为与LightMap Resolution相等的值)

|

||||

|

||||

#### Num Indirect Lighting Bounce(世界设置)

|

||||

许多用户喜欢把这个值提高到 100 次,不过好在这个对烘焙时长影响不大,但同时对光照质量影响也不大。实际使用这个值设置为 3 - 5 次就足够了。

|

||||

|

||||

下面是对比数据:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

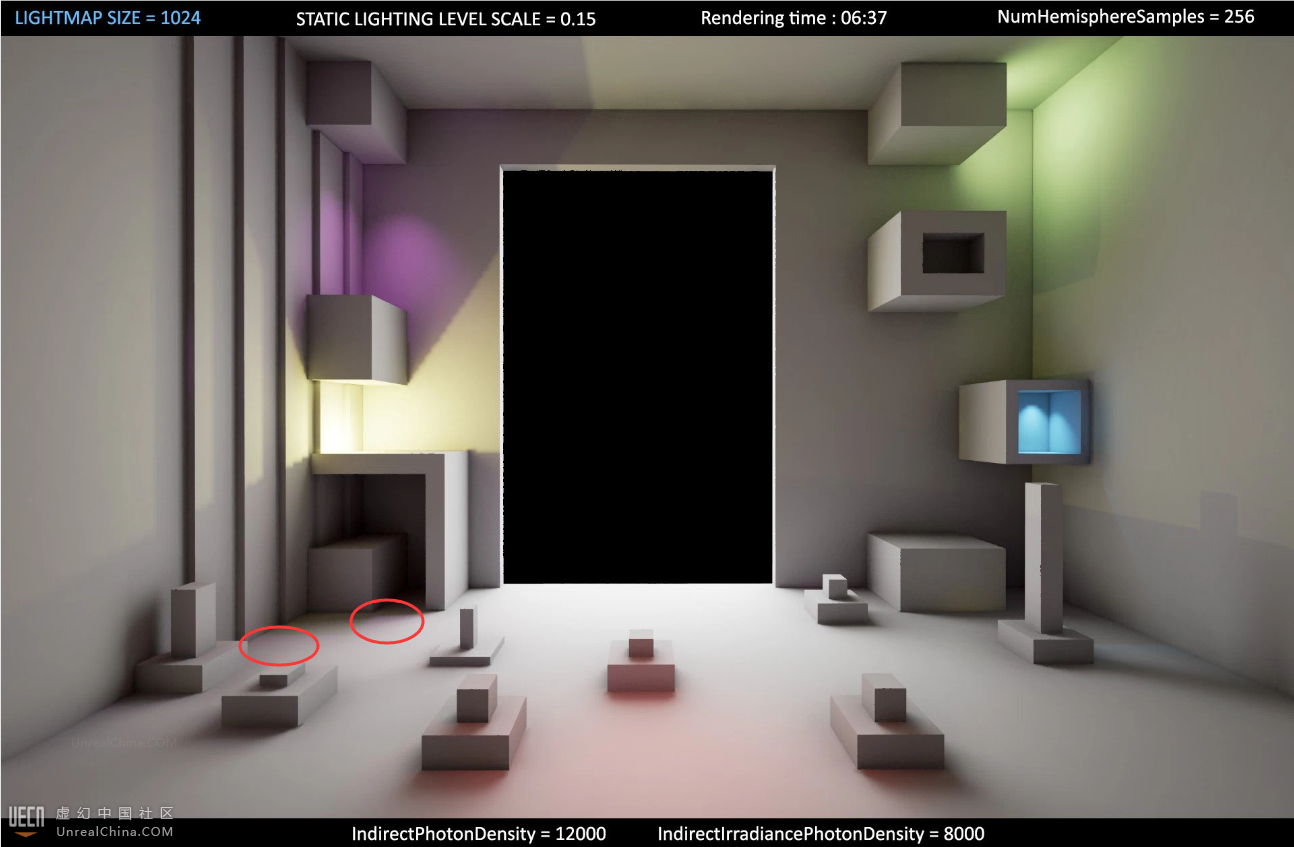

#### Static Lighting Level Scale(世界设置)

|

||||

改变lightmass的级别。默认值为 1,越小细节越多,最终我们使用 0.1。

|

||||

|

||||

其原理是增加单位的区域的采样点的量。但这样会产生大量噪点。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

#### Indirect Lighting Smoothness(世界设置)

|

||||

该值大于1是会对LightMap进行平滑处理(反之会进行锐化),过高的数值会导致漏光现象。对于这个属性作者建议设置为0.7~1。

|

||||

|

||||

#### Indirect Lighting Quality(世界设置)

|

||||

增加进行final gathering运算时的采样光线量。提高数值可以减少间接照明时的噪点,但代价是极大地增加构建时间。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

#### Lighting Build Quality(在构建下拉按钮中)

|

||||

调整LightMass烘焙质量的总开关。用于整体调整烘焙质量,对烘焙时长影响很大。

|

||||

- Preview(耗时 2 分 16 秒)预览级

|

||||

- Medium(耗时 7 分 48 秒)中级

|

||||

- High(耗时 13 分 58 秒)高级

|

||||

- Production(耗时 30 分 22 秒)产品级

|

||||

|

||||

作者的习惯:大部分的工作时间都使用预览级,有时会切换到中级进行效果预览。在周末可能会切换到高级或者产品级进行烘焙来查看效果。

|

||||

|

||||

#### Lighting Level Scale与Indirect Lighting Quality的设置技巧

|

||||

保持Static Lighting Level Scale × Indirect Lighting Quality = 1。你就可以得到一个噪点较少的场景。

|

||||

|

||||

#### Volume Light Sample Scale

|

||||

减少Static Lighting Level Scale会增加这些空间采样样本(密度)。

|

||||

|

||||

#### 添加LightMass Portal提高室内场景光照质量

|

||||

给室内场景中的窗户添加LightMass Portal,以此可以减少噪点。

|

||||

|

||||

其原理是模拟天光效果,向室内发射光子。但也因此会在增加发射光子阶段(渲染过程中)的时间。

|

||||

|

||||

## Lighting Scenarios

|

||||

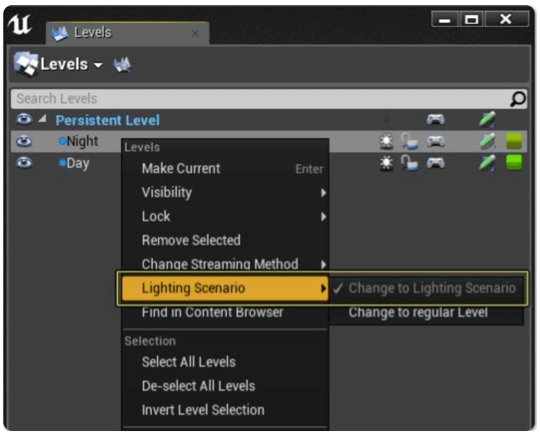

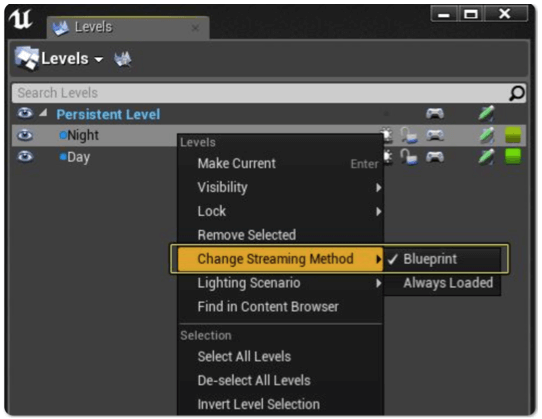

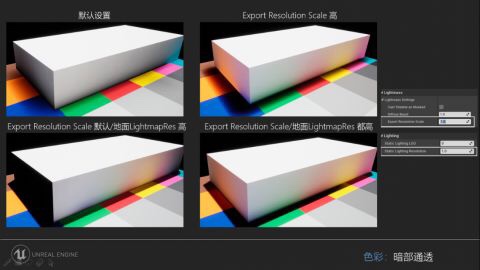

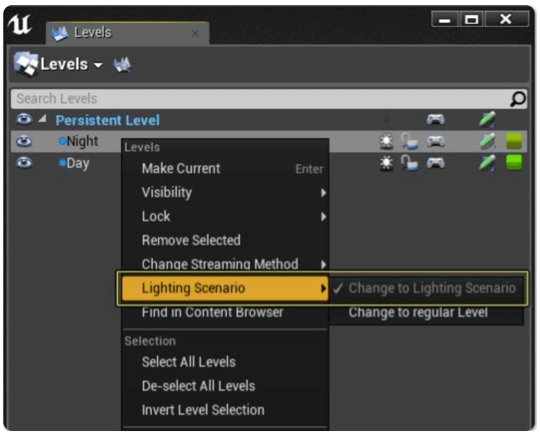

在游戏制作过程中,有时会存在同一场景使用多套Lightmap的情况,如:模拟天气系统,以及一天中不同时段的光照等。在Unreal 4引擎中,可以利用Lighting Scenarios功能达到此效果。使用Lighting Scenarios时,首先需要创建不同的光照Level,然后在Level设置页面将其设置为Lighting Scenario类型,如下图所示:

|

||||

|

||||

|

||||

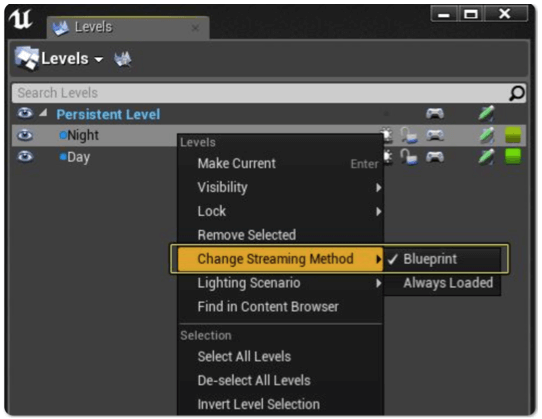

另外,设置Level的加载方式为使用Blueprint加载:

|

||||

|

||||

|

||||

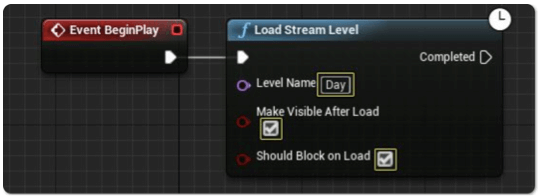

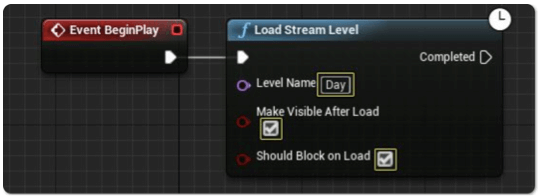

接着,对不同Level设置不同的光照进行烘焙。烘焙结束后,在Persistent Level Blueprint中,添加Load Stream Level节点对Level进行加载,并设置要加载的Level名称Day,如下图所示:

|

||||

|

||||

|

||||

### 动态实时灯光

|

||||

#### 场景流程

|

||||

1. 放入方向光(moveable)

|

||||

2. 放入天光(moveable)

|

||||

3. 开启DistanceFieldAO

|

||||

4. 开启SSAO

|

||||

|

||||

#### 距离场技术

|

||||

距离场因为存储了空间信息,可以解决屏幕空间渲染技术的缺陷。比如SSAO。距离阴影可以产生与级联阴影不同的软阴影效果。同时你可以在材质编辑器获取距离场数值以制作一些特殊效果。

|

||||

|

||||

需要注意的:

|

||||

- 只有静态物体可以使用距离场

|

||||

- 避免非规整缩放

|

||||

- 巨大物体的距离场分辨率会很低(这里建议把大物体进行拆分)

|

||||

- 距离场AO的更新会分布在多个帧中,所以你没有办法得到真正的实时AO。但这个通常不会引起玩家注意。

|

||||

- 你可以通过提高距离场分辨率来修复一些距离场技术渲染不正确的情况。

|

||||

- 距离场AO是可以着色的,你可以使用它来模拟一些光线反弹效果。

|

||||

|

||||

#### Shadow Map

|

||||

##### Shadow Bias

|

||||

控制阴影在场景中的精确程度。默认值是0.5,这是权衡了精度与性能的值。

|

||||

|

||||

但是在渲染角色时,需要适当权衡这个值,以求在效果正确的基础上对性能消耗最小。

|

||||

##### 级联阴影

|

||||

当在一个较大表面上投射阴影时,一个贴图的分辨率可能是不够的,而且会有大量的像素损失。于是就出现使用多个贴图拼在一起显示阴影的技术。

|

||||

|

||||

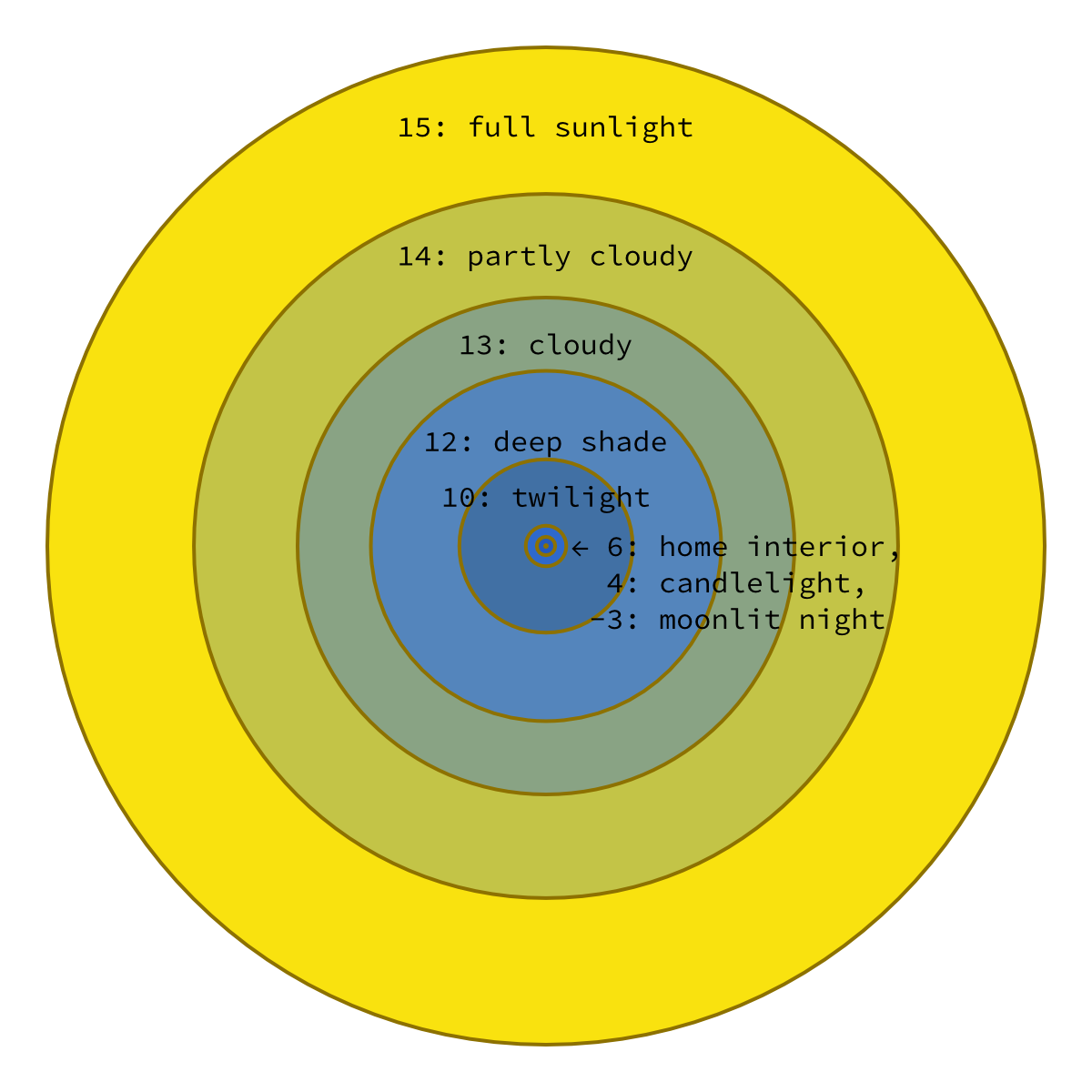

Lighting condition EV100

|

||||

Daylight

|

||||

Light sand or snow in full or slightly hazy sunlight (distinct shadows)a 16

|

||||

Typical scene in full or slightly hazy sunlight (distinct shadows)a, b 15

|

||||

Typical scene in hazy sunlight (soft shadows) 14

|

||||

Typical scene, cloudy bright (no shadows) 13

|

||||

Typical scene, heavy overcast 12

|

||||

Areas in open shade, clear sunlight 12

|

||||

Outdoor, natural light

|

||||

Rainbows

|

||||

Clear sky background 15

|

||||

Cloudy sky background 14

|

||||

Sunsets and skylines

|

||||

Just before sunset 12–14

|

||||

At sunset 12

|

||||

Just after sunset 9–11

|

||||

The Moon,c altitude > 40°

|

||||

Full 15

|

||||

Gibbous 14

|

||||

Quarter 13

|

||||

Crescent 12

|

||||

Blood 0 to 3[6]

|

||||

Moonlight, Moon altitude > 40°

|

||||

Full −3 to −2

|

||||

Gibbous −4

|

||||

Quarter −6

|

||||

Aurora borealis and australis

|

||||

Bright −4 to −3

|

||||

Medium −6 to −5

|

||||

Milky Way galactic center −11 to −9

|

||||

Outdoor, artificial light

|

||||

Neon and other bright signs 9–10

|

||||

Night sports 9

|

||||

Fires and burning buildings 9

|

||||

Bright street scenes 8

|

||||

Night street scenes and window displays 7–8

|

||||

Night vehicle traffic 5

|

||||

Fairs and amusement parks 7

|

||||

Christmas tree lights 4–5

|

||||

Floodlit buildings, monuments, and fountains 3–5

|

||||

Distant views of lighted buildings 2

|

||||

Indoor, artificial light

|

||||

Galleries 8–11

|

||||

Sports events, stage shows, and the like 8–9

|

||||

Circuses, floodlit 8

|

||||

Ice shows, floodlit 9

|

||||

Offices and work areas 7–8

|

||||

Home interiors 5–7

|

||||

Christmas tree lights 4–5

|

||||

|

||||

https://youtu.be/t_tT7pwO_j8

|

||||

对于曝光的建议是:在调整最大最小值后与偏移后(最暗与最亮处的效果匹配),把切换速度调成最高。

|

||||

|

||||

该视频的流程:

|

||||

CubeMap=》Skylight=>LightMaps=>Lightmass Protals=》LightMass Setting=》LightMass Important Volume=》Post Process=》Turn off AO=》Reflection probes

|

||||

|

||||

#### 帕拉共

|

||||

帕拉共因为考虑多平台(部分平台可能不支持自适应),所以曝光的范围比较小(旧版本0.35~0.45)

|

||||

|

||||

#### 曝光与灯光强度

|

||||

根据Daedalus51的测试及一些数据,方向光强度可以达到125000Lux然后天光5000cd/m²配合16EV值那个只是为了测试场景的数值。

|

||||

|

||||

Daedalus51的灯光学院系列视频:

|

||||

https://www.youtube.com/user/51Daedalus/videos

|

||||

|

||||

当然这些视频也已经搬运到国内了:

|

||||

https://www.bilibili.com/av59548243/

|

||||

|

||||

物理灯光文档

|

||||

https://docs.unrealengine.com/zh-CN/Engine/Rendering/LightingAndShadows/PhysicalLightUnits/index.html

|

||||

|

||||

### 天光问题

|

||||

有人提出了一个问题,大多数HDR文件,你是不知道他用了什么曝光标准,以及拍摄时的光照强度

|

||||

|

||||

天光转换,ev100 0=》16 1=》2^16

|

||||

|

||||

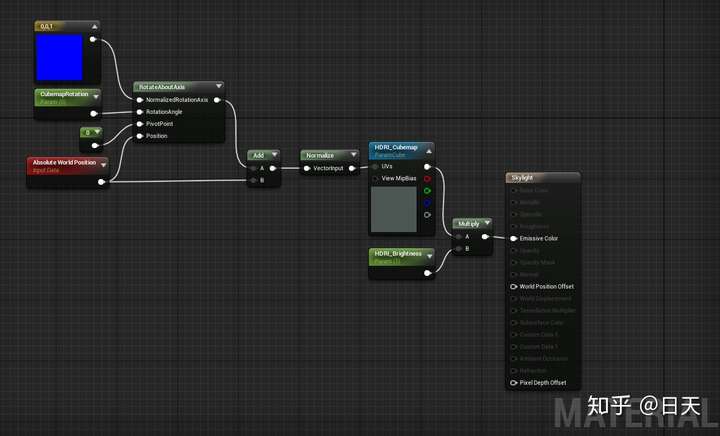

#### 使用天空来实现天光效果

|

||||

添加一个自发光材质给球(可以使用EditorSkySphere),缩放到Sky Distance Threshold大小后,LightMass就会把这个球当做是天空球,用以烘焙天光。

|

||||

https://zhuanlan.zhihu.com/p/70288801

|

||||

|

||||

SkySphere的问题 解决方案在材质里乘以 39808

|

||||

|

||||

室内保证打光均匀。

|

||||

|

||||

选择合理的曝光数值

|

||||

#### 黑夜曝光方案

|

||||

min brightness of 0.1 and a max brightness of 1,适当增加天光的亮度。

|

||||

@@ -0,0 +1,132 @@

|

||||

## 前言

|

||||

本文是对于《Daedalus51的灯光学院系列视频》、《Lighting with Unreal Engine Masterclass视频》、《Ue4照明技术引导系列视频》的总结。相关网址与链接可以参看前一篇文章。

|

||||

|

||||

撰写本文时,《Daedalus51的灯光学院系列视频》只看完第一章,所以本文后续还会更改,请各位读者注意。另外因为本人技术能力有限,如有错误还请各位指正。

|

||||

### 三个视频的观看建议

|

||||

>Lighting with Unreal Engine Masterclass

|

||||

|

||||

从简到深地讲解了静态光照与动态光照特性对比、2种光照方案的技术点以及Epic的基本打光流程。缺点是没有很好的讲解具体的打光思路以及流程。

|

||||

|

||||

>Ue4照明技术引导系列视频

|

||||

|

||||

该系列一共2个视频,主要介绍了光照技术中的各种细节与参数。是功能与参数讲解向视频。PS.个人感觉配套的Wiki比视频有用多了,Wiki中讲解若干阴影问题的解决方法。本视频已经被搬运到B站,中(机翻)英双字幕。https://www.bilibili.com/video/av59548243/

|

||||

|

||||

>Daedalus51的灯光学院系列视频

|

||||

|

||||

一共19个视频,看完需要1~2个星期。一共4个章节,每个章节都是一个案例。通过这个视频你可以大致了解到Ue4的打光流程、每步操作的意义以及部分功能背后技术的原理。让你了解如何判断场景出了哪些问题,出现什么问题该如何解决,什么时候该做什么。

|

||||

|

||||

建议的观看顺序为:《Lighting with Unreal Engine Masterclass》=》

|

||||

《Ue4照明技术引导系列视频》=》《Daedalus51的灯光学院系列视频》

|

||||

|

||||

## 灯光类型对比

|

||||

以下几点都是直接翻译视频中的观点,这里我总结一下:

|

||||

|

||||

>动态光照的主要优点是所有效果都是实时的,对于效果的迭代会非常快。主要缺点是没有GI。

|

||||

|

||||

>静态光照的主要优点有GI,但因为效果不是实时的,迭代的效率相当会相对较低。

|

||||

|

||||

静态光照一般会使用Stationary类型的灯光,其中的Dynamic Shadow Distance参数是切换动态与静态阴影开关,当为0是所有阴影都将是烘焙的,当数值较大时(5000)所有近距离阴影都将是动态的。Daedalus51推荐的数值为3000~8000之间。(在这个数值的距离观察时会切换为静态阴影)

|

||||

### 静态烘焙灯光优缺点

|

||||

优点:

|

||||

- 拥有GI效果

|

||||

- 消耗较少的软阴影效果

|

||||

- 低GPU性能消耗较小

|

||||

|

||||

缺点:

|

||||

- 迭代效率低

|

||||

- 光照效果是静止的

|

||||

- 当地图较大时,会占用大量显存。

|

||||

|

||||

### 动态实时灯光优缺点

|

||||

优点:

|

||||

- 所见即所得

|

||||

- 光照效果是动态的

|

||||

|

||||

缺点:

|

||||

- 没有GI效果

|

||||

- GPU性能消耗较大

|

||||

|

||||

### Static

|

||||

烘焙直接光照与间接光照(GI)

|

||||

GPU性能消耗最少

|

||||

### Stationary

|

||||

烘焙间接光照

|

||||

高质量的直接关照与阴影(动态)

|

||||

高质量与中等性能消耗

|

||||

四个及以上的灯光重叠限制(多出的灯会使用static方式计算)

|

||||

### Movable

|

||||

动态光照与阴影

|

||||

GPU性能消耗最多

|

||||

没有间接光照

|

||||

|

||||

## 前置流程

|

||||

以下两点主要参考于Lighting with Unreal Engine Masterclass视频,部分来自于Daedalus51的视频。

|

||||

### 实现没有干扰的默认光照场景

|

||||

使用初始模板建立的场景。

|

||||

#### 关闭后处理空间中干扰项

|

||||

以下操作都在Post Process Volume中。用于去除对场景亮度的干扰。

|

||||

##### 禁用自动曝光

|

||||

视频中的操作是在后处理空间中将最低亮度与最高亮度设为1。

|

||||

|

||||

目前版本已经使用物理灯光,所以第一条,应该改为将Lens-Exposure

|

||||

中的Min Ev100与Max Ev100设为0。

|

||||

##### 禁用SSAO以及SSR(空间反射)

|

||||

将ScreenSpaceReflection中的Intensity设为0。将Ambient Occlusion的Intensity设为0。反射球可以不用删掉()。

|

||||

##### 保持默认Tone Mapping

|

||||

确定Tonemapper(新版本为Film)中值为默认值。

|

||||

##### 关闭Vignetting与Bloom效果

|

||||

将Lens-Bloom中的Intensity设为0。将Lens-Image Effect中Vignette Intensity设为0。

|

||||

##### 杂项

|

||||

后处理的GI选项只对LightMass烘焙过的GI有效。、

|

||||

不建议使用后处理的AO中的Cubemap Texture(已经被天光代替)

|

||||

#### 确认天光与方向光为默认数值

|

||||

天光:亮度为1

|

||||

方向光:亮度为3.141593(π)

|

||||

#### 设置测试用球(与色卡)

|

||||

视频使用了Chrome球(BaseColor 1、Metallic 1、 Roughness 0)与Gray球 50%灰(BaseColor 0.18(Linear)、Roughness 1、Metallic 0)进行测试。使用亮度为3.141593(Pi)的方向光,此时灰球的亮度为0.5。(使用Color Picker、或者截图使用Photoshop查看)

|

||||

|

||||

但其实引擎已经预制了颜色校准工具,只需要在View Options中勾选Show Engine Content,之后搜索ColorCalibrator,将SM_ColorCalibrator拖到场景中即可。

|

||||

### 确定你的材质是物理正确的

|

||||

在将模型导入并赋予材质后检查场景:

|

||||

《Lighting with Unreal Engine Masterclass》说

|

||||

几个常见的错误:

|

||||

BaseColor:太暗或者太亮

|

||||

Metallic:应该为0或者1。(黑色或者白色Mask)

|

||||

Specular:应该为0~1范围的浮点数。不应该为颜色值。(它会导致反射亮度不一致)

|

||||

|

||||

常见材质的BaseColor数值都可以网上查询到,我记得《全局光照技术》中有说。世界中没有物体是纯白、纯黑的(即RGB为0或者1)。

|

||||

|

||||

PS.关于“Metallic应该为0或者1”,演讲者的意思是纯材质,排除混合材质情况。

|

||||

|

||||

|

||||

#### 关于BaseColor

|

||||

Daedalus51提出场景中的BaseColor应该要较为平缓(亮度、对比度与饱和度别太高),这一点也在在Ue4的LightMass文档中的“使用LightMass获取最佳质量”章节中有提到。

|

||||

|

||||

特别是饱和度,饱和度如果过高会让人感觉画面奇怪。1.5章节开头就在调整贴图的饱和度与亮度。

|

||||

|

||||

检查的方法是切换到BaseColor查看模式截图,再使用Photoshop的Histogram查看颜色分布。Daedalus51使用的方法是,使用PS对截图使用平均模糊滤镜,之后观察图片的各个值。

|

||||

|

||||

但从视频中可以看出,这个步骤更多的是靠经验,所以这里还是建议各位仔细看下对应视频。

|

||||

##### 在Ue4中修改贴图

|

||||

一种简单修复方法就是打开TextureAsset,直接修改里面的饱和度、亮度、对比度等选项。(但是作者还是建议使用Photoshop修改源文件再更新Asset)

|

||||

|

||||

## 结语

|

||||

在下一篇文章中,我会总结各个步骤的重要细节,以及各个功能所应用的场景。但是文章只能记录操作步骤与流程,不能记录使用经验,所以本人依然推荐想深入学习光照的人去看一下Daedalus51的视频。

|

||||

|

||||

#### Daedalus51视频中的场景

|

||||

第一章节:

|

||||

|

||||

户外傍晚:

|

||||

使用纯动态光照

|

||||

距离场AO(SSAO好像关闭了)

|

||||

CubeMap天光并且自定义下半球颜色

|

||||

|

||||

其他为后处理

|

||||

|

||||

户外早晨:

|

||||

使用静态光照(Stationary的动态阴影不算的话)

|

||||

CubeMap天光并且自定义下半球颜色

|

||||

|

||||

第二章节:

|

||||

|

||||

洞穴场景(可以看成是室内)。

|

||||

@@ -0,0 +1,341 @@

|

||||

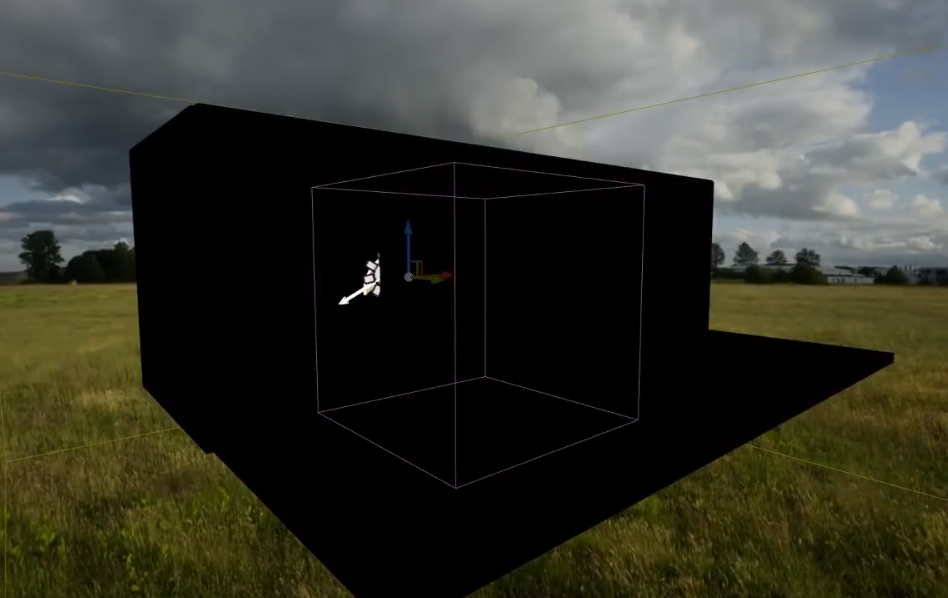

## 前言

|

||||

在这一章,我将会总结一些有关静态光照相关的参数、使用场景与设置技巧。

|

||||

|

||||

本文图较多,手机党请注意。本文仅作为个人笔记使用,不保证所有操作都是正确的,请各位谨慎阅读。

|

||||

### Daedalus51的流程

|

||||

首先我总结一下Daedalus51的流程,如有遗漏还请指正。以下流程仅为笔记记录使用,不一定正确。

|

||||

|

||||

个人不太推荐看第二章节后半段文档视频,因为作者一直都在调节材质(场景、粒子)。如果是建筑可视化方向的可以直接看第三章。

|

||||

#### 1.5章节的流程

|

||||

1. 去除干扰场景光照的后处理效果(本系列第一篇文章)

|

||||

2. 检查贴图的固有色是否正确并进行调整。(本系列第一篇文章)

|

||||

3. 调整天光以符合设计目标。(本系列第一篇文章)

|

||||

4. 设置曝光相关属性。

|

||||

5. 将所有灯光都是设置为Stationary类型。并开始设置方向光与其他主光源的基础属性(方向、亮度等)

|

||||

6. 设置LightMass属性,使用预览级对场景进行测试渲染。

|

||||

7. 开启LightingOnly模式对光照进行检查。

|

||||

8. 给场景中的带有反射属性的物体添加反射球并调整属性。(Daedalus51的流程中没有关闭空间反射,如果你按照我之前写的关闭空间反射,这里要记得开启)之后开启Reflections模式查看场景反射情况。

|

||||

9. 设置场景植被(有光照无关)

|

||||

10. 调整场景雾气

|

||||

11. 后处理调色

|

||||

|

||||

**测试烘焙**<br>

|

||||

注意去掉世界设置中的Force Precompute Lighting选项。

|

||||

关闭Compress LightMaps选项(压缩灯光贴图),为了追求效果;但如果游戏项目推荐打开,这样可以节约显存占用。

|

||||

|

||||

作者一般不会再一开始就开启LightMass的AO烘焙选项(世界设置中)。因为一般情况下都会(也应该)使用SkyLight,所以我们应该把LightMass的EnvironmentColor设置为0。

|

||||

|

||||

**突破材质贴图数目限制**<br>

|

||||

因为全都使用静态烘焙灯光,所以在对应材质中Usage选项卡中勾选Use With Static Lighting,这样材质中的贴图采样数数统计才会正确(因为使用LightMass会占用2张贴图)

|

||||

|

||||

材质编辑器的Texture Sampler节点的Sampler Source选项决定了一个材质所能使用贴图数量,使用Shared:Wrap选项可以突破Dx11的贴图数量限制。

|

||||

|

||||

**Stationary类型灯光阴影说明**<br>

|

||||

Station类型的灯光对于静态物体会烘焙灯光,对于动态物体会使用动态阴影。

|

||||

Dynamic Shadow Distance StationaryLight是切换开关,当为0是所有阴影都将是烘焙的,当数值较大时(5000)所有近距离阴影都将是动态的。作者推荐3000~8000之间。(在这个数值的距离观察时会切换为静态阴影)

|

||||

**有关反射球**

|

||||

反射球会影响所有物体产生影响(高反射物体如果没有反射球,渲染结果往往是错误的),你可以选择给小物体使用小反射球,之后在给所有物体一个大反射球。(小反射球的优先级高)

|

||||

|

||||

**提高空间灯光样本密度(本人加的私货)**

|

||||

树木、草地等植被因为模型比较密集,所以无法获取准确的LightVolume样本信息。可以使用Volumetric LightMap Density Volume来增加空间样本数量。

|

||||

|

||||

其他相关空间还有:<br>

|

||||

**Lightmass Importance Volume**

|

||||

用于提高指定区域内的LightMap烘焙效果(主要是间接照明),区域外的默认为低质量效果。

|

||||

|

||||

**LightMass Character Indirect Detail Volume**

|

||||

提高区域内的间接光照缓存的密度(缓存点会更加密集)。

|

||||

|

||||

#### 2.1章节的流程

|

||||

1. 删除无用灯光(因为Daedalus51在帮人改场景)并将其他灯光关闭。

|

||||

2. 这个关卡原本没有使用LightMass,可以看得出缺少AO

|

||||

可以使用距离场AO等技术补充在发现后处理空间开启了Dynamic Indirect Lighting后,查看LPV其实并没有开启。

|

||||

3. 检查场景模型UV,之后使用基础参数进行测试渲染。

|

||||

4. 在调整后屏幕空间反射质量后,使用LightingOnly查看光照烘焙效果。(洞穴墙壁太亮度,发现是因为模型没有设置为静态导致没有参与烘焙)

|

||||

5. 设置反射球,以消除错误的反射。

|

||||

6. 关闭指数雾与其他粒子雾(会影响场景亮度)并且将场景中的射灯模型的自发光材质属性降低,重置所有后处理,至此完成了场景基础修改。(这个理论上应该放到第一步中)

|

||||

7. 使用BaseColor模式查看固有色,并调整贴图的饱和度与亮度。

|

||||

8. 放置LightMass Portal,提高指定区域在LightMass烘焙中所产生的的光线量,以此来提高洞穴内的效果。

|

||||

9. 因为场景方向光没有对准洞口,所以作者选择关闭方向光,提高天光的间接照明亮度,并且在WorldSettings中将间接照明反弹提高到100。(目前版本应该设置天光反弹次数,而作者的版本没有这个选项,所以在视频中场景还是很黑)

|

||||

10. 调节曝光与人眼适应。

|

||||

11. 调整各种材质效果,与贴花效果。(设置贴花的光照模型)

|

||||

12. 逐个开启之前关闭的光源,并调整光源的颜色与范围。(调整灯光颜色以及优化Stationary重叠问题)并且把一些作用范围较小的灯光设置为动态,不产生阴影以对效果进行快速迭代。

|

||||

13. 继续调节场景中的细节(粒子、材质、灯光)

|

||||

14. 增加指数雾与使用反转法线球体制作的体积雾。

|

||||

15. 调节后处理效果。

|

||||

|

||||

**有关LPV**<br>

|

||||

Daedalus51并不推荐在室内设计中使用LPV(外部主光源不能对室内产生足够多的间接照明。因为LPV只适用于方向光,所以我们应该关闭Dynamic Indirect Lighting选项)。

|

||||

|

||||

**有关屏幕反射**

|

||||

因为默认状态下,r.sss.quality为3,所以在后处理空间中调整质量到60以上都和60是一样的。(r.sss.quality 2命令对应的最高质量为50)输入r.sss.quality 4 可以解锁100质量。

|

||||

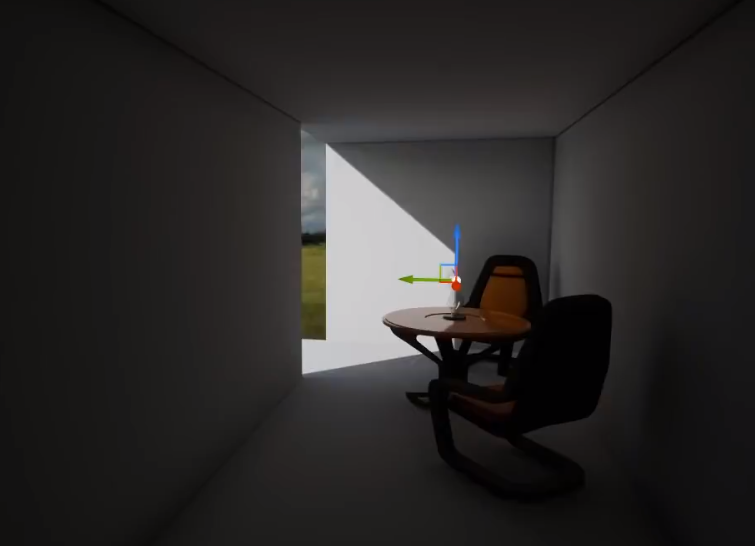

#### 3.1章节的流程

|

||||

需要解决两个问题:

|

||||

- 场景中的窗子太小,同时室内灯光没有开启,导致室内光照不足。(可以看得出参考图的曝光度很高,连天空都看不出细节)

|

||||

- 场景中植物与材质不符合场景。

|

||||

|

||||

大致流程如下:

|

||||

1. 首先进入LightMap Density模式查看光照贴图密度情况,并调整分辨率到合适值。(保证附近模型的光照贴图密度大致相同)

|

||||

2. 检查后处理空间、天光与方向光,并重置至默认数值。(建筑可视化应该关闭屏幕空间AO,因为LightMass会烘焙效果更好的阴影)

|

||||

3. 将曝光度设置为1,让户外与室内曝光统一。(这么调整之后室内会变得很黑,此时Daedalus51认为我们不应该直接调整天光与方向光的强度与间接照明倍率,而是应该调整曝光数值来解决这个问题。)

|

||||

4. 关闭除了天光外的方向光与其他光源,并检查LightMass Portl、Lightmass Importance Volume是否设置正确。

|

||||

5. 修改LightMass选项后进行预览级质量烘焙。(提高反弹次数6=》10,设置打包灯光与阴影贴图最大大小,关闭压缩LightMap功能)

|

||||

6. 对比参考图后发现是曝光的问题,之后修改exposure bias(0=>4.6),使得场景达到合适的亮度。

|

||||

7. 删除BP_Sky_Sphere、高度雾与指数雾,添加新的使用Hdr的天空球(参照第二章节中的内容:场景捕获)后进行高级质量烘焙。

|

||||

8. 删除场景中的反射球,使用一个Box反射球作为主反射球,并将它大致放置在场景中间,之后调整Capture Offset数值来校准反射球。

|

||||

9. 关闭玻璃材质属性中的屏幕反射功能(Translucency-Screen Space Reflections),反射球效果依然有效。

|

||||

10. 检查材质是否正确,并进行调整(固有色、贴图等)

|

||||

11. 在观察到地板的不正常反射后,在后处理空间中开启了屏幕空间反射,并调节了反射质量。(r.sss.quality 4,r.sss.Temporal 0)之后发现反射噪点是材质粗糙度造成。

|

||||

12. 调节LightMass属性,Static Lighting Level Scale 1=》0.1,Indirect Lighting Quality 1=》6,Indirect Lighting Smoothness 1=》0.6,使用高级质量进行烘焙。这次烘焙花费4小时,烘焙的光照可以说相当好了,但在细微处还是有一些噪点,作者建议可以可以Indirect Lighting Quality再提高一些。

|

||||

13. 给场景带有高金属度与低粗糙度的物体添加反射球以解决物体渲染结果不对的问题。

|

||||

14. 视频3.3的时候作者的电脑突然原地爆炸了,鸽了段施加,但也因为更新了4.18版本,可喜可贺。使用Hdr+天光反弹,渲染效果变得更加自然了。作者还在场景中添加了方向光、聚光灯等主光源。修改了地板材质,并开启LightMass的AO选项(以掩盖SSR的问题)

|

||||

15. 作者展示一个骚操作,在材质编辑器中使用PreComputedAOMask节点来获取LightMass烘焙的AO信息。

|

||||

16. 作者将BP_Sky_Sphere加回来,同时把天光类型改成了使用CubeMap。

|

||||

|

||||

**使用PreComputedAOMask与澡波贴图来实现一些边角污垢效果**

|

||||

|

||||

|

||||

|

||||

**解决植被顶点动画模糊的问题**

|

||||

在Project Settins-Rendering-Optimizations勾选Accurate Velocities from Vertex Deformation选项,让TAA能够获取正确的速度值,即可解决。这对植被渲染十分重要。

|

||||

|

||||

#### 4.1章节的流程

|

||||

这次修改场景的要求是在保证黑暗之魂3场景风格的基础上,尽量让场景光照看起来真实。

|

||||

|

||||

Daedalus51首先检查了场景:

|

||||

场景的阳光比较强烈,但是天空却看上去很灰暗,场景的角落也比较黑,看来不真实。一些暗处的物体根本看不到细节。

|

||||

|

||||

存在问题:

|

||||

- 场景的阳光比较强烈,但是天空却看上去很灰暗,场景的角落也比较黑,看来不真实。一些暗处的物体根本看不到细节。

|

||||

- 很多材质开启曲面细分功能,但是曲面细分倍率设置的有问题。曲面细分还会导致物体再LightingOnly模式下不显示,所以Daedalus51把曲面细分关掉了。

|

||||

- 天空看来是淡黄色的,但天光却设置为蓝色(可以看得出建筑物有天光反弹的蓝色)。

|

||||

- 植被没有渲染细节阴影,但光照贴图分辨率却很高。

|

||||

|

||||

场景重置操作内容:

|

||||

- 重置方向光(去掉颜色,设置亮度为pi,设置间接光照强度为1,关闭Light Shalf Bloom

|

||||

- 重置级联阴影数值,但保留Dynamic Shadow Distance Stationary的参数)

|

||||

- 关闭材质的曲面细分功能

|

||||

- 重置世界设置中的LightMass设置。

|

||||

- 重置天光参数,亮度、颜色、间接照明强度。关闭半球固定色功能。

|

||||

- 重置后处理空间,并调整曝光数值。

|

||||

|

||||

1. 检查场景,将一些参数重置。

|

||||

2. 调整LightMass设置中的天光反弹与间接光照反弹1=》10。

|

||||

3. 删除BP_SkySphere,加入Hdr贴图制作的天空球,并通过旋转与位移将天空球与太阳匹配。

|

||||

4. 关闭大气雾。

|

||||

5. 调整场景中物体的LightMapDensity(主要是降低,因为有一些物体不需要细节阴影,你无法从一片叶子上获得更多的视觉效果,而且可以解决TextureStreamPool溢出与烘焙时间长的问题)

|

||||

6. 因为调节了所有的光照贴图密度,所以还需要调节世界设置中的Packed Light And Shadow Map Texture Size。

|

||||

7. 调整天光,关闭指数雾气,让天光重新捕获场景。调整方向光的间接照明强度从1=》1.5,让场景更加有艺术感。

|

||||

8. 使用中级质量对场景进行烘焙。

|

||||

9. 在烘焙的时候作者检查了场景的BaseColor。

|

||||

10. 烘焙完成,进入LightingOnly检查烘焙结果。可以看得出光照烘焙得不错,但场景还是挺黑的,这说明BaseColor有问题。

|

||||

11. 在修改完所有BaseColor贴图与部分材质后,再次进行烘焙。并在烘焙过程中移除fake灯光。

|

||||

12. 作者将场景中的火炬资源整合成一个Actor蓝图(灯光、粒子、模型),同时将灯光的间接照明强度从1=》1.6。并再次使用中级质量进行烘焙。

|

||||

13. 在项目设置中勾选Accurate Velocities from Vertex Deformation选项解决TAA鬼影问题。

|

||||

14. 在4.6章节作者开始分析黑魂场景,并指出一些补光错误(黄色的太阳光、背景与雾气,但部分地面上却是蓝色的)

|

||||

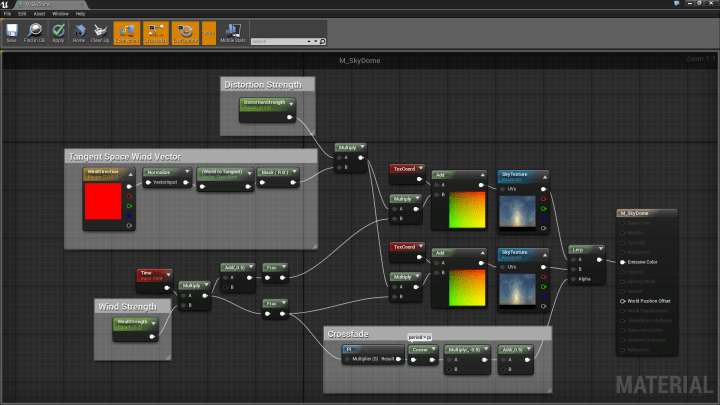

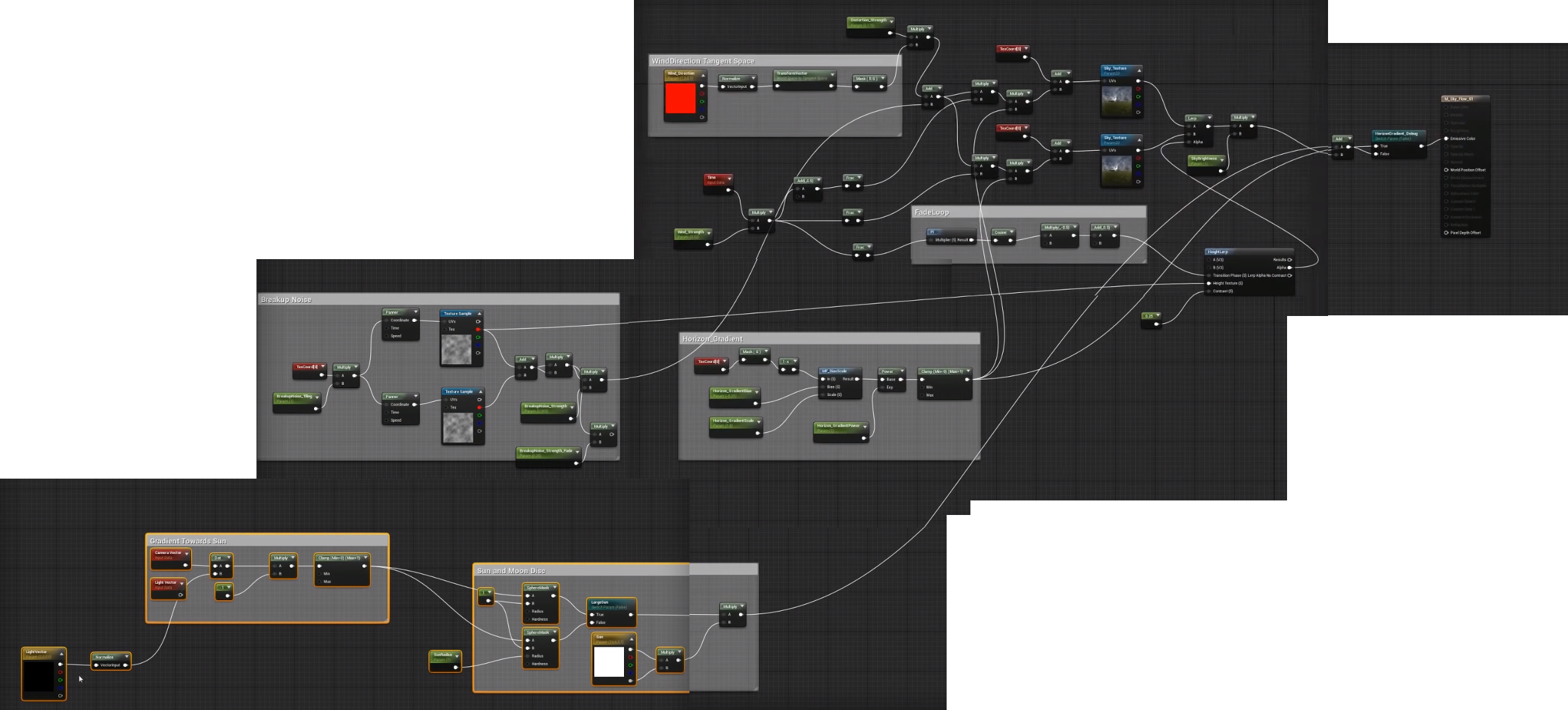

15. 作者并不喜欢默认的BP_Sky_Sphere,他更喜欢Hdr天空。同时他给出一种使用FlowMap让Hdr天空变得动态的方法。(GDC14 顽皮狗的演讲)之后作者分享了一篇Ue4实现方案http://kedama.works/archives/5,但很明显这个方案还有巨大的改进空间。

|

||||

于是在4.6 55min左右,作者开始展示改进过的Shader,不过还是存在一个顶部图像破裂的bug。(这个内容我放在第二篇文章里)

|

||||

|

||||

**调整前与调整后的LightMapDensity**

|

||||

|

||||

|

||||

|

||||

|

||||

**有关体积光照贴图**

|

||||

Unreal会根据场景模型分布情况分配体积采样点(对于重要的地方可以通过添加体积的方式调整采样点间距),**动态物体**会根据这些采样点进行插值着色,来实现GI效果。但LightMass只会对静态物体进行采样,而完全忽略动态物体。

|

||||

|

||||

这里作者又提到了树,因为树不适合使用LightMass烘焙光照,因为树的结构复杂会导致烘焙时间长而且效果很差,但是如果不使用LightMass就不会有GI效果。所以作者想到了设置两组树,第一组静态用于烘焙体积光照贴图,之后在场景中隐藏。另一种动态用于在场景中展示。这样就解决上面说的问题。

|

||||

|

||||

但这样做不能算是个完美的方法,所以作者希望EPIC能开发让一些特定的动态物体影响空间探针的功能。

|

||||

|

||||

**第一次烘焙完的结果**

|

||||

|

||||

|

||||

|

||||

**有关BaseColor**

|

||||

在检查BaseColor的过程中,发现地面的泥土材质的BaseColor太黑了(这个贴图的中间值为40,而达斯·维达那身黑乎乎的材质颜色Vec3(52,52,52)的中间值也至少为50)。具体的做法是调整亮度与饱和度。

|

||||

|

||||

所以作者对以下贴图进行修改:

|

||||

- 调整了泥土贴图,40=》81

|

||||

- 调整了地面的砖石贴图,70=>104

|

||||

- 调整了台阶贴图

|

||||

- 调整了柱子贴图,68=》104

|

||||

- 调整了砖墙贴图,97=》125

|

||||

- 调整了墙体贴图的金属部分,黑色=》中灰色

|

||||

- 等场景中的其他贴图

|

||||

|

||||

作者不建议固有色的中间值低于50或者高于230。

|

||||

|

||||

|

||||

|

||||

>4.5章节作者额外补充一些东西,个人强烈建议大家去看一下,虽然物理灯光因为引擎存在Bug没有讲完。

|

||||

|

||||

首先作者介绍了一下GPULightMass,可以看得出烘焙速度非常快。这次作者演示的场景比较简单,但包含了室内与室外部分,非常适合讲解新的物理灯光系统。

|

||||

|

||||

**使用物理灯光的原因**

|

||||

|

||||

之前版本中Unreal4的灯光使用的是虚幻单位,这是的之前版本的灯光没有一个物理值的衡量标准。你很可能会因为后处理空间、曝光等因素影响而无法设置出正确的亮度值。例如:你已经将一个区域的效果调整的很自然,但是别的区域就会很奇怪(bloom、阴影、光照等效果互相不匹配)。 而前人已经积累了大量的摄影知识与经验,所以我们没有必要光靠感觉来设置灯光亮度与曝光度,而需要使用摄影标准来设置灯光,从而使得场景更加真实。

|

||||

## 环境设置

|

||||

### 天光

|

||||

类型:static 关闭半球固定色

|

||||

### 方向光

|

||||

级联阴影的动态阴影距离设置为12000

|

||||

### 天空球

|

||||

引擎天空球模型+Hdr图+对应材质,具体参考第二篇文章写的内容。

|

||||

### 后处理空间

|

||||

保持默认

|

||||

### LightMass设置

|

||||

静态光照细节缩放等级0.1 光线反弹次数10 天光反弹次数10 间接照明质量4 间接照明平滑0.8 ## 视频中的操作过程 ### 使用摄像机参数来调整曝光度 所以我们能做的第一件事情就是通过sunny16原则来设置相机。 具体步骤为:在后处理空间——曝光中将模式改成手动,之后按照sunny16原则的户外晴天数值来设置Camera属性。

|

||||

|

||||

### 设置天空球亮度

|

||||

但此时画面还是黑乎乎的,这说明场景中的灯光强度太弱了。此时你直接调整天光强度是无效的,因为默认的天光是场景捕获模式。此时设置天空球亮度(设置材质),在视频中亮度提升到68000左右达到了一个不错的效果。这个时候再进行烘焙,模型的样子就不再是黑乎乎的了。 >使用像素检测器,可以检查对应像素的光照强度

|