Init

This commit is contained in:

132

02-Note/DAWA/2024.12.31新项目笔记.md

Normal file

132

02-Note/DAWA/2024.12.31新项目笔记.md

Normal file

@@ -0,0 +1,132 @@

|

||||

# 项目1,北京市科委研发项目

|

||||

需要在虚幻里访问api获得模型文件(fbx模型 png贴图)和场景描述(json) 在runtime下加载后,用于扣绿虚拍系统

|

||||

|

||||

# 项目2,国家数字资产平台

|

||||

根据访问需求,接通云游戏(使用蔚领云游戏SDK),然后收到前端的资产uuid,加载资产渲染。

|

||||

|

||||

## 第一阶段

|

||||

用户访问一个web平台,点击某个资产(模型or场景)

|

||||

会弹出一个页面,页面类似虚幻metahuman编辑器一样,是视频流的形式

|

||||

|

||||

在视频流中,是一个runtime窗口,可以渲染目标资产

|

||||

|

||||

## 第二阶段

|

||||

可以在前端点击资产添加,runtime窗口里会添加资产,然后runtime窗口里有简单编辑器可以摆镜头,可以简单摆放资产

|

||||

|

||||

# Default材质

|

||||

标准pbr(半透明)

|

||||

提供参数

|

||||

1. base color (tex)

|

||||

2. basecolor tilt (v3) 乘basevolor

|

||||

4. opacity(tex linear)

|

||||

5. opacity power(scale)乘到opacity

|

||||

6. roughness(tex linear color)

|

||||

7. roughness tilt(scale) 乘roughness

|

||||

8. metalic (tex linear color)

|

||||

9. metalic tilt(scale)

|

||||

10. ao (tex linear color)

|

||||

11. emisive(tex)

|

||||

12. emisive power(scale) 乘emisive

|

||||

13. normal(tex)

|

||||

|

||||

|

||||

# FaceSet

|

||||

https://github.com/zenustech/zeno/blob/b4ed8740810f20cf0612d615d9505468b2d2a4d1/projects/FBX/FBXSDK.cpp#L477

|

||||

|

||||

```c++

|

||||

int mat_count = 0;

|

||||

if (pMesh->GetElementMaterialCount() > 0) {

|

||||

for (auto i = 0; i < numPolygons; ++i) {

|

||||

faceset[i] = pMesh->GetElementMaterial()->GetIndexArray().GetAt(i);

|

||||

}

|

||||

mat_count = pNode->GetMaterialCount();

|

||||

for (auto i = 0; i < mat_count; i++) {

|

||||

FbxSurfaceMaterial* material = pNode->GetMaterial(i);

|

||||

ud.set2(format("faceset_{}", i), material->GetName());

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

UE中相关逻辑位于FbxMesh.cpp

|

||||

```c++

|

||||

void ExtractMeshMaterials(FFbxParser& Parser, FbxMesh* Mesh, FbxNode* MeshNode, TFunction<void(const FString& MaterialName, const FString& MaterialUid, const int32 MeshMaterialIndex)> CollectMaterial)

|

||||

{

|

||||

if (!Mesh || !MeshNode)

|

||||

{

|

||||

return;

|

||||

}

|

||||

|

||||

//Grab all Material indexes use by the mesh

|

||||

TArray<int32> MaterialIndexes;

|

||||

int32 PolygonCount = Mesh->GetPolygonCount();

|

||||

if (FbxGeometryElementMaterial* GeometryElementMaterial = Mesh->GetElementMaterial())

|

||||

{

|

||||

FbxLayerElementArrayTemplate<int32>& IndexArray = GeometryElementMaterial->GetIndexArray();

|

||||

switch (GeometryElementMaterial->GetMappingMode())

|

||||

{

|

||||

case FbxGeometryElement::eByPolygon:

|

||||

{

|

||||

if (IndexArray.GetCount() == PolygonCount)

|

||||

{

|

||||

for (int32 PolygonIndex = 0; PolygonIndex < PolygonCount; ++PolygonIndex)

|

||||

{

|

||||

MaterialIndexes.AddUnique(IndexArray.GetAt(PolygonIndex));

|

||||

}

|

||||

}

|

||||

}

|

||||

break;

|

||||

|

||||

case FbxGeometryElement::eAllSame:

|

||||

{

|

||||

if (IndexArray.GetCount() > 0)

|

||||

{

|

||||

MaterialIndexes.AddUnique(IndexArray.GetAt(0));

|

||||

}

|

||||

}

|

||||

break;

|

||||

}

|

||||

}

|

||||

const int32 MaterialCount = MeshNode->GetMaterialCount();

|

||||

TMap<FbxSurfaceMaterial*, int32> UniqueSlotNames;

|

||||

UniqueSlotNames.Reserve(MaterialCount);

|

||||

bool bAddAllNodeMaterials = (MaterialIndexes.Num() == 0);

|

||||

for (int32 MaterialIndex = 0; MaterialIndex < MaterialCount; ++MaterialIndex)

|

||||

{

|

||||

if (FbxSurfaceMaterial* FbxMaterial = MeshNode->GetMaterial(MaterialIndex))

|

||||

{

|

||||

int32& SlotMaterialCount = UniqueSlotNames.FindOrAdd(FbxMaterial);

|

||||

FString MaterialName = Parser.GetFbxHelper()->GetFbxObjectName(FbxMaterial);

|

||||

FString MaterialUid = TEXT("\\Material\\") + MaterialName;

|

||||

if (bAddAllNodeMaterials || MaterialIndexes.Contains(MaterialIndex))

|

||||

{

|

||||

if (SlotMaterialCount > 0)

|

||||

{

|

||||

MaterialName += TEXT("_Section") + FString::FromInt(SlotMaterialCount);

|

||||

}

|

||||

SlotMaterialCount++;

|

||||

CollectMaterial(MaterialName, MaterialUid, MaterialIndex);

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

#

|

||||

AFBXMeshActor::AddMesh

|

||||

|

||||

|

||||

UFBXSceneImporter::ImportFBX()

|

||||

=>

|

||||

UFBXSceneImporter::ProcessNode()

|

||||

=>

|

||||

UFBXSceneImporter::ProcessMesh()

|

||||

=>

|

||||

UFBXSceneImporter::CreateNodeMaterials()

|

||||

=>

|

||||

FBXImportSettings->GetMaterialProperties(FbxMaterial, Node->GetName());

|

||||

|

||||

## FaceSet

|

||||

FbxGeometryElementMaterial* GetElementMaterial

|

||||

|

||||

FbxGeometryElementMaterial(FbxLayerElementMaterial),

|

||||

119

02-Note/DAWA/AI/AI资产生成管线思路.md

Normal file

119

02-Note/DAWA/AI/AI资产生成管线思路.md

Normal file

@@ -0,0 +1,119 @@

|

||||

# 其他软件的思路

|

||||

## MeshY

|

||||

1. 模型+三视图+关键字&标签 => 贴图贴上模型,并且生成对应的贴图

|

||||

1. LJJ:可行性与实现意义并不大,因为需要一个相对准确的三视图。

|

||||

2. DCC软件已经有一个这样的工具,速度差不多,优势并不大 https://www.youtube.com/watch?v=Gh_LzoliD6A

|

||||

2. 文字&关键字&标签 => 模型

|

||||

1. 意义比较大,而且已经有插件做到了这一点。

|

||||

1. https://youtu.be/z9XjdcgP8TA?si=eEFS9AZ_2C0yud-O&t=206

|

||||

2. AI生成点云数据

|

||||

1. https://www.youtube.com/watch?v=5uF5-iIs-yY&t=113s

|

||||

2. https://www.youtube.com/watch?v=OEfV3RRpmRE

|

||||

|

||||

## 绘画软件SubstancePatiner

|

||||

个人认为最好是

|

||||

- Substance Painter 通过关键字生成笔刷Mask贴图,或者材质笔刷。

|

||||

- 模仿Substance Painter 对模型的某个材质或者某个区域添加关键字。

|

||||

|

||||

在此基础上可以通过给指定区域(绘制Mask)添加标签以及细致标签可以达到更加精确的效果。但我们还需要选择开发基础软件,我推荐Blender与UE:

|

||||

|

||||

# 宿主软件选择&开发思路&开发计划

|

||||

从开发效率方面考虑建议,先在软件现成功能的基础上进行开发,再原型确定之后再分别移植到其他的软件上。这里推荐UnrealEngine与Blender。同时Blender的SendToUnrealEngine插件相比其他DCC Send To UE插件,功能更好。所以建议如下:

|

||||

- 模仿普罗米修斯建立一个资产管理工具&数据及控制中心(下文简称MetaCenter)

|

||||

- 建议使用Electron进行开发(重界面轻功能推荐使用Electron开发速度快,前后端人员可以上手;其他还是有React Native等)

|

||||

- 其优势在于有良好的人机学习环境,用户在整理资产的过程就是AI学习的过程。同时用户社区分享预设也可以起到一个评分系统的作用。

|

||||

- 同时也可以作为今后给资产打Tag的基础工具。

|

||||

- 建议让杨萱羽花时间去摸索一下,总结功能以及工作流程。

|

||||

- 规避资产库版权问题[[#资产库问题]]

|

||||

- Blender基础上开发AI辅助绘制贴图插件(需要知道Blender的贴图绘制距离SP还差哪些功能)

|

||||

- 推荐的参考对象是[dDo](https://www.bilibili.com/video/BV18K4y1b7qe/?spm_id_from=333.337.search-card.all.click&vd_source=d47c0bb42f9c72fd7d74562185cee290)(以多种特征贴图来生成细节)以及SubstancePainter的AI功能。

|

||||

- 关键字生成笔刷Mask贴图,或者材质笔刷。

|

||||

- 通过对模型的某个材质或者某个区域添加关键字的方式来生成区域贴图。

|

||||

- 建议找一个对Blender以及Python都很了解的人去评估一下。

|

||||

- UE基础上开发场景摆放&语义控制&连接MetaCenter

|

||||

- 具体参考polygonflow.io以及普罗米修斯

|

||||

- 图片生成点云功能方便设计以及搭建场景(影视向)

|

||||

- 第二期开发可以考虑VR摆场景

|

||||

|

||||

## 插件承载载体推荐使用Blender

|

||||

Blender具有一个比较完善的插件市场

|

||||

1. Blender具有比较完整的绘画以及3D工具

|

||||

1. Convert Ai generated 2D images to 3D models for use in Blender and Gravity Sketch. https://www.youtube.com/watch?v=Wf-OmHyFduo

|

||||

|

||||

### 开发思路

|

||||

假设一个物体(剑)是由很多个小物体组成的,我们要给房子绘制贴图。这里我们需要考虑提供哪些信息给AI,并且考虑如何做加法/减法来达到最终的目的(调整以下行为的顺序):

|

||||

- 给AI一个3D模型

|

||||

- 参考dDo给剑不同材质、颜色区域指定不同的纯色。(AI无法判断整体,但对细致的区域学习较快)

|

||||

- 给每个纯色区域一个或者多个关键字

|

||||

- 给纯色区域的过渡区域一个关键词

|

||||

- 以辅助绘制的方式,在模型上绘制BaseColor或者NormalMap

|

||||

- 在模型上绘制 重新计算区域让AI重新生成

|

||||

- 给AI参考图(3视图 =>大致印象参考图)

|

||||

|

||||

优势在于:

|

||||

1. 有良好的人机学习环境。

|

||||

2. 递进式的创建工作。

|

||||

|

||||

### 风格化贴图

|

||||

对大规模卡通&风格化资产打标签,来让AI学习。 资产来源可以是Taobao(剑网三、龙之谷等)以及游戏提取资产。

|

||||

## UE插件方案参考

|

||||

***普罗米修斯的方案很好实现了用户与AI模型的交互,在用户的使用就可以不断训练AI。***

|

||||

|

||||

1. 根据照片&关键词快速从 Quixel或者其他免费资产库中找到资产,并且导入UE中(甚至摆放好)

|

||||

1. www.polygonflow.io 【【AI教程】地编又要降工资了?UE5地编全新AI辅助工具问世!】 【精准空降到 01:06】 https://www.bilibili.com/video/BV1VN411p7FF/?share_source=copy_web&vd_source=fe8142e8e12816535feaeabd6f6cdc8e&t=66

|

||||

2. 普罗米修斯

|

||||

1. Meta Data(外部工具编辑资产的Meta数据)

|

||||

1. 【普罗米修斯AI插件在虚幻引擎的基础教程Artificial Intelligence That Builds Virtual Worlds】 【精准空降到 06:15】 https://www.bilibili.com/video/BV1gM411K7Up/?share_source=copy_web&vd_source=fe8142e8e12816535feaeabd6f6cdc8e&t=375

|

||||

2. 【普罗米修斯AI插件在虚幻引擎的基础教程Artificial Intelligence That Builds Virtual Worlds】 【精准空降到 10:34】 https://www.bilibili.com/video/BV1gM411K7Up/?share_source=copy_web&vd_source=fe8142e8e12816535feaeabd6f6cdc8e&t=634

|

||||

3. https://youtu.be/hA0MsGWvmzs?si=3WK8T4WfNqj71rRw&t=1386

|

||||

2. 资源添加

|

||||

1. https://youtu.be/z9XjdcgP8TA?si=2oIHdtVrZnF8P9bx&t=101

|

||||

3. 关键词语生成资产摆放

|

||||

1. https://youtu.be/z9XjdcgP8TA?si=eEFS9AZ_2C0yud-O&t=206

|

||||

4. 识别本地资产并且创建标签

|

||||

1. https://youtu.be/hA0MsGWvmzs?si=WxHYO4H9bSeDQ4lN&t=546

|

||||

5. 资产智能摆放

|

||||

1. https://youtu.be/hA0MsGWvmzs?si=oLZYS8JO4wGV-Xzz&t=716

|

||||

6. 100%程序化流程(代表所有操作都是可逆的或者是节点化的)

|

||||

1. https://youtu.be/hA0MsGWvmzs?si=j2ISS0gL6LKzeJfE&t=1067

|

||||

7. 外部程序 <==> UE 相互拖拽

|

||||

1. https://youtu.be/hA0MsGWvmzs?si=Irn_TFy0Mri2furg&t=1669

|

||||

8. 社区互动

|

||||

1. https://youtu.be/hA0MsGWvmzs?si=m5iQ_tAxd9UOu667&t=1701

|

||||

|

||||

# 问题&解答

|

||||

## 资产库问题

|

||||

普罗米修斯的方案是组织用户自己的资产库;polygonflow是UE插件,连接到MegaScane Bridge可以规避版权问题。

|

||||

|

||||

## 其他资产来源&应用

|

||||

1. taobao可以购买龙之谷等以前游戏的资产。

|

||||

2. SubstancePainter AI笔刷 https://www.artstation.com/artwork/038Qz5

|

||||

3. https://substance3d.adobe.com/magazine/ai-power-2d-painting-a-massive-boost-for-substance-alchemist/

|

||||

4. Stylized Environment Texturing in Mixer:https://www.youtube.com/watch?v=kg4YFS6b0ek

|

||||

|

||||

---

|

||||

# 其他待讨论的问题

|

||||

- [ ] 目标是什么?什么应用场景?使用AI生产模型以及贴图?大概需要多少样本?(样本可能不够)

|

||||

- [ ] 是否以最终效果作为判断依据:以蓝色协议这种二次元游戏来说,他定制了渲染管线,贴图除了颜色贴图,还有一些控制渲染变量用的贴图、以及一些不方便导出的渲染变量。环境物体主要的颜色贴图、法线贴图、Roughness、Metallic。**角色贴图**会有一些卡通效果控制类的,那些贴图意义不大。(环境物体可能还会做一次SNN滤镜)

|

||||

- [ ] 使用材质修改颜色的换皮怪是否会影响最后的训练结果?

|

||||

- [ ] 最终输出哪些东西? 与游戏目录结构相同的文件目录以及对应贴图模型文件、附带一个Model=>Textures JSON? 场景StaticMesh,是否包含骨骼模型?

|

||||

- [ ] 是否需要Motion?

|

||||

|

||||

个人认为直接上手二次元比较难,还是倾向于PBR或是偏向pbr的卡通渲染&风格化渲染。

|

||||

1. DDO绘制流程:https://www.bilibili.com/video/BV18K4y1b7qe/?spm_id_from=333.337.search-card.all.click&vd_source=d47c0bb42f9c72fd7d74562185cee290

|

||||

2. PBR资产库比较多,一些AI场景工具,直接根据图片来查找Quixel或者其他资产库的资产,并且下载到项目里。

|

||||

|

||||

# 模型贴图对应方式

|

||||

Model => MaterialInstance => Textures

|

||||

{

|

||||

[

|

||||

{

|

||||

Model:/Model/1.fbx,

|

||||

Textures:[

|

||||

/Model/Textures/1.tga,

|

||||

/Model/Textures/2.tga,

|

||||

/Model/Textures/3.tga,

|

||||

]

|

||||

}

|

||||

]

|

||||

}

|

||||

36

02-Note/DAWA/AI/动画重定向功能调研.md

Normal file

36

02-Note/DAWA/AI/动画重定向功能调研.md

Normal file

@@ -0,0 +1,36 @@

|

||||

# 待选目标

|

||||

1. UE5自带的动画重定向功能

|

||||

2. Swift Motion Toolkit

|

||||

1. https://www.unrealengine.com/marketplace/zh-CN/product/swift-motion-toolkit?sessionInvalidated=true

|

||||

3. ~~UE4自带的动画重定向功能~~

|

||||

4. ~~VRM4U实现的动画重定向功能~~

|

||||

## Swift Motion Toolkit

|

||||

Showcase:

|

||||

[Mixamo Animation to Manny](https://redirect.epicgames.com/?redirectTo=https://www.youtube.com/embed/_p9ttnPKMYI)

|

||||

[Mocap dancing to Mannequin](https://redirect.epicgames.com/?redirectTo=https://www.youtube.com/embed/dRPSrGvM67U)

|

||||

[Mocap aiming to Mannequin](https://redirect.epicgames.com/?redirectTo=https://www.youtube.com/embed/ZWKmjRFj-kEhttps://www.youtube.com/embed/ZWKmjRFj-kE)

|

||||

[Mocap plane to Manny](https://redirect.epicgames.com/?redirectTo=https://www.youtube.com/embed/ZWKmjRFj-kE)

|

||||

|

||||

[Video tutorials](https://redirect.epicgames.com/?redirectTo=https://www.youtube.com/playlist?list=PLt62Gv_wadqXZW6YQkZCXNoVAg8s9NxwI)

|

||||

[Documents](https://redirect.epicgames.com/?redirectTo=https://kontiki.info/swift_motion_toolkit)

|

||||

### 技术细节

|

||||

Features:

|

||||

- Import mo-cap animation in BVH format and provide a preview.

|

||||

- Retarget mo-cap animation to skeletal mesh asset.

|

||||

- Supports more precise restoration of the position of end joints using IK.

|

||||

- Supports synchronizing animation to root and IK bones.

|

||||

- Supports baking vertical or (and) horizontal root displacements into animations.

|

||||

- Support for selectively preserving root rotation.

|

||||

- Support for converting animations with root motion to in-place animations.

|

||||

|

||||

# 项目需求

|

||||

1. 研究UE5的骨骼链&IK 动画重定向算法。

|

||||

2. 研究Swift Motion Toolkit的动画重定向算法。

|

||||

3. 比较两者算法优劣;并从Runtime的角度提出改进思路。

|

||||

4. 搜索相关动画重定向论文,编写算法解析文档。

|

||||

## 重定向过程简述(输入&输出)

|

||||

1. 提供SourceSkeleton、TargetSkeleton2个骨骼FBX文件,以及若干SourceAnimation动画数据(基于SourceSkeleton)FBX文件。

|

||||

2. 通过计算SourceSkeleton、TargetSkeleton差异,将SourceAnimation动画数据转换成TargetSkeleton版本的动画数据。

|

||||

3. 输出成FBX文件。

|

||||

|

||||

# 怎么对接

|

||||

107

02-Note/DAWA/AI/协助构建ue-runtime镜像请求.md

Normal file

107

02-Note/DAWA/AI/协助构建ue-runtime镜像请求.md

Normal file

@@ -0,0 +1,107 @@

|

||||

# 问题

|

||||

使用Ubantu官方安装的系统编译的v8环境放入Puerts插件后可以正常运行;使用 adamrehn/ue4-runtime:22.04-vulkan-x11镜像下载编译环境后,编译v8环境并且放入puerts插件,运行后会报错。初步认为是编译环境有问题所致。可能是因为参与编译的libatomic.so.1库是32位的。

|

||||

![[Puerts启动错误.png]]

|

||||

# 需求

|

||||

1. 参考 adamrehn/ue4-runtime:22.04-vulkan-x11,重新构建容器

|

||||

2. 安装下列环境以进行Puerts的V8环境编译

|

||||

```bash

|

||||

sudo apt-get install clang

|

||||

sudo apt-get install libc++-dev

|

||||

sudo apt-get install libc++abi-dev

|

||||

sudo apt-get install make

|

||||

curl -sL https://deb.nodesource.com/setup_16.x | sudo -e bash -

|

||||

sudo apt-get install -y nodejs

|

||||

sudo apt-get install git

|

||||

```

|

||||

|

||||

```bash

|

||||

# 下载编译脚本,脚本需要手动修改一下

|

||||

cd /home/user/Projects/

|

||||

git clone https://github.com/puerts/backend-nodejs.git

|

||||

cd /home/user/Projects/backend-nodejs/node-script

|

||||

npm install -s commander

|

||||

/home/user/Projects/backend-nodejs/linux.sh

|

||||

```

|

||||

**修改过的编译脚本**:

|

||||

```sh

|

||||

WORKSPACE=/home/user/Projects/backend-nodejs

|

||||

HOMEPATH=~

|

||||

VERSION=$1

|

||||

|

||||

cd $HOMEPATH

|

||||

# git clone https://github.com/nodejs/node.git

|

||||

|

||||

cd node

|

||||

# git fetch origin v$VERSION

|

||||

# git checkout v$VERSION

|

||||

|

||||

echo "=====[Patching Node.js]====="

|

||||

node $WORKSPACE/node-script/do-gitpatch.js -p $WORKSPACE/patchs/lib_uv_add_on_watcher_queue_updated_v16.16.0.patch

|

||||

node $WORKSPACE/node-script/add_arraybuffer_new_without_stl.js deps/v8

|

||||

node $WORKSPACE/node-script/make_v8_inspector_export.js

|

||||

|

||||

echo "=====[Building Node.js]====="

|

||||

export CC=clang

|

||||

export CXX=clang++

|

||||

export CXXFLAGS="-stdlib=libc++"

|

||||

export LDFLAGS="-stdlib=libc++"

|

||||

|

||||

./configure --shared

|

||||

make -j8

|

||||

|

||||

# 这后面可以的可以不要,执行需要libnode.so.93 libnode.so

|

||||

mkdir -p ../puerts-node/nodejs/include

|

||||

mkdir -p ../puerts-node/nodejs/deps/uv/include

|

||||

mkdir -p ../puerts-node/nodejs/deps/v8/include

|

||||

|

||||

cp src/node.h ../puerts-node/nodejs/include

|

||||

cp src/node_version.h ../puerts-node/nodejs/include

|

||||

cp -r deps/uv/include ../puerts-node/nodejs/deps/uv

|

||||

cp -r deps/v8/include ../puerts-node/nodejs/deps/v8

|

||||

|

||||

mkdir -p ../puerts-node/nodejs/lib/Linux/

|

||||

cp out/Release/libnode.so.* ../puerts-node/nodejs/lib/Linux/

|

||||

cd ../puerts-node/nodejs/lib/Linux/

|

||||

ln -s libnode.so.93 libnode.so

|

||||

cd -

|

||||

```

|

||||

|

||||

## 原容器存在问题

|

||||

adamrehn/ue4-runtime:22.04-vulkan-x11存在的问题:

|

||||

1. 缺少相关编译环境。

|

||||

2. 没有设置环境变量不知道root、ue4账号密码。

|

||||

3. 参与编译的libatomic.so.1库是32位的。

|

||||

|

||||

经过测试使用官方镜像安装的Ubantu可以正常进行编译(UE项目以及Puerts v8环境),并且可以正常打开项目;原容器可以编译UE项目,但因为编译的Puerts v8环境有一些问题导致无法运行Puerts。

|

||||

|

||||

## 启动命令参考

|

||||

```bash

|

||||

运行UE用:

|

||||

sudo docker run --gpus=all --rm -e DISPLAY -ti \

|

||||

-v /tmp/.X11-unix:/tmp/.X11-unix:rw \

|

||||

-v /home/user/Linux_Unreal_Engine_5.1.1:/home/ue4/UnrealEngine \

|

||||

-v /home/user/Projects/AIMotionRender:/project \

|

||||

adamrehn/ue4-runtime:22.04-vulkan-x11

|

||||

|

||||

编译v8环境用:

|

||||

sudo docker run -u 0 --gpus=all --rm -e DISPLAY -ti \

|

||||

-v /tmp/.X11-unix:/tmp/.X11-unix:rw \

|

||||

-v /home/user/Linux_Unreal_Engine_5.1.1:/home/ue4/UnrealEngine \

|

||||

-v /home/user/Projects/AIMotionRender:/project \

|

||||

-v /home/user/node:/home/user/node \

|

||||

-v /home/user/Projects/backend-nodejs:/home/user/Projects/backend-nodejs \

|

||||

adamrehn/ue4-runtime:22.04-vulkan-x11

|

||||

```

|

||||

|

||||

# UE项目测试方法

|

||||

将编译出来的libnode.so.93 libnode.so放入/home/user/Projects/AIMotionRender/Plugins/Puerts/ThirdParty/nodejs_16/lib/Linux 目录下,之后就可以启动容器

|

||||

|

||||

/home/ue4/UnrealEngine/Engine/Build/BatchFiles/Linux/GenerateProjectFiles.sh /project/AIMotionRender.uproject -game -engine -rocket -progress -VSCode

|

||||

|

||||

编译命令:

|

||||

/home/ue4/UnrealEngine/Engine/Build/BatchFiles/Linux/Build.sh Development Linux -Project="/project/AIMotionRender.uproject" -TargetType=Editor -Progress -NoEngineChanges -NoHotReloadFromIDE

|

||||

|

||||

启动命令:

|

||||

/home/ue4/UnrealEngine/Engine/Binaries/Linux/UnrealEditor -log "/project/AIMotionRender.uproject"

|

||||

|

||||

启动过程没有报错就可以了。

|

||||

408

02-Note/DAWA/AI偶像陪伴项目/AIVirtualIdel动画方案.md

Normal file

408

02-Note/DAWA/AI偶像陪伴项目/AIVirtualIdel动画方案.md

Normal file

@@ -0,0 +1,408 @@

|

||||

# 动画方案

|

||||

预制开始/等待动画 -> VMC推流动画 -> 预制结束/等待动画

|

||||

## VMC推流

|

||||

[[AnimNode & VMC笔记]]

|

||||

|

||||

|

||||

## 迭代动画状态机方案

|

||||

1. 由ChatGPT模型AI使用之前录制动画素材拼凑出N组排列组合。

|

||||

2. 动画资产以及排列数据进行定期热更新。(自动 | 人工)

|

||||

3. 实时直播时由ChatGPT发送指定排列组合的名称或者ID给客户端,之后客户端播放对应的排列组合动画。

|

||||

|

||||

# 推流方案

|

||||

推流视频:

|

||||

- https://www.bilibili.com/video/BV1ub4y1Y74K/?spm_id_from=333.337.search-card.all.click&vd_source=d47c0bb42f9c72fd7d74562185cee290

|

||||

- https://www.youtube.com/watch?v=ufU9me5pDYE&t=2s

|

||||

|

||||

# 协议

|

||||

## OSC

|

||||

一种基于UDP的**远程控制协议**,传输的数据主要分为Bundle 与 Message。

|

||||

- OSC:https://opensoundcontrol.stanford.edu/index.html

|

||||

- Nodejs的OSC实现:https://www.npmjs.com/package/osc

|

||||

- 案例代码库:https://github.com/colinbdclark/osc.js-examples

|

||||

|

||||

### 反序列化步骤

|

||||

1. 调用`ReadOSC()`

|

||||

2. ReadOSCString,读取Address。主要分为`#bundle`、`#message`。

|

||||

3. `#bundle`

|

||||

1. 读取uint64 Time。

|

||||

2. 调用`ReadOSC()`,递归序列化之后的数据。

|

||||

4. `#message`:基础数据反序列化逻辑

|

||||

1. 读取FString Semantics,里面每个字符代表之后基础数据的类型。

|

||||

2. 根据基础数据类型进行反序列化,一个数据生成一个FUEOSCElement。

|

||||

|

||||

```c++

|

||||

UENUM()

|

||||

enum class EUEOSCElementType : uint8

|

||||

{

|

||||

OET_Int32 UMETA(DisplayName = "Int32"),

|

||||

OET_Float UMETA(DisplayName = "Float"),

|

||||

OET_String UMETA(DisplayName = "String"),

|

||||

OET_Blob UMETA(DisplayName = "Blob"),

|

||||

OET_Bool UMETA(DisplayName = "Bool"),

|

||||

OET_Nil UMETA(DisplayName = "Nil")

|

||||

};

|

||||

```

|

||||

|

||||

### UEOSC实现分析

|

||||

一个数据包的格式为:

|

||||

```c++

|

||||

USTRUCT(BlueprintType)

|

||||

struct UEOSC_API FUEOSCMessage

|

||||

{

|

||||

GENERATED_USTRUCT_BODY()

|

||||

|

||||

public:

|

||||

FString Address;

|

||||

TArray<FUEOSCElement> Elements;

|

||||

};

|

||||

```

|

||||

其中`FUEOSCElement`存储的具体数据,里面是一个结构体存储着基础数据类型数据以及数据类型枚举。

|

||||

|

||||

#### 基础数据类型

|

||||

数据以结构体形式进行序列化/反系列化。可携带的数据类型为:

|

||||

- int32、int64、uint64

|

||||

- float32

|

||||

- String(`FName`)

|

||||

- blob(`TArray<uint8>`)

|

||||

- bool

|

||||

|

||||

## VMC

|

||||

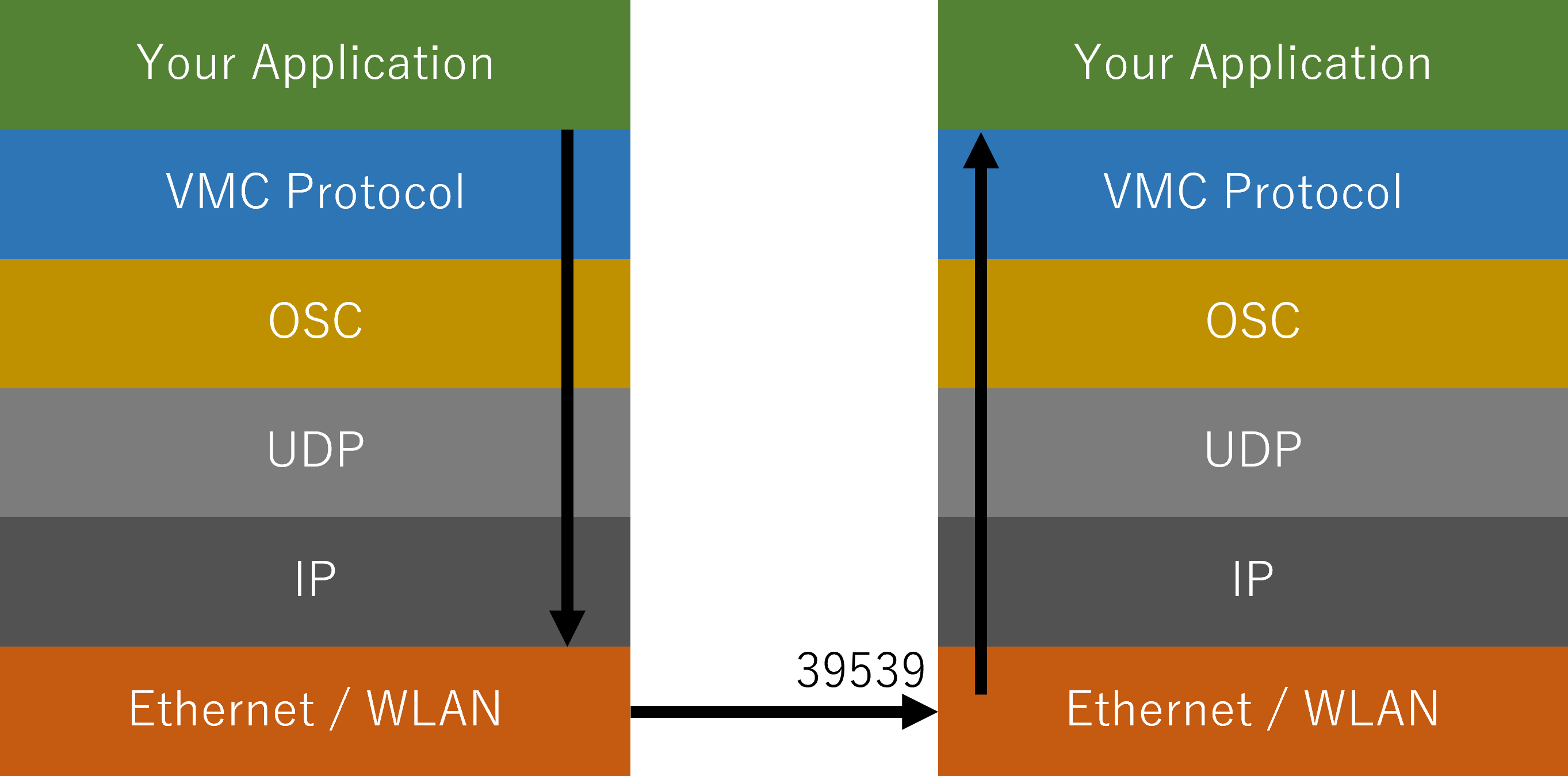

全名为Virtual Motion Capture Protocol,一种基于OSC的虚拟偶像动作输出传输协议。

|

||||

|

||||

**存在问题**:

|

||||

1. 数据没有压缩,不适合互联网传输。

|

||||

2. 基于OSC这种UDP协议数据没有可靠性。

|

||||

|

||||

### 协议分析

|

||||

- VMC协议可视化工具:https://github.com/gpsnmeajp/VMCProtocolMonitor

|

||||

- https://protocol.vmc.info/specification

|

||||

- performer-spec:https://protocol.vmc.info/performer-spec

|

||||

- marionette-spec:https://protocol.vmc.info/marionette-spec

|

||||

|

||||

VMC协议基本上实现了开放声音控制(OSC)单向UDP通信来进行通信。

|

||||

|

||||

因此,VMC 协议定义了自己的术语:

|

||||

- **木偶**(**Marionette**)

|

||||

- 接收动作、绘制等。(必填)

|

||||

- 它的存在最终是为了在屏幕、视频、通讯上产生结果。

|

||||

(示例:EVMC4U、VMC4UE、其他运动接收兼容应用程序)

|

||||

- **表演者**(**performer**)

|

||||

- 主要处理运动并向 Marionette 发送**全身骨骼信息 (IK)** 和**辅助信息**。(必填)

|

||||

- (例如虚拟动作捕捉、Waidayo、VSeeFace、MocapForAll、TDPT 等)

|

||||

- **助理**(**Assistant**)

|

||||

- 主要不处理动作并向表演者发送辅助信息。(可选)

|

||||

- 仅负责**发送辅助**信息。(**一些骨骼、跟踪器姿势、面部表情**等)

|

||||

(例如,face2vmc 模式下的 Waidayo、Sknuckle、Simple Motion Tracker、Uni-studio 等)

|

||||

|

||||

具体沟通规定如下:

|

||||

- 通信时使用适当类型的 OSC。

|

||||

- 字符串采用 UTF-8 编码,可以用日语发送。

|

||||

- 至于端口号,Marionette 将监听端口:39539,而 Performer 将监听端口:39540,但从 UX 角度来看,我们建议您更改发送地址

|

||||

和接收端口。

|

||||

- 数据包在适当的范围内(1500 字节以内)进行捆绑,并且应由接收方进行适当的处理。

|

||||

- 传输周期以发送方的任意间隔执行。并非所有消息都会在每个周期发送。

|

||||

另外,发送方应该能够调整发送周期的间隔,或者以足够低的频率发送。

|

||||

- 接收方应丢弃不必要的消息。您不必处理所有消息。

|

||||

- 发送或接收哪些消息取决于两者的实现。

|

||||

- 未知地址,应忽略太多参数。

|

||||

- 如果您发现参数太少或类型与扩展规范中定义的参数不同,请将它们视为错误或忽略它们。

|

||||

|

||||

|

||||

|

||||

|

||||

### performer-spec

|

||||

这是`Marionette→Performer`或`Assistent→Performer`流程中的发送数据的规范。

|

||||

|

||||

主要有:

|

||||

- 虚拟设备转换

|

||||

- 帧周期

|

||||

- 虚拟 MIDI CC 值输入

|

||||

- 虚拟摄像机变换和 FOV

|

||||

- VRM BlendShapeProxyValue

|

||||

- 眼动追踪目标位置

|

||||

- [事件发送]信息发送请求(Request Information)

|

||||

- [事件传输] 响应字符串

|

||||

- [事件发送] 校准(准备)请求(校准/校准就绪请求)

|

||||

- [事件发送]请求加载设置文件

|

||||

- 通过信息

|

||||

- DirectionalLight 位置/颜色(DirectionalLight 变换和颜色)

|

||||

- [事件传输] 快捷调用(Call Shortcut)

|

||||

|

||||

#### 虚拟设备转换

|

||||

主要为:虚拟头显、控制器Controller和追踪器Track。(HMD被视为跟踪器)

|

||||

结构为:虚拟序列号 -> Position ->Quaternion

|

||||

```json

|

||||

V2.3

|

||||

/VMC/Ext/Hmd/Pos (string){serial} (float){p.x} (float){p.y} (float){p.z} (float){q.x} (float){q.y} (float){q.z} (float){q.w}

|

||||

/VMC/Ext/Con/Pos (string){serial} (float){p.x} (float){p.y} (float){p.z} (float){q.x} (float){q.y} (float){q.z} (float){q.w}

|

||||

/VMC/Ext/Tra/Pos (string){serial} (float){p.x} (float){p.y} (float){p.z} (float){q.x} (float){q.y} (float){q.z} (float){q.w}

|

||||

```

|

||||

|

||||

#### 帧周期

|

||||

设置虚拟动作捕捉的数据传输间隔。 以 1/x 帧间隔发送。

|

||||

```json

|

||||

V2.3

|

||||

/VMC/Ext/Set/Period (int){Status} (int){Root} (int){Bone} (int){BlendShape} (int){Camera} (int){Devices}

|

||||

```

|

||||

|

||||

### marionette-spec

|

||||

这是`Performer → Marionette`流程中的发送数据的规范。

|

||||

- 内容:基础状态描述,校准状态、校准模式、追踪状态

|

||||

- 发送者相对时间(Time)

|

||||

- 根变换

|

||||

- 骨骼变换

|

||||

- VRM BlendShapeProxyValue

|

||||

- 相机位置/FOV(相机变换和FOV)

|

||||

- 控制器输入

|

||||

- [事件传输]键盘输入

|

||||

- [事件传输] MIDI 音符输入

|

||||

- [事件传输] MIDI CC 值输入

|

||||

- [事件传输] MIDI CC 按钮输入

|

||||

- 设备改造

|

||||

- [低频] 接收使能

|

||||

- [低频] DirectionalLight 位置/颜色(DirectionalLight 变换和颜色)

|

||||

- [低频]本地VRM信息

|

||||

- [低频]远程VRM基本信息

|

||||

- [低频] 选项字符串

|

||||

- [低频]背景色

|

||||

- [低频]窗口属性信息

|

||||

- [低频]加载设置路径

|

||||

- 通过信息

|

||||

|

||||

### 根骨骼变换

|

||||

```json

|

||||

v2.0

|

||||

/VMC/Ext/Root/Pos (string){name} (float){p.x} (float){p.y} (float){p.z} (float){q.x} (float){q.y} (float){q.z} (float){q.w}

|

||||

|

||||

v2.1

|

||||

/VMC/Ext/Root/Pos (string){name} (float){p.x} (float){p.y} (float){p.z} (float){q.x} (float){q.y} (float){q.z} (float){q.w} (float){s.x} (float){s.y} (float){s.z} (float){o.x} (float){o.y} (float){o.z}

|

||||

```

|

||||

p=位置 q=旋转(四元数) s=MR 合成的比例 o=MR 合成的偏移

|

||||

|

||||

作为模型根的对象的绝对姿势

|

||||

名称固定为“root”。 建议将

|

||||

前半部分视为Position,后半部分视为接收侧Loal姿势的四元数(以与Bone匹配)。

|

||||

|

||||

从 v2.1 开始,添加了 MR 合成的比例。

|

||||

通过使用它,可以将虚拟人物的位置和大小调整为实际的身体尺寸。

|

||||

|

||||

### 骨骼变换

|

||||

```json

|

||||

/VMC/Ext/Bone/Pos (string){name} (float){p.x} (float){p.y} (float){p.z} (float){q.x} (float){q.y} (float){q.z} (float){q.w}

|

||||

```

|

||||

|

||||

作为模型根的对象的局部姿势名称

|

||||

是UnityEngine沿HumanBodyBones的类型名称

|

||||

前半部分是Position,后半部分是Quaternion

|

||||

|

||||

所有 HumanBodyBone 都将被发送。还包括 LastBone。 这还将传输手指运动和眼骨。

|

||||

|

||||

## UE Remote Control

|

||||

https://docs.unrealengine.com/5.1/en-US/remote-control-for-unreal-engine/

|

||||

|

||||

基于WebSocket

|

||||

|

||||

# VMC4UE的实现

|

||||

## AnimNode

|

||||

实现:

|

||||

- FAnimNode_ModifyVMC4UEBones

|

||||

- FAnimNode_ModifyVMC4UEMorph

|

||||

|

||||

![[AnimNode & VMC笔记]]

|

||||

|

||||

# VMC APP代码参考

|

||||

- [VirtualMotionCaptureProtocol](https://github.com/sh-akira/VirtualMotionCaptureProtocol)提供了最基础的实现。

|

||||

- ~~[EasyVirtualMotionCaptureForUnity](https://github.com/gpsnmeajp/EasyVirtualMotionCaptureForUnity)~~

|

||||

- ThirdParts

|

||||

- https://github.com/digital-standard/ThreeDPoseTracker

|

||||

- 逻辑在VMCPBonesSender.cs、uOscClientTDP.cs

|

||||

- BufferSize = 8192;int MaxQueueSize = 100;

|

||||

|

||||

## VirtualMotionCaptureProtocol

|

||||

Message方式:

|

||||

```c#

|

||||

void Update()

|

||||

{

|

||||

//モデルが更新されたときのみ読み込み

|

||||

if (Model != null && OldModel != Model)

|

||||

{

|

||||

animator = Model.GetComponent<Animator>();

|

||||

blendShapeProxy = Model.GetComponent<VRMBlendShapeProxy>();

|

||||

OldModel = Model;

|

||||

}

|

||||

|

||||

if (Model != null && animator != null && uClient != null)

|

||||

{

|

||||

//Root

|

||||

var RootTransform = Model.transform;

|

||||

if (RootTransform != null)

|

||||

{

|

||||

uClient.Send("/VMC/Ext/Root/Pos",

|

||||

"root",

|

||||

RootTransform.position.x, RootTransform.position.y, RootTransform.position.z,

|

||||

RootTransform.rotation.x, RootTransform.rotation.y, RootTransform.rotation.z, RootTransform.rotation.w);

|

||||

}

|

||||

|

||||

//Bones

|

||||

foreach (HumanBodyBones bone in Enum.GetValues(typeof(HumanBodyBones)))

|

||||

{

|

||||

if (bone != HumanBodyBones.LastBone)

|

||||

{

|

||||

var Transform = animator.GetBoneTransform(bone);

|

||||

if (Transform != null)

|

||||

{

|

||||

uClient.Send("/VMC/Ext/Bone/Pos",

|

||||

bone.ToString(),

|

||||

Transform.localPosition.x, Transform.localPosition.y, Transform.localPosition.z,

|

||||

Transform.localRotation.x, Transform.localRotation.y, Transform.localRotation.z, Transform.localRotation.w);

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

//ボーン位置を仮想トラッカーとして送信

|

||||

SendBoneTransformForTracker(HumanBodyBones.Head, "Head");

|

||||

SendBoneTransformForTracker(HumanBodyBones.Spine, "Spine");

|

||||

SendBoneTransformForTracker(HumanBodyBones.LeftHand, "LeftHand");

|

||||

SendBoneTransformForTracker(HumanBodyBones.RightHand, "RightHand");

|

||||

SendBoneTransformForTracker(HumanBodyBones.LeftFoot, "LeftFoot");

|

||||

SendBoneTransformForTracker(HumanBodyBones.RightFoot, "RightFoot");

|

||||

|

||||

//BlendShape

|

||||

if (blendShapeProxy != null)

|

||||

{

|

||||

foreach (var b in blendShapeProxy.GetValues())

|

||||

{

|

||||

uClient.Send("/VMC/Ext/Blend/Val",

|

||||

b.Key.ToString(),

|

||||

(float)b.Value

|

||||

);

|

||||

}

|

||||

uClient.Send("/VMC/Ext/Blend/Apply");

|

||||

}

|

||||

|

||||

//Available

|

||||

uClient.Send("/VMC/Ext/OK", 1);

|

||||

}

|

||||

else

|

||||

{

|

||||

uClient.Send("/VMC/Ext/OK", 0);

|

||||

}

|

||||

uClient.Send("/VMC/Ext/T", Time.time);

|

||||

|

||||

//Load request

|

||||

uClient.Send("/VMC/Ext/VRM", filepath, "");

|

||||

}

|

||||

|

||||

void SendBoneTransformForTracker(HumanBodyBones bone, string DeviceSerial)

|

||||

{

|

||||

var DeviceTransform = animator.GetBoneTransform(bone);

|

||||

if (DeviceTransform != null) {

|

||||

uClient.Send("/VMC/Ext/Tra/Pos",

|

||||

(string)DeviceSerial,

|

||||

(float)DeviceTransform.position.x,

|

||||

(float)DeviceTransform.position.y,

|

||||

(float)DeviceTransform.position.z,

|

||||

(float)DeviceTransform.rotation.x,

|

||||

(float)DeviceTransform.rotation.y,

|

||||

(float)DeviceTransform.rotation.z,

|

||||

(float)DeviceTransform.rotation.w);

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

Bundle将数据打包成一个Bundle,创建Bundle时会填入一个时间戳。之后

|

||||

```c#

|

||||

foreach (HumanBodyBones bone in Enum.GetValues(typeof(HumanBodyBones)))

|

||||

{

|

||||

...

|

||||

boneBundle.Add(new Message("/VMC/Ext/Bone/Pos",

|

||||

bone.ToString(),

|

||||

Transform.localPosition.x, Transform.localPosition.y, Transform.localPosition.z,

|

||||

Transform.localRotation.x, Transform.localRotation.y, Transform.localRotation.z, Transform.localRotation.w));

|

||||

...

|

||||

}

|

||||

```

|

||||

Bundle方式:

|

||||

```c#

|

||||

void Update()

|

||||

{

|

||||

//Only model updated

|

||||

if (Model != null && OldModel != Model)

|

||||

{

|

||||

animator = Model.GetComponent<Animator>();

|

||||

blendShapeProxy = Model.GetComponent<VRMBlendShapeProxy>();

|

||||

OldModel = Model;

|

||||

}

|

||||

|

||||

if (Model != null && animator != null && uClient != null)

|

||||

{

|

||||

//Root

|

||||

var RootTransform = Model.transform;

|

||||

if (RootTransform != null)

|

||||

{

|

||||

uClient.Send("/VMC/Ext/Root/Pos",

|

||||

"root",

|

||||

RootTransform.position.x, RootTransform.position.y, RootTransform.position.z,

|

||||

RootTransform.rotation.x, RootTransform.rotation.y, RootTransform.rotation.z, RootTransform.rotation.w);

|

||||

}

|

||||

|

||||

//Bones

|

||||

var boneBundle = new Bundle(Timestamp.Now);

|

||||

foreach (HumanBodyBones bone in Enum.GetValues(typeof(HumanBodyBones)))

|

||||

{

|

||||

if (bone != HumanBodyBones.LastBone)

|

||||

{

|

||||

var Transform = animator.GetBoneTransform(bone);

|

||||

if (Transform != null)

|

||||

{

|

||||

boneBundle.Add(new Message("/VMC/Ext/Bone/Pos",

|

||||

bone.ToString(),

|

||||

Transform.localPosition.x, Transform.localPosition.y, Transform.localPosition.z,

|

||||

Transform.localRotation.x, Transform.localRotation.y, Transform.localRotation.z, Transform.localRotation.w));

|

||||

}

|

||||

}

|

||||

}

|

||||

uClient.Send(boneBundle);

|

||||

|

||||

//Virtual Tracker send from bone position

|

||||

var trackerBundle = new Bundle(Timestamp.Now);

|

||||

SendBoneTransformForTracker(ref trackerBundle, HumanBodyBones.Head, "Head");

|

||||

SendBoneTransformForTracker(ref trackerBundle, HumanBodyBones.Spine, "Spine");

|

||||

SendBoneTransformForTracker(ref trackerBundle, HumanBodyBones.LeftHand, "LeftHand");

|

||||

SendBoneTransformForTracker(ref trackerBundle, HumanBodyBones.RightHand, "RightHand");

|

||||

SendBoneTransformForTracker(ref trackerBundle, HumanBodyBones.LeftFoot, "LeftFoot");

|

||||

SendBoneTransformForTracker(ref trackerBundle, HumanBodyBones.RightFoot, "RightFoot");

|

||||

uClient.Send(trackerBundle);

|

||||

|

||||

//BlendShape

|

||||

if (blendShapeProxy != null)

|

||||

{

|

||||

var blendShapeBundle = new Bundle(Timestamp.Now);

|

||||

|

||||

foreach (var b in blendShapeProxy.GetValues())

|

||||

{

|

||||

blendShapeBundle.Add(new Message("/VMC/Ext/Blend/Val",

|

||||

b.Key.ToString(),

|

||||

(float)b.Value

|

||||

));

|

||||

}

|

||||

blendShapeBundle.Add(new Message("/VMC/Ext/Blend/Apply"));

|

||||

uClient.Send(blendShapeBundle);

|

||||

}

|

||||

|

||||

//Available

|

||||

uClient.Send("/VMC/Ext/OK", 1);

|

||||

}

|

||||

else

|

||||

{

|

||||

uClient.Send("/VMC/Ext/OK", 0);

|

||||

}

|

||||

uClient.Send("/VMC/Ext/T", Time.time);

|

||||

|

||||

//Load request

|

||||

uClient.Send("/VMC/Ext/VRM", vrmfilepath, "");

|

||||

|

||||

}

|

||||

|

||||

```

|

||||

94

02-Note/DAWA/AI偶像陪伴项目/AI偶像陪伴项目笔记.md

Normal file

94

02-Note/DAWA/AI偶像陪伴项目/AI偶像陪伴项目笔记.md

Normal file

@@ -0,0 +1,94 @@

|

||||

# 各个服务负责人

|

||||

- TTS(文字=>音频)

|

||||

- 张守高

|

||||

- 动作 (文字=>动作)

|

||||

- 张渤林

|

||||

- 孙佳俊

|

||||

- 口型(音频=>表情数据)

|

||||

- 张渤林

|

||||

- 常清

|

||||

|

||||

# 存在问题

|

||||

1. 目前是否以文件的方式实现。

|

||||

2. 文字、声音、表情与动作的关联性。(主要是声音、表情与动作)

|

||||

3. 生成资产数据存在顺序依赖问题

|

||||

1. 文字 => 声音 => 表情(口型)

|

||||

2. 文字 => 动作

|

||||

|

||||

# 推流设计思路

|

||||

1. 服务器发送的数据都使用一个基于玩家发送对话生成的UUID作为时间戳(或许还需要一个**用户ID**)。

|

||||

2. 数据采用Stream式发送。动作与口型使用VMC来传输;音频使用RTMP协议来传输。其中推流模式分为2种实现:

|

||||

1. Stream式实时接受所有数据。

|

||||

2. Stream式缓存预读。

|

||||

3. 架构

|

||||

1. 根据上面说得2种模式,在服务端控制时间戳的重置(**数据截断,并且发送给客户端进行截断与时间轴统一操作**)。

|

||||

1. Puerts的Nodejs负责接收数据以及管理状态机,来管理接受的推流数据以及是否播放。(**相关核心函数写在C++中**)

|

||||

2. AIVirtualIdolServer端接受到动作数据之后,发送给AIVirtualIdol。

|

||||

3. RTMP的音频推流,AI端需要部署RTMP推流器;AIVirtualIdolServer部署RTMP Server;AIVirtualIdol接受Server数据后播放。

|

||||

|

||||

UE中的RTMP实现:

|

||||

|

||||

参考RTMP

|

||||

- RTMP协议 01 入门:https://www.jianshu.com/p/715f37b1202f

|

||||

- RTMP协议 02 视频Chunk和音频Chunk到底长啥样?:https://www.jianshu.com/p/cc813ba41caa

|

||||

- RTMP协议 03 RTMP设计思想:https://www.jianshu.com/p/9459606c2025

|

||||

- RTMP协议 04 RTMP播放基本流程:https://www.jianshu.com/p/4577a61af0c7

|

||||

- RTMP协议 05 时间戳:https://www.jianshu.com/p/119075482a54

|

||||

|

||||

## RTMP

|

||||

### Message & Chunk

|

||||

RTMP中一个重要的概念就是消息。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

**网络中实际发送的内容**。

|

||||

|

||||

|

||||

|

||||

Chunk Format

|

||||

|

||||

|

||||

Message被切割成一个或多个Chunk,然后在网络上进行发送。

|

||||

当发送时,一个chunk发送完毕后才可以发送下一个chunk。

|

||||

|

||||

|

||||

|

||||

Message被拆分成一个或多个Chunk,然后在网络上发送

|

||||

|

||||

拆分的时候,**默认的Chunk Size是128字节**,以Message大小为300字节举例,进行拆分。

|

||||

|

||||

```undefined

|

||||

300 = 128 + 128 + 44

|

||||

```

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

作者:FlyingPenguin

|

||||

链接:https://www.jianshu.com/p/715f37b1202f

|

||||

来源:简书

|

||||

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

|

||||

|

||||

|

||||

# 开发计划

|

||||

1. C++实现RecivedDataManagerComponent管理音频、口型&动作数据、文字。

|

||||

2. Puerts实现数据接收逻辑。

|

||||

3. 实现声音播放逻辑。

|

||||

4. 实现口型&动作动画节点。

|

||||

5. 实现动画状态机结构初版。

|

||||

|

||||

# 声音

|

||||

## Runtime Import Sound

|

||||

使用`RuntimeAudioImporter`插件,里面的解码使用了第三方库https://github.com/mackron/dr_libs。导入Sound使用了`UImportedSoundWave::PopulateAudioDataFromDecodedInfo()`

|

||||

|

||||

## UE的做法

|

||||

```cpp

|

||||

/*SoundStreaming->RawPCMDataSize = DataSize;

|

||||

SoundStreaming->RawPCMData = AudioData;*/

|

||||

```

|

||||

|

||||

# 表情

|

||||

在状态机里生成完成之后,通过BP_Player的接口ATF_TO_BS,传递数据到动画蓝图`NV2_Full_Skeleton_AnimBlueprint`中。之通过动画蓝图的Pose读取曲线并且播放动画。

|

||||

122

02-Note/DAWA/AI偶像陪伴项目/AI虚拟偶像陪伴 & AI虚拟直播间 开发计划与阶段目标.md

Normal file

122

02-Note/DAWA/AI偶像陪伴项目/AI虚拟偶像陪伴 & AI虚拟直播间 开发计划与阶段目标.md

Normal file

@@ -0,0 +1,122 @@

|

||||

# AI虚拟直播间需求&任务整理

|

||||

## 实现目标&内容&工期

|

||||

>拿给EOE老板看的Demo版本

|

||||

|

||||

1. 控制AI行为以及数据交互的导播台应用(Electron + Server)

|

||||

1. 实现目标

|

||||

1. =>AI服务器

|

||||

1. 能够发送文字、语音数据以及其他指令到AI服务器。

|

||||

2. 能够接收文字、音频、CSV、FBX数据。

|

||||

2. =>渲染机器

|

||||

1. 能够转发音频、CSV、FBX数据到渲染机中。

|

||||

2. 实现内容:基础Electron用户界面以及对应的Server(第一版放在一起后续分离),工期 2周左右。

|

||||

1. 转发数据逻辑

|

||||

2. 用户界面

|

||||

3. 未来TODO:

|

||||

1. 自定VMC协议用来传输音频等其他数据

|

||||

2. 渲染机(UE插件)

|

||||

1. 导播台应用=>

|

||||

1. 制作角色蓝图、动画蓝图以及状态机,可以播放音频、CSV、FBX。

|

||||

2. 接收导播台(AI服务器的控制指令)

|

||||

2. 实现内容:编写插件实现对应的数据接收节点。

|

||||

|

||||

- 闲时模式

|

||||

- 循环动画+随机动画

|

||||

- 语音模式(说话与唱歌)

|

||||

- 说话

|

||||

- 表情、口型、声音、身体动作(Gesture)

|

||||

- 唱歌(N套预先录制)

|

||||

- 表情、口型、声音、身体动作(Gesture)

|

||||

- 指令模式

|

||||

- 文字输入

|

||||

- 跳舞

|

||||

- 动作

|

||||

- AI数据混合

|

||||

|

||||

需要的资产:

|

||||

1. N套预制唱歌资产

|

||||

2. 闲时模式的相关资产

|

||||

|

||||

## 状态机设计

|

||||

1. 相关数据都存储在角色类AAIVirtualIdolCharacter中。

|

||||

1. Idol状态相关控制数据。

|

||||

2. 实时 - 表情指令的预制渐入渐出曲线以及表情文件。

|

||||

2. EOE歌曲可以制作专门的UDataAsset,以方便播放。

|

||||

|

||||

### 状态

|

||||

- 可切换状态:待开发功能,后续的AI偶像陪伴项目会需要。

|

||||

- 不可切状态(必须等到当前状态执行完,才能执行其他Action,并且执行完后会回到Idol状态)

|

||||

- 播放状态(预制资产)。角色开始唱歌&跳舞,可以选择只跳舞。

|

||||

- 聊天状态(AI实时生成)。角色做出语音、动作、表情&口型。

|

||||

|

||||

### 指令

|

||||

- 实时指令:用于即使切换角色面部表情&口型或者播放一些场景效果。一般不会改变与打断当前状态。

|

||||

- [ ] 表情系列指令(预制表情)

|

||||

- [ ] 微笑

|

||||

- [ ] 皱眉

|

||||

- 强制指令:用于导播强制中断有问题的表演。

|

||||

- [x] 强制进入Idle状态。

|

||||

- 状态切换指令:待开发功能,后续的AI偶像陪伴项目会需要。用于定制当前状态完成后执行的下一个状态;可以打断当前状态并开始执行下一个状态。

|

||||

|

||||

## 资产制作

|

||||

### 歌曲

|

||||

1. 动捕Motion&Facial FBX

|

||||

2. 歌曲音频

|

||||

|

||||

# AI虚拟偶像陪伴

|

||||

## 阶段技术需求 & 实现目标

|

||||

### 第零阶段(快速简历可供AI迭代的基础程序)

|

||||

1. Express Http服务器。

|

||||

1. 提供静态文件下载服务。

|

||||

2. 建立一个获取所有Uasset文件的url。

|

||||

2. UE客户端

|

||||

1. 动画蓝图中建立多个子AnimGraph,使用动态方式挂载。

|

||||

|

||||

### 第一阶段(建立高可用、迭代性的基础架构)

|

||||

需求功能(优先&难易度排序):

|

||||

1. 资产 & 逻辑脚本热更新逻辑 => Puerts热更新逻辑。

|

||||

2. 客户端发送文字信息给服务端。=> 构建一个Http聊天服务器。

|

||||

3. 服务端控制虚拟角色行为 => ~~RPC事件同步~~ Http服务器WebSocket连接Puerts间接控制方案。**后续可能需要改成帧同步方案**。

|

||||

4. 客户端在动画蓝图中实时混合**新下载**的**动画资产**。

|

||||

5. 客户端在动画蓝图中实时混合**实时推流**的**动画数据**,以及播放**AI生成语音**。

|

||||

|

||||

#### 技术细节

|

||||

- 客户端:

|

||||

- 使用Puerts控制逻辑。

|

||||

- 使用Puerts热更新逻辑 & 资产。

|

||||

- 使用下载Pak,重启后批量读取方案。

|

||||

- 使用ModuleGameFeature框架进行网络缓存的方案。(堡垒之夜目前使用)

|

||||

- 使用Puerts宿主环境(Nodejs)构建Http服务,以此与服务端通信。(优点是不会卡住游戏线程)

|

||||

- IOS得进行测试,是否可以使用这个方案。

|

||||

- * 实现 **动画数据**推流功能。

|

||||

- 服务端:客户端同步采用事件同步 + 缓存动画数据的方式实现

|

||||

- Demo期间使用Nodejs进行打底。采用Nodejs + Express搭建,后台管理页面采用VUE3。

|

||||

- 序列化使用 Protobuf

|

||||

- RPC协议:gRPC ?

|

||||

- Http聊天服务器。

|

||||

- 账号权限判断。

|

||||

- Pak文件 / ModuleGameFeature缓存方案所用的文件服务器。

|

||||

- 文件上传功能(语音数据)。

|

||||

- * 实现 **动画数据**推流功能。

|

||||

|

||||

使用其他框架?

|

||||

- https://github.com/node-pinus/pinus

|

||||

|

||||

#### 现阶段问题:

|

||||

我需要知道:

|

||||

1. 玩家发送文字信息后,虚拟角色是否会发出语音?

|

||||

2. AI如何对虚拟角色行为树进行迭代?仅仅是迭代行为树中的某一个行为么?

|

||||

3. 如何针对某一个演员的指定行为进行迭代?录制一定的演员表演动作动画数据进行迭代?

|

||||

|

||||

### 第二阶段(使用借助AI配合UE动画系统迭代动画效果)

|

||||

需求功能(优先&难易度排序):

|

||||

1. 构建一个可以不断热更、优化(AI系统迭代动画资产)的动画框架。

|

||||

1. MotionMarching

|

||||

2. Motion匹配。

|

||||

2. 游戏性提升。

|

||||

|

||||

# 其他资料

|

||||

- Node-Pinus游戏服务器框架:https://github.com/node-pinus/pinus

|

||||

- 案例:https://github.com/node-pinus/pinus/tree/master/examples/simple-example

|

||||

- Pomelo的wiki:https://github.com/NetEase/pomelo/wiki/Home-in-Chinese

|

||||

- Nodejs RPC:https://zhuanlan.zhihu.com/p/598460945

|

||||

18

02-Note/DAWA/DAWA.md

Normal file

18

02-Note/DAWA/DAWA.md

Normal file

@@ -0,0 +1,18 @@

|

||||

# DAWA Overview

|

||||

```ccard

|

||||

type: folder_brief_live

|

||||

imagePrefix: '08-Assets/Images/BingWallpaper'

|

||||

noteOnly: false

|

||||

style: card

|

||||

```

|

||||

[[柔体模拟开发计划]]

|

||||

[[UE卡通渲染改进]]

|

||||

|

||||

# 流程架设计划

|

||||

1. 共享DDC

|

||||

2. 推广Lyra的UEditorValidator Asset有效性检测插件。

|

||||

3. 联机编译Shader

|

||||

4. DDNS 与 远程

|

||||

5. NAS 网盘

|

||||

6. 版本管理系统 PlasticSCM 与 Perforce

|

||||

7. UnrealGameSync 以及 CI/CL系统

|

||||

8

02-Note/DAWA/InHouse插件/场景检查与设置预设插件.md

Normal file

8

02-Note/DAWA/InHouse插件/场景检查与设置预设插件.md

Normal file

@@ -0,0 +1,8 @@

|

||||

|

||||

## 参数检查

|

||||

### 灯光

|

||||

- [ ] 开启RayTracing之后检查所有Map的SpotLight、RectLight、SkyLight、DirectionalLight(Angle较大时)的采样值。

|

||||

|

||||

## 参数预设与参数文档

|

||||

- [ ] MovieRenderQueue的预设以及相关参数文档

|

||||

- [ ] TAA相关的参数文档

|

||||

92

02-Note/DAWA/MUTools/MUTools笔记.md

Normal file

92

02-Note/DAWA/MUTools/MUTools笔记.md

Normal file

@@ -0,0 +1,92 @@

|

||||

## MUTools Maya部分笔记

|

||||

1. AddMesh()

|

||||

2. SendCommand()

|

||||

|

||||

### 导入Maya文件命令Mel

|

||||

>file -f -o "C:/Users/admin/Desktop/test.mb";

|

||||

|

||||

### Maya插件获取场景数据

|

||||

DBU_ScenePrimitiveCollector::AssembleData,具有2个分支UpdateOutline与CollectFeedback同时负责序列化:

|

||||

|

||||

1. AdditionalMessage

|

||||

2. 写入文件头(虽然这个写入步骤在UpdateOutline之后,但在写Outline数据时偏移了sizeof(UPDATEMSG))

|

||||

3. UpdateOutline

|

||||

1. OutlineEntityList

|

||||

1. NameStream中每个节点名称字符串的偏移

|

||||

2. ChildNode数目

|

||||

2. UPDATEMSG MSGHEAD 文件头信息。

|

||||

3. NameStream 存储每个节点名称的流

|

||||

4. CollectFeedback

|

||||

1. UpdateEntityList

|

||||

2. MeshStream->AddrList

|

||||

3. MeshStream->ByteStream

|

||||

|

||||

UE中的反序列化,根据文件头信息的HasOutline与HasFeedbackData,有以下两个分支:

|

||||

|

||||

1. 读取文件头信息

|

||||

2. HasOutline

|

||||

1. OutlineRootData

|

||||

2. OutlineData

|

||||

3. NamesData 节点名称流

|

||||

3. HasFeedbackData

|

||||

1. NamesData

|

||||

2. UpdateEntities

|

||||

3. AddrList

|

||||

|

||||

### 更新大纲Mesh数据

|

||||

UpdateOutline只有Maya大纲的名称与当前节点的子节点数目数据。其他模型信息集中在CollectFeedback阶段。

|

||||

|

||||

DBU_AddMesh来管理列表(监视每个Mesh状态),如果entity的meshDirty=true则将其加入`vector<MeshAndID> MeshList`。最后使用

|

||||

|

||||

```c++

|

||||

MeshStream = new AssembleMeshStream(MeshList);

|

||||

```

|

||||

来生成这个MeshStream。(来进行顶点、UV、法线、顶点处理)

|

||||

|

||||

```c++

|

||||

bool DBU_ScenePrimitiveCollector::AssembleData(MString& Result,vector<char> &ByteStream, bool CollectFeedback,bool UpdateOutline, MString AdditionalMessage)

|

||||

{

|

||||

MStatus status;

|

||||

//if (DBU_AddMesh::First == nullptr)

|

||||

// CollectFeedback = false;

|

||||

if (CollectFeedback)

|

||||

{

|

||||

std::chrono::steady_clock::time_point _start_time = std::chrono::steady_clock::now();

|

||||

DBU_AddMesh::LastSentUpdateList.clear();

|

||||

DBU_AddMesh* curr = DBU_AddMesh::First;

|

||||

while (curr)

|

||||

{

|

||||

curr->CollectEntity();

|

||||

auto Next = curr->Next;

|

||||

curr = Next;

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

DBU_AddMesh::CollectEntity()

|

||||

|

||||

|

||||

DBU_AddMesh节点在连接时候,将srcPlug的DAG路径加入NodeRegisteredDAGPaths。

|

||||

|

||||

MPlug & srcPlug->MObject FromWhat->MFnDagNode FromNode->MDagPath dagPath

|

||||

|

||||

|

||||

### MUTools UE

|

||||

通过MeshList的Index进行同步。

|

||||

|

||||

|

||||

点击Outline Import后的逻辑 为发送遍历Entiry ,并且发送Mel:

|

||||

|

||||

$indices = { XXXX };

|

||||

|

||||

{

|

||||

int $i;

|

||||

for($i=0;$i<size($indices);$i++)

|

||||

{

|

||||

DBU_AddSynchronize(DBU_GetSentOutlinerEntityPath $indices[$i]);

|

||||

}

|

||||

}

|

||||

print `lsType "DBU_AddMesh"`;

|

||||

|

||||

|

||||

调用DBU_AddSynchronize(DBU_GetSentOutlinerEntityPath)节点

|

||||

644

02-Note/DAWA/Old/BH3音乐会场景优化.md

Normal file

644

02-Note/DAWA/Old/BH3音乐会场景优化.md

Normal file

@@ -0,0 +1,644 @@

|

||||

# 有待改进的地方

|

||||

1. 角色卡通渲染:建议之后自研卡通渲染引擎。

|

||||

2. DMX Light Beam性能问题。

|

||||

3. 因为成片后续会进行重新渲染,建议编写一个插件 记录UE各种事件(录像功能)+记录摄像机轨迹,方便后期进行操作。

|

||||

|

||||

# 优化记录

|

||||

## DMX

|

||||

渲染模型&材质:

|

||||

- SM_Strobe_Lens M_MI_Lens_Strobe:不透明材质,指令数254

|

||||

- SM_Beam_RM M_Beam_Master:

|

||||

- BP_StaticMatrix M_MatrixBeam_Master

|

||||

|

||||

### Beam材质

|

||||

变量:

|

||||

- NSlice:NearPlane 交点世界坐标

|

||||

- NDepth:

|

||||

- FSlice:FarPlane 交点世界坐标

|

||||

- FDepth:

|

||||

|

||||

MF_WSIntersection:如果没有相交,RelIntersectPos为,IntersectDistance为。

|

||||

|

||||

|

||||

### 优化方案

|

||||

1. DMX模型改成StaticMeshInstance,Gun的模型是Masked,建议改成不透明。

|

||||

2. 关闭DMX灯光中的照明效果,因为不会对着模型照明。

|

||||

1. 场景中的组件勾选**Disable Lights**

|

||||

3. StaticMeshLens 组件可以按照距离进行关闭。(BP_StaticStrobe_C、BP_MovingHead_C)

|

||||

1. 场景中的组件中的StaticMeshLens去掉**Visible**。

|

||||

2. Sequence中手动设置**Visible**。

|

||||

4. Beam材质

|

||||

1. 给BeamRayMarch的DMX Max Light Distance 乘上一个变量倍率,之后适当减少DMX Max Light Distance大小,建议的倍率为1.2~1.5,长度为1/1.2~1/1.5; 给BeamRayMarch的DMX Zoom 乘上一个变量倍率,Zoom 5=>4.5~3,并且将倍率调整成合适数值。

|

||||

2. 调整Zoom Quilty 1=>1.5~2,并且适当调整DMX Lens Radius的数值,减少断点问题。

|

||||

5.

|

||||

|

||||

## 优化目标

|

||||

XR 2k 2048*1080 50帧 => 3440 * 1440 50帧0

|

||||

|

||||

## 优化场景

|

||||

E:\Project\yanjingdan\BengHuai\Ture\Content\UnWorld\BengHuai_True\Maps

|

||||

E:\Project\yanjingdan\BengHuai\L_Dacapo\content\UnWorld\BengHuai_Dacapo\Maps\L_Dacapo5.umap

|

||||

E:\Project\yanjingdan\BengHuai\BengHuai\Content\UnWorld\BengHuai_Tiantai\Maps\L_BengHuai_Tiantai.umap

|

||||

|

||||

步骤:

|

||||

1. 场景静态模型设置成Nanite,以下模型需要额外考虑是否开启Nanite:

|

||||

1. 带有世界位移与Masked的模型,比如花 草 模型。

|

||||

2. 将一些不会动的模型都设置成Static。

|

||||

3. 告知拍摄镜头需求,是全景还是需要360°都有拍摄要求。

|

||||

4. 确定场景之后不会进行改动之后,使用MergeActor将模型中的相同材质进行合并,将场景中的静态模型设置成Instance。

|

||||

|

||||

### L_BengHuai_Tiantai

|

||||

问题:

|

||||

~~1. 模型问题

|

||||

1. 目前比较大的问题在于模型较多、面数较高且场景静态模型没有设置成Nanite。使得剔除与BasePass渲染延迟过高。~~

|

||||

|

||||

#### Model

|

||||

~~1. 场景中大量巨大无异议的球,名字为:Sphere~SphereX~~

|

||||

~~2. 图元较多的关卡

|

||||

1. L_Main_AllCity_Chengbao_2~~

|

||||

|

||||

- dd_polySurface

|

||||

- BookOpen

|

||||

- Box001~Box003

|

||||

-

|

||||

|

||||

#### Light&Shadow

|

||||

1. SpotLightDingGuang

|

||||

1. 去掉Cast Shadow(只影响台阶的阴影)

|

||||

2. 勾选Distance Field Shadows。

|

||||

2. RectLight 81~93:

|

||||

1. 去掉Cast Shadow。

|

||||

2. 将其替换成SourceLength 匹配的PointLight。

|

||||

3. 将其他面光源替换成点光源或者聚光灯(可以减少0.1~0.2ms,优先级低)。

|

||||

|

||||

#### Translucent

|

||||

1. 修改EasyFog的材质(大纲搜索EasyFog),从Translucent=>Additive。并且重新调整亮度。

|

||||

2. 大纲搜索EnvEmitter,调整大小并使用Cutoff工具对齐进行裁剪。(覆盖范围过大)。修改材质MI_Env_Inst~MI_Env_Inst22,从Translucent=>Additive。并且重新调整亮度。

|

||||

|

||||

#### 2023.6.5优化建议

|

||||

1. 舞台观众、荧光棒去掉CastShadow,同时考虑使用Nanaite

|

||||

2. 浮游炮材质重Masked=>不透明

|

||||

3. 烟花材质重Translucent=>Additive

|

||||

|

||||

4. Sequence进入舞台镜头时对看不见的建筑物进行隐藏操作。

|

||||

5. 主舞台所有模型进行Merge,并且设置成Nanite。

|

||||

6. 主舞台DMX灯光开启DisableLight。

|

||||

7. 调整Lumen渲染参数或者后处理盒子参数:

|

||||

- Lumen Scene Lighting Quality: 2 =>0.25

|

||||

- Lumen Scene Detail:4=>1

|

||||

- Lumen Scene View Distance:20000=>1000~3000

|

||||

- Max Trace Distance:20000=>1000~3000

|

||||

|

||||

### L_Dacapo5

|

||||

问题:

|

||||

1. 模型问题

|

||||

1. 模型较多、面数较高且场景静态模型没有设置成Nanite。使得剔除与BasePass渲染延迟过高。

|

||||

2. 花草不是Instance

|

||||

3. 花卉、草的的材质有优化空间。

|

||||

2. 阴影

|

||||

1. 有2个方向光投射阴影,关闭其中一个。并且使用距离场阴影。

|

||||

3. Lumen

|

||||

1. 设置Lumen参数,去除草地对GI的计算。

|

||||

4. 天空上的透明体积雾效果

|

||||

|

||||

BasePass渲染延迟较高的模型:

|

||||

HUABAN_toon hua 123 instances 19501-19515 4775.936

|

||||

grass0 hua 123 instances 19481-19489 4387.84

|

||||

MI_grass_01_Inst_gbl SM_grass_01_gbl_lv 31 instances 14016-14025 2996.224

|

||||

HUABAN_PINK_toon1 hua_pink 35 instances 15286-15291 1172.416

|

||||

grass0 hua_pink 35 instances 19491-19499 1107.968

|

||||

HUAXIN_toon_toon1 hua 123 instances 15266-15274 572.416

|

||||

MM_Grass HUA002 2 instances 14405-14415 440.32

|

||||

M_plants SM_sf_flower_05 13548-13551 193.536

|

||||

M_plants SM_sf_flower_05 13739-13742 191.488

|

||||

M_plants SM_sf_flower_05 13734-13737 167.936

|

||||

HUAXIN_toon_toon1 hua_pink 35 instances 15276-15284 164.832

|

||||

M_plants SM_sf_flower_05 13669-13672 128.00

|

||||

M_plants SM_sf_flower_05 3 instances 13664-13667 124.928

|

||||

|

||||

### L_True

|

||||

1. 模型问题

|

||||

1. Nanite与Instance(主要是电视机)

|

||||

2. VolumetricSpotlightEngine 是拿来干什么的?

|

||||

3. 灯光

|

||||

1. 关闭投射阴影(尤其是点光源,包括天光)

|

||||

1. 天光

|

||||

2. SpotLight11

|

||||

3. SpotLight12

|

||||

4. SpotLight2

|

||||

5. DirectionalLight

|

||||

6. PointLight1~6

|

||||

2. 调整灯光投射范围(有一些太远了)

|

||||

4. 13_Mat_DianShiJi14 贴花看不出有什么作用。

|

||||

5. 黑色遮罩的几个Plane是干什么的

|

||||

6. 中间的几个透明片删掉

|

||||

7. 中间数据库的材质重Tranlucent => Additive

|

||||

8. 几个透明的粒子效果将材质从Tranlucent => Additive( 鬼影问题很大)

|

||||

|

||||

BasePass渲染延迟较高的模型:

|

||||

monitorE_col_High_A_Mat2 monitorE_High_Geo_Grp 90 instances 12336-12351 2444.288

|

||||

TTest monitorE_High_Geo_Grp 28 instances 12006-12014 761.856

|

||||

monitorE_col_High_A_Mat2 monitorE_High_Geo_Grp 12 instances 12353-12357 337.92

|

||||

monitorE_col_High_A_Mat monitorE_High_Geo_Grp 11 instances 12837-12852 308.224

|

||||

monitorF_col_high_A_Mat monitorF_High_Geo_Grp 107 instances 12870-12884 197.632

|

||||

TTest monitorE_High_Geo_Grp 6 instances 11961-11969 183.296

|

||||

monitorG_col_High_A_Mat3 monitorG_High_Geo_Grp 66 instances 11542-11552 159.7

|

||||

monitorA_col_High_Mat3 monitorA_High_Geo_Grp 168 instances 12576-12590 153.536

|

||||

monitorD_col_High_A_Mat monitorD_High_Geo_Grp 27 instances 12283-12297 135.168

|

||||

monitorG_col_High_A_Mat1 monitorG_High_Geo_Grp 47 instances 11448-11480 115.648

|

||||

|

||||

## L_XBLA xiubolian(休伯利安)

|

||||

1. 移除没有明显投影效果的灯光。

|

||||

2. 重写DMX插件,CPU GPU 负载压力较大。

|

||||

3. Separate Translucency:去除勾选。

|

||||

|

||||

### 模型优化

|

||||

1. 将场景中的静态模型都设置成Nanite。

|

||||

2. 将BP_FeiChuan模型进行合并。

|

||||

3. 如果飞船模型如果需要CastShadow则需要在模型里勾选Generate Distance Field。

|

||||

|

||||

#### xbla

|

||||

开启Nanite,以及勾选Generate Distance Field。

|

||||

MininumResidency:2MB

|

||||

Fallback Relative Error:1.0=> 0.1~0.0

|

||||

|

||||

#### 关闭FeiChuang蓝图中StaticMesh的Shadow

|

||||

|

||||

### Light&Shadow

|

||||

- [ ] 远处的几个小飞船 去掉CastShadow选项。

|

||||

|

||||

- DirectionalLight

|

||||

- Num Dynamic Shadow Cascades:5=>3

|

||||

- Dynamic Shadow Distance MovableLight:20000=>5000

|

||||

- DistanceField Shadow Distance:51200=>5000

|

||||

- Shadow Resolution Scale:1=>0.1~0.5

|

||||

- SpotLight3

|

||||

- 关闭CastShadow(3与4至少关一个)

|

||||

- Attenuation Radius:11052.831055=> 2040

|

||||

- Shadow Resolution Scale:1=>0.5

|

||||

- 第二次修改

|

||||

- Outer Cone Angle 44=>40

|

||||

- Shadow Resolution Scale:0.5=>0.3

|

||||

- SpotLight4

|

||||

- 关闭CastShadow(3与4至少关一个)

|

||||

- Attenuation Radius:12052.831055=>4000.0

|

||||

- 点光源

|

||||

- 关闭阴影

|

||||

- 降低Attenuation Radius到合适范围。

|

||||

- 删除机翼处重新的点光源,pointLight81

|

||||

|

||||

### Lumen

|

||||

调整Lumen渲染参数或者后处理盒子参数:

|

||||

Lumen Scene Lighting Quality: 2 =>1

|

||||

Lumen Scene Detail:4=>1

|

||||

Lumen Scene View Distance:20000=>5000

|

||||

Max Trace Distance:20000=>5000

|

||||

|

||||

### Translucent

|

||||

#### Nebula

|

||||

以下几个建议删除:

|

||||

BP_NebulaProceduralGenerator

|

||||

BP_NebulaProceduralGenerator2

|

||||

BP_NebulaProceduralGenerator3N

|

||||

BP_NebulaProceduralGeneratorMove

|

||||

BP_NebulaProceduralGeneratorMove2

|

||||

|

||||

- BP_NebulaProceduralGenerator5

|

||||

- Volumetric Sphere Amount:10=>1~5(推荐1)

|

||||

- 效果会大变

|

||||

- Min Sphere Radius (Km):0.25=> 0.1~0.2

|

||||

- Max Sphere Radius (Km):0.75=> 0.6~0.7

|

||||

- BP_NebulaProceduralGenerator6

|

||||

- Volumetric Sphere Amount:10=>1~3(推荐1)

|

||||

- Quality:Hight => Low~Medium

|

||||

- 效果会大变

|

||||

- Min Sphere Radius (Km):0.25=> 0.1~0.2

|

||||

- Max Sphere Radius (Km):0.75=> 0.6~0.7

|

||||

|

||||

远景星云考虑使用SceneCapture渲染出来,再贴到一个片上。

|

||||

|

||||

#### StarCluster

|

||||

建议使用Niagara重做一个透明区域太多了。

|

||||

|

||||

## Domineer_Showcase

|

||||

Sequence:Seq_Seq_Domin_XR

|

||||

鬼影问题:

|

||||

1. 修改材质,从Masked=> Translucent,并且开启材质的Responsive AA。

|

||||

|

||||

## NightGlow

|

||||

### ~~CustomDepth~~

|

||||

- MI_Icelandic_Rock_Cliff_ucdmcawdy_4K_Inst2_Normal

|

||||

|

||||

没有特殊需要,把PostProcessing-Custom Depth-Stencil Pass改成Disable。

|

||||

|

||||

### Shadow

|

||||

- ~~SpotLight ~~

|

||||

- ~~SpotLight2 ~~

|

||||

- ~~SpotLight4

|

||||

- ~~geogrp29下面的灯~~

|

||||

- stone_Anim2

|

||||

|

||||

CasShadow关了。

|

||||

|

||||

### ~~Lumen~~

|

||||

- Lumen Scene Lighting Quality: 1=>0.25

|

||||

- Lumen Scene View Distance:20000=>1000

|

||||

- Max Trace Distance:20000=>1000

|

||||

|

||||

或者考虑换成烘焙阴影(不太合适)。

|

||||

|

||||

### Nanite

|

||||

特效Mesh:

|

||||

~~- NS_Storns

|

||||

- SM_Strom_piece_1884

|

||||

- SM_Strom_piece_1875

|

||||

- SM_Strom_piece_1900~~

|

||||

|

||||

### 场景模型控制 & WuTai破碎

|

||||

- 在舞台模型出现后,使用Sequence将wutai破碎下面的破碎模型都隐藏了。

|

||||

- 将外部六棱柱与内部六棱柱分开导出,并将内部六棱柱转换成Instance Static Mesh。

|

||||

- 使用StaticMesh替换Landscape。

|

||||

|

||||

### 透明物体

|

||||

- EasyFog材质从Translucent=>Additive

|

||||

- SM_Cloud_Single的材质从Translucent=>Additive

|

||||

- geogrp的NewMaterial1_Inst从Translucent=>Additive

|

||||

|

||||

### 2023.6.11

|

||||

- GameThread 13.4ms

|

||||

- ~~WorldTick (4.3ms =>3)~~

|

||||

- ~~进地形改成StaticMesh,选中地形,File => Selected (1.3ms)~~

|

||||

- ~~减少NiagaraActor数量。~~

|

||||

- RenderThread 43.1ms

|

||||

- InitViews 9.8ms

|

||||

- GatherDynamicMeshElements 7.4 ms

|

||||

|

||||

#### 理论上WuTai优化极限

|

||||

- 关闭光线追踪

|

||||

- 体积云参数调节

|

||||

-

|

||||

|

||||

删除模型测试:

|

||||

- 原始状态延迟:29~32

|

||||

- 删除WuTai FbxScene_zhuzi 21~22

|

||||

- 删除FbxScene_zhuzi2~8 28~30

|

||||

- WuTai 全部删除 23~25

|

||||

- Wutai1 几乎没有变化

|

||||

- Wutai2 26~28

|

||||

- Wutai3 26~28

|

||||

|

||||

替换模型之后:19~21ms

|

||||

|

||||

|

||||

##### 可以Instance的WuTai网格

|

||||

删除以下网格并且使用 替换

|

||||

- piece_0

|

||||

- piece_1

|

||||

- piece_2**

|

||||

- piece_4**

|

||||

- piece_6**

|

||||

- piece_7

|

||||

- piece_8

|

||||

- piece_9

|

||||

- piece_10**

|

||||

- piece_13**

|

||||

- piece_14

|

||||

- piece_15**

|

||||

- piece_18**

|

||||

- piece_21**

|

||||

- piece_23**

|

||||

- piece_24

|

||||

- piece_25

|

||||

- piece_26**

|

||||

- piece_28**

|

||||

- piece_29

|

||||

- piece_30

|

||||

- piece_31

|

||||

- piece_32**

|

||||

- piece_35**

|

||||

- piece_36**

|

||||

- piece_38**

|

||||

- piece_40**

|

||||

- piece_41

|

||||

- piece_42**

|

||||

- piece_45**

|

||||

- piece_46

|

||||

- piece_47

|

||||

- piece_48**

|

||||

- piece_51**

|

||||

- piece_53**

|

||||

- piece_54**

|

||||

- piece_56**

|

||||

- piece_57

|

||||

- piece_58

|

||||

- piece_59

|

||||

- piece_60

|

||||

- piece_61

|

||||

- piece_62**

|

||||

- piece_64**

|

||||

- piece_65

|

||||

- piece_66

|

||||

- piece_67

|

||||

- piece_68

|

||||

- piece_69

|

||||

- piece_70

|

||||

- piece_71

|

||||

- piece_72

|

||||

- piece_73

|

||||

- piece_74

|

||||

- piece_75

|

||||

- piece_76

|

||||

- piece_77

|

||||

- piece_78**

|

||||

- piece_81**

|

||||

- piece_82**

|

||||

- piece_84**

|

||||

- piece_85

|

||||

- piece_86

|

||||

- piece_87

|

||||

- piece_88

|

||||

- piece_89

|

||||

- piece_90**

|

||||

- piece_93**

|

||||

- piece_94**

|

||||